Eche un vistazo a los blogs de la categoría Búsqueda vectorial. Obtenga más información sobre las mejores prácticas de búsqueda vectorial: interacción con los LLM de IA y mucho más.

Categoría: Búsqueda vectorial

Disponibilidad general del SDK de C++ para Couchbase

Esta versión añade compatibilidad con el lenguaje nativo C++ a nuestro completo conjunto de bibliotecas SDK en 11 lenguajes de programación y marca un hito importante

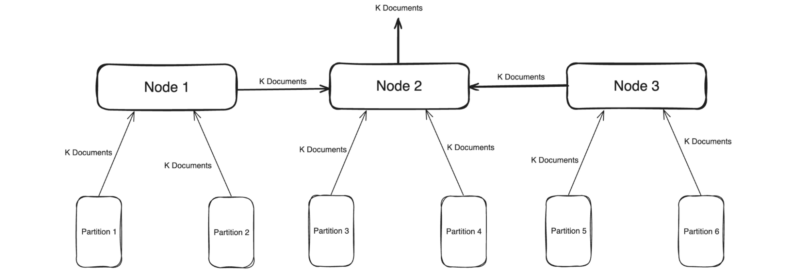

Mejora de la privacidad y el rendimiento de GenAI: El futuro de la IA personalizada con bases de datos vectoriales de aristas

Este artículo se centra en el paradigma de la computación centralizada frente a la computación periférica, y analiza por qué una base de datos de la nube a la periferia con capacidad vectorial es la que mejor abordará los retos de la privacidad de los datos, el rendimiento y la rentabilidad.

Desarrollar aplicaciones RAG de alto rendimiento con Couchbase y Vectorize

Los equipos de Couchbase y Vectorize han estado trabajando duro para llevar el poder de los experimentos de Vectorize a Couchbase Capella.

Cómo las aplicaciones adaptables desbloquean la innovación en la nueva era de la IA

Las aplicaciones adaptativas utilizan la IA para adaptarse de forma inteligente, dinámica y automática a las circunstancias cambiantes y a las preferencias de los usuarios.

Couchbase Capella™ gana dos premios en los Stevie American Business Awards 2024

Couchbase ha introducido recientemente la búsqueda vectorial en Capella para ayudar a las organizaciones a sacar al mercado una nueva clase de aplicaciones que son adaptables y atraen a los usuarios de forma hiperpersonalizada y contextualizada.

Vectores de consulta y lo que puede fallar con ellos

Para realizar las mejores búsquedas vectoriales, hay que tener en cuenta las consultas lentas causadas por índices ineficaces, consultas ineficientes o datos que cambian con frecuencia, etc.

Búsqueda híbrida: Una visión general

Esta entrada de blog explica qué es la búsqueda híbrida y cómo funciona. Aprende cómo Couchbase puede ayudarte a incorporarla (y sus beneficios) en tus aplicaciones.

Creación de aplicaciones de IA reales en el hackathon de IA de Beeloud y Build 2024

Para este evento, más de 200 personas se reunieron en Vancouver, Londres y prácticamente en todo el mundo, incluidos desarrolladores, arquitectos, diseñadores, gestores de productos y comercializadores de productos.

Aplicaciones de IA orientadas al cliente

Las aplicaciones de cliente 360, a menudo basadas en bases de datos NoSQL y tecnología de IA, reciben muchos nombres: vista única, registro de oro, fuente de la verdad, etc., y todas ellas hacen referencia a la necesidad de tener una visión de 360 grados del cliente para proporcionarle información significativa, oportuna y atractiva.

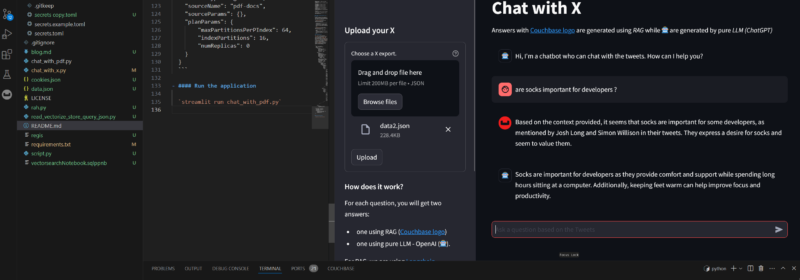

Twitter Thread tl;dr ¿Con IA? Parte 2

Construir una aplicación Streamlit que utiliza LangChain y Vector Search para datos JSON tomados de Twitter e indexados en la base de datos NoSQL Couchbase para Chat interactivo.

Rendimiento de la búsqueda vectorial: El aumento de la recuperación

Como el equilibrio entre memoria y latencia es crucial en la búsqueda vectorial, queríamos que el usuario tuviera cierta flexibilidad a la hora de inclinarse.

Twitter Thread tl;dr ¿Con IA? Parte 1

Descubre cómo Couchbase Vector Search puede habilitar la arquitectura RAG a través de un ejemplo real: resumir un hilo de Twitter con un LLM.

Top Posts

- La nueva analítica empresarial lleva la nueva generación de...

- Integrar la inferencia LLM rápida de Groq con el vector Couchbase...

- Métodos de análisis de datos: Técnicas cualitativas frente a cuantitativas

- Explicación del modelado de datos: Conceptual, físico y lógico

- ¿Qué son los modelos de incrustación? Una visión general

- Servicio Modelo Capella: Seguro, escalable y compatible con OpenAI

- Couchbase presenta Capella AI Services para agilizar el desarrollo d...

- Building an AI Agent with Couchbase MCP and cagent

- Arquitectura de alta disponibilidad: Requisitos y buenas prácticas...