O pré-processamento de dados é uma etapa essencial do aprendizado de máquina que transforma dados brutos e confusos em um formato limpo e estruturado para o treinamento do modelo. Ele envolve a limpeza, a transformação, a codificação e a divisão dos dados para melhorar a precisão do modelo, evitar o vazamento de dados e garantir a compatibilidade com os algoritmos. Embora muitas vezes seja confundido com a limpeza de dados, o pré-processamento abrange um conjunto mais amplo de tarefas essenciais para pipelines confiáveis de aprendizado de máquina. O uso de ferramentas como Pandas, Scikit-learn e Apache Spark ajuda a simplificar esse processo, tornando-o escalável e eficaz em projetos de diferentes tamanhos e complexidades.

O que é o pré-processamento de dados no aprendizado de máquina?

O pré-processamento de dados no aprendizado de máquina refere-se às etapas realizadas para limpar, organizar e transformar dados brutos em um formato que os algoritmos de aprendizado de máquina possam usar com eficiência. Os dados do mundo real costumam ser confusos porque incluem valores ausentes, formatos inconsistentes, outliers e recursos irrelevantes. Sem o pré-processamento adequado, até mesmo os modelos mais sofisticados de aprendizado de máquina podem ter dificuldades para encontrar padrões ou podem produzir resultados enganosos.

O pré-processamento eficaz de dados não apenas melhora a precisão e a eficiência dos modelos de AM, mas também ajuda a descobrir insights mais profundos ocultos nos dados. Ele estabelece a base para qualquer projeto de ML bem-sucedido, garantindo que os dados de entrada sejam de alta qualidade, consistentes e relevantes.

Pré-processamento de dados vs. limpeza de dados

Embora o pré-processamento e a limpeza de dados sejam frequentemente usados de forma intercambiável, eles se referem a diferentes estágios no pipeline de preparação de dados. A limpeza de dados é, na verdade, um subconjunto do processo mais amplo de pré-processamento de dados. Compreender as diferenças entre os dois é fundamental para a criação de modelos confiáveis de aprendizado de máquina, pois cada um desempenha uma função exclusiva na preparação dos dados. dados brutos para análise. A tabela abaixo esclarece suas finalidades, tarefas e importância específicas.

| Aspecto | Limpeza de dados | Pré-processamento de dados |

| Escopo | Estreito - concentra-se na remoção de problemas de dados | Ampla - inclui limpeza, transformação e preparação de dados para aprendizado de máquina |

| Objetivo principal | Melhorar a qualidade dos dados | Tornar os dados adequados para treinamento e avaliação de modelos |

| Tarefas típicas | Remoção de duplicatas, tratamento de valores ausentes | Limpeza, normalização, codificação, engenharia de recursos e divisão |

| Envolve transformação? | Raramente | Frequentemente (por exemplo, escalonamento, codificação, agregação) |

| Usado em | Preparação de dados, análise inicial | Pipeline completo de aprendizado de máquina - desde dados brutos até o formato pronto para o modelo |

| Ferramentas utilizadas | Pandas, OpenRefine, Excel | Scikit-learn, Pandas, TensorFlow, NumPy |

| Exemplo | Preenchimento dos valores ausentes com a média | Preenchimento de valores ausentes e codificação de um único disparo, juntamente com padronização e divisão de treinamento/teste |

Por que o pré-processamento de dados é importante no aprendizado de máquina

O pré-processamento eficaz de dados é uma etapa essencial do pipeline de aprendizado de máquina. Ele garante que os dados inseridos em um modelo sejam limpos, consistentes e informativos, afetando diretamente seu desempenho e confiabilidade. Aqui estão alguns dos principais motivos pelos quais o pré-processamento de dados é importante no aprendizado de máquina:

-

- Melhora a precisão do modelo: Dados limpos e bem estruturados permitem que os algoritmos aprendam padrões de forma mais eficaz, levando a melhores previsões e resultados.

- Reduz o ruído e as inconsistências: A remoção de dados irrelevantes ou errôneos ajuda a evitar insights enganosos e confusão de modelos.

- Lida com dados ausentes ou incompletos: As técnicas de pré-processamento, como imputação ou exclusão, garantem que as lacunas nos dados não prejudiquem o desempenho do modelo.

- Garante a compatibilidade dos dados: Muitos algoritmos de aprendizado de máquina exigem dados em formatos específicos; etapas de pré-processamento como normalização ou codificação tornam os dados compatíveis com esses requisitos.

- Evita o vazamento de dados: A divisão adequada dos dados durante o pré-processamento (em conjuntos de treinamento, validação e teste) ajuda a evitar o ajuste excessivo e garante uma avaliação justa do modelo.

- Economiza tempo e recursos: Dados limpos e organizados simplificam o treinamento de modelos, reduzem os custos computacionais e encurtam os ciclos de desenvolvimento.

Técnicas de pré-processamento de dados

O pré-processamento de dados envolve várias técnicas criadas para preparar dados brutos para uso em modelos de aprendizado de máquina. Cada técnica aborda desafios específicos no conjunto de dados e contribui para obter dados mais limpos e confiáveis. Abaixo estão algumas das técnicas de pré-processamento de dados mais comumente usadas:

-

- Limpeza de dados: Detecta e corrige erros, remove duplicatas e lida com valores ausentes por meio de estratégias como imputação ou exclusão.

- Normalização e dimensionamento: Ajusta os valores numéricos a uma escala comum sem distorcer as diferenças nos intervalos, o que geralmente é essencial para algoritmos como KNN ou modelos baseados em descida de gradiente.

- Codificação de variáveis categóricas: Converte dados não numéricos (por exemplo, rótulos ou categorias) em formatos numéricos usando codificação de um ponto ou codificação de rótulo.

- Detecção e remoção de outliers: Identifica pontos de dados que se desviam significativamente de outros, o que pode afetar negativamente o desempenho do modelo se não forem tratados.

- Redução da dimensionalidade: Reduz o número de recursos de entrada, preservando informações importantes, usando métodos como a análise de componentes principais (PCA).

- Divisão de dados: Divide o conjunto de dados em conjuntos de treinamento, validação e teste para avaliar o modelo de forma eficaz e evitar o superajuste.

Etapas de pré-processamento de dados no aprendizado de máquina

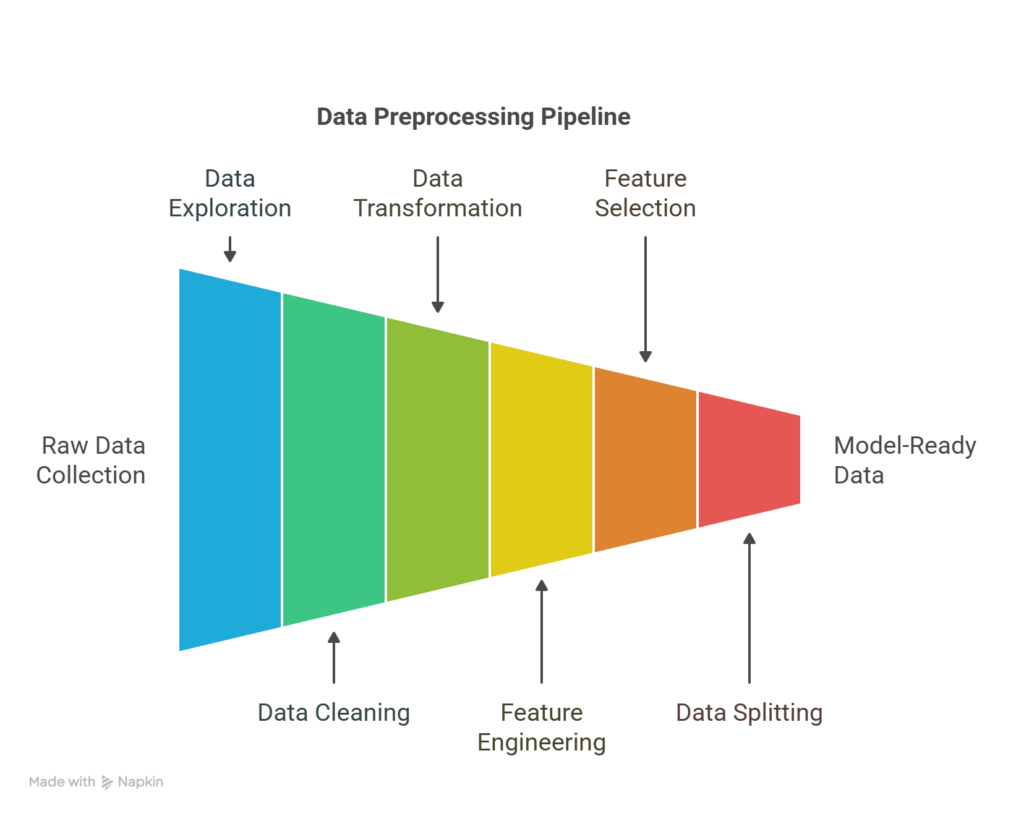

Etapas do pipeline de pré-processamento de dados

O pré-processamento de dados é um processo de várias etapas que prepara os dados brutos para o aprendizado de máquina. Cada etapa ajuda a garantir que o conjunto de dados seja preciso, consistente e otimizado para o desempenho do modelo. Veja a seguir um detalhamento passo a passo do fluxo de trabalho típico de pré-processamento de dados:

Coleta de dados

O processo começa com a coleta de dados de fontes relevantes, como bancos de dados, APIssensores ou arquivos. A qualidade e a relevância dos dados coletados influenciam diretamente o sucesso das tarefas posteriores.

Exploração de dados

Antes de fazer alterações, é essencial entender o conjunto de dados por meio da análise exploratória de dados (EDA). Essa etapa envolve o resumo das características dos dados, a visualização das distribuições, a detecção de padrões e a identificação de anomalias ou inconsistências.

Limpeza de dados

Essa etapa aborda valores ausentes, registros duplicados, formatação inconsistente e outliers. A limpeza garante que o conjunto de dados seja confiável e livre de ruídos ou erros que possam interferir no treinamento do modelo.

Transformação de dados

Nesse estágio, os dados são formatados para compatibilidade com o modelo. Esse processo inclui a normalização ou o dimensionamento de valores numéricos, a codificação de variáveis categóricas e a transformação de distribuições distorcidas para melhorar o aprendizado do modelo.

Engenharia de recursos

Novos recursos são criados com base nos dados existentes para capturar melhor os padrões subjacentes. Esse processo pode incluir a extração de variáveis baseadas em tempo, a combinação de campos ou a aplicação de conhecimento de domínio para enriquecer o conjunto de dados.

Seleção de recursos

Nem todos os recursos contribuem igualmente para o desempenho do modelo. Essa etapa envolve a seleção das variáveis mais relevantes e a remoção das redundantes ou irrelevantes, o que ajuda a reduzir o excesso de ajuste e a aumentar a eficiência.

Divisão de dados

O conjunto de dados limpo e projetado é dividido em conjuntos de treinamento, validação e teste. Isso garante que o modelo seja avaliado em dados não vistos e generalize para cenários do mundo real.

Revisão final

Antes da modelagem, uma verificação final assegura que todas as etapas de pré-processamento foram aplicadas corretamente. Esse estágio envolve a verificação de distribuições, qualidade de recursos e divisões de dados para evitar problemas como vazamento ou desequilíbrio de dados.

Exemplo de pré-processamento de dados

Suponha que você esteja criando um modelo para prever se um cliente vai cancelar um serviço de assinatura. Imagine que você tenha um conjunto de dados de uma empresa de telecomunicações com as seguintes colunas:

| ID do cliente | Idade | Gênero | Mensal_Charges | Tipo de contrato | Agitação |

| 1 | 34 | Masculino | 70.5 | Mês a mês | Sim |

| 2 | NaN | Feminino | 85 | Um ano | Não |

| 3 | 45 | Feminino | NaN | Mês a mês | Sim |

| 4 | 29 | Masculino | 65.5 | Dois anos | Não |

Vamos examinar as etapas de pré-processamento:

-

- Tratamento de valores ausentes

-

-

- Preencha a idade ausente com a idade média (36).

- Preencha os dados faltantes de Monthly_Charges com a coluna mediana (73,5).

-

-

- Codificação de variáveis categóricas

-

-

- Gênero (Masculino/Feminino) e Tipo de contrato (Mês a mês, Um ano, Dois anos) são categóricos.

- Candidatar-se:

- Codificação de rótulos para Gênero (Masculino = 0, Feminino = 1)

- Codificação de um ponto para Contract_Type, resultando em:

- Contrato_Mês_a_mês, Contrato_Um_ano, Contrato_Dois_anos

-

-

- Dimensionamento de recursos

-

-

- Normalize Age e Monthly_Charges para colocá-los na mesma escala (isso é especialmente útil para modelos baseados em distância, como o KNN).

-

-

- Codificação de destino

-

-

- Converter Churn (Yes/No) em binário:

- Sim = 1

- Não = 0

- Converter Churn (Yes/No) em binário:

-

-

- Conjunto de dados limpo e pré-processado

| Idade | Gênero | Mensal_Charges | Mês_do_contrato | Contrato_Um | Contrato_dois | Agitação |

| 34 | 0 | 70.5 | 1 | 0 | 0 | 1 |

| 36 | 1 | 85 | 0 | 1 | 0 | 0 |

| 45 | 1 | 73.5 | 1 | 0 | 0 | 1 |

| 29 | 0 | 65.5 | 0 | 0 | 1 | 0 |

Agora o conjunto de dados está limpo, numérico e pronto para o treinamento do modelo.

Ferramentas de pré-processamento de dados

A escolha das ferramentas certas para o pré-processamento de dados pode afetar a eficácia do seu fluxo de trabalho de aprendizado de máquina. Veja abaixo uma lista de ferramentas comumente usadas, juntamente com seus pontos fortes e limitações:

Pandas (Python)

Mais adequado para:

-

- Manuseio de dados estruturados (por exemplo, CSVs, Excel, tabelas SQL)

- Limpeza, filtragem e transformação de dados

- Análise rápida de dados exploratórios

Não é adequado para:

-

- Processamento distribuído em grande escala

- Pipelines de ETL complexos ou dados não estruturados (por exemplo, imagens, áudio)

NumPy (Python)

Mais adequado para:

-

- Operações numéricas e manipulação de matrizes multidimensionais

- Cálculos de matriz com desempenho otimizado

Não é adequado para:

-

- Manipulação ou limpeza de dados de alto nível

- Trabalhar diretamente com conjuntos de dados rotulados (o Pandas é mais adequado)

Scikit-learn (Python)

Mais adequado para:

-

- Dimensionamento, codificação e seleção de recursos

- Divisão de dados (treinamento/teste/validação)

- Integração com modelos e pipelines de ML

Não é adequado para:

-

- Tarefas de aprendizagem profunda

- Manipulação pesada de dados (use com Pandas)

OpenRefine

Mais adequado para:

-

- Limpeza de dados bagunçados, não estruturados ou inconsistentes

- Conciliação e transformação de dados de diferentes fontes

- Não programadores que precisam de uma ferramenta baseada em GUI

Não é adequado para:

-

- Grandes conjuntos de dados

- Integração em fluxos de trabalho automatizados de aprendizado de máquina

Apache Spark (com PySpark ou Scala)

Mais adequado para:

-

- Processamento de conjuntos de dados em grande escala em um ambiente distribuído

- Pré-processamento de dados em pipelines de big data

- Integração com plataformas de nuvem (AWS, Azure, GCP)

Não é adequado para:

-

- Conjuntos de dados pequenos a médios (a sobrecarga pode não ser justificada)

- Manipulação de dados interativa e refinada

Dataiku

Mais adequado para:

-

- Fluxos de trabalho de ML de ponta a ponta, incluindo pré-processamento, modelagem e implantação

- Equipes com usuários técnicos e não técnicos

- Programação visual e automação

Não é adequado para:

-

- Personalização profunda ou controle de dados de baixo nível

- Projetos pessoais leves ou fluxos de trabalho somente de código

Validação de dados do TensorFlow (TFDV)

Mais adequado para:

-

- Validação de pipelines de dados em fluxos de trabalho de ML de produção

- Detecção de anomalias de esquema e desvio de dados em escala

- Uso no ecossistema do TensorFlow Extended (TFX)

Não é adequado para:

-

- Limpeza de dados para fins gerais

- Use fora dos ambientes TensorFlow ou TFX

Os pontos fortes e as limitações dessas ferramentas dependem, em última análise, do tamanho do seu projeto, da complexidade e do ambiente técnico. A combinação de ferramentas (por exemplo, Pandas para limpeza e Scikit-learn para dimensionamento de recursos) geralmente oferece os melhores resultados.

Principais conclusões e recursos

O pré-processamento de dados é fundamental para o processo de aprendizado de máquina. Ele transforma dados brutos e confusos em um conjunto de dados limpo e estruturado, pronto para o treinamento do modelo. Ele inclui tarefas como lidar com valores ausentes, codificar variáveis categóricas, dimensionar recursos e criar novos recursos, o que ajuda a melhorar a precisão e a confiabilidade do modelo. Ignorar o pré-processamento geralmente leva a um desempenho ruim e a resultados enganosos.

Ferramentas como Pandas, Scikit-learn e TensorFlow simplificam o processo, enquanto o OpenRefine ou o Excel são úteis para tarefas mais leves ou visuais.

Você pode continuar aprendendo sobre diferentes abordagens de preparação de dados por meio dos recursos abaixo:

-

- Um guia para a fragmentação de dados

- Preparação de conjuntos de dados para ajuste fino de modelos de ML: Um guia abrangente

- Um guia passo a passo para preparar dados para a geração aumentada por recuperação (RAG)

- Processamento em lote - Conceitos

- O que é mineração de dados? Técnicas, ferramentas e aplicativos