Os LLM embeddings são representações numéricas de palavras, frases ou outros dados que capturam o significado semântico, permitindo o processamento eficiente de textos, a pesquisa de similaridade e a recuperação em aplicativos de IA. Eles são gerados por meio de transformações de redes neurais, especialmente usando mecanismos de autoatenção em modelos de transformadores como GPT e BERT, e podem ser ajustados para tarefas específicas do domínio. Esses embeddings potencializam uma ampla gama de aplicativos, incluindo mecanismos de pesquisa, sistemas de recomendação, assistentes virtuais e agentes de IA, com ferramentas como o Couchbase Capella™ simplificando sua integração em soluções do mundo real.

O que são embeddings LLM?

Os LLM embeddings são representações numéricas de palavras, frases ou outros tipos de dados que capturam o significado semântico em um espaço de alta dimensão. Eles permitem grandes modelos de linguagem (LLMs) para processar, comparar e recuperar textos com eficiência. Em vez de lidar diretamente com o texto bruto, os LLMs convertem os dados de entrada em vetores que agrupam significados semelhantes. Esse agrupamento permite a compreensão contextual, pesquisa de similaridadee recuperação eficiente de conhecimento para uma ampla variedade de tarefas, incluindo compreensão de linguagem natural e sistemas de recomendação.

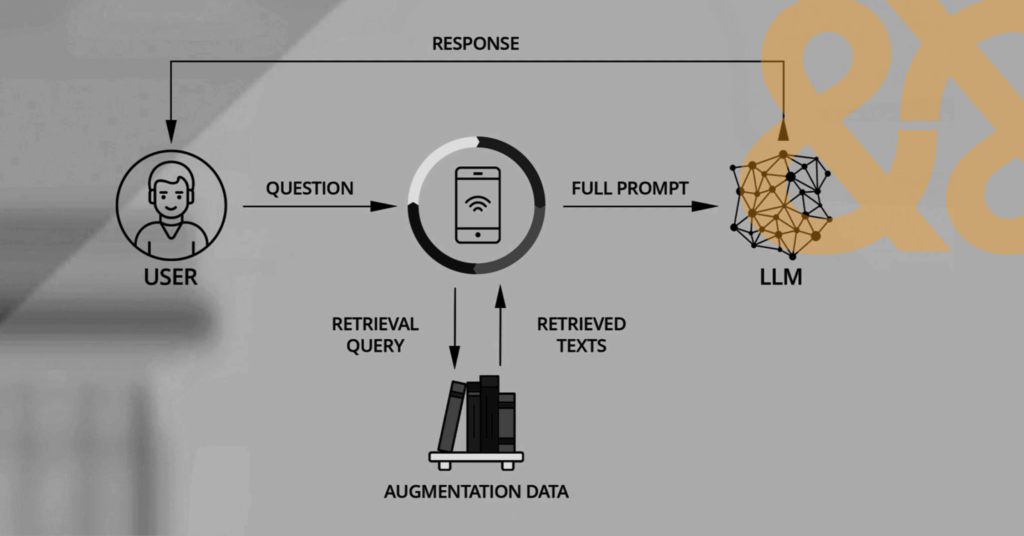

Um aplicativo típico que ajuda a criar embeddings com base na entrada do usuário em preparação para uso por um LLM

Como funcionam os embeddings?

Os LLMs criam embeddings passando o texto por camadas de transformações de redes neurais que mapeiam os tokens de entrada no espaço vetorial. Essas transformações capturam relações sintáticas e semânticas para garantir que palavras com significados semelhantes tenham representações vetoriais mais próximas. Modelos baseados em transformadores, como GPT e BERT usam mecanismos de autoatenção para atribuir peso contextual às palavras e refinar os embeddings com base nas palavras ao redor. Ao converter palavras em formato numérico, os embeddings permitem comparações de similaridade, agrupamento e operações de recuperação eficientes.

Também é possível fazer o ajuste fino de embeddings pré-treinados para aplicativos específicos de domínio, a fim de melhorar o desempenho de tarefas especializadas, como recuperação de documentos jurídicos ou médicos. Para otimizar ainda mais a saída, você pode usar geração aumentada por recuperação (RAG) para fazer referência a uma base de conhecimento ou domínio adicional antes de gerar uma resposta. O Couchbase pode ajudá-lo a criar aplicativos RAG de ponta a ponta usando a pesquisa vetorial em conjunto com a popular estrutura LLM de código aberto LangChain.

Componentes dos LLMs

Os LLMs consistem em vários componentes-chave que trabalham juntos para gerar embeddings e processar textos. Esses componentes, em conjunto, permitem que os LLMs capturem relações linguísticas profundas e produzam embeddings significativos:

-

- O camada de tokenização divide a entrada em subpalavras ou caracteres e os converte em representações numéricas.

- O camada de incorporação transforma esses tokens em vetores de alta dimensão.

- O mecanismo de atenção, particularmente a autoatenção, determina como as palavras influenciam umas às outras com base no contexto.

- O camadas de avanço refinar os embeddings e gerar previsões de saída.

- Codificação posicional ajuda modelos compreender a ordem das palavras para garantir o processamento coerente do texto.

Embeddings unimodais vs. multimodais

Os embeddings unimodais representam um único tipo de dados, como texto, imagens ou áudio, em um espaço vetorial específico. Os embeddings de texto, por exemplo, concentram-se apenas em padrões linguísticos.

Os embeddings multimodais integram vários tipos de dados em um espaço compartilhado, permitindo que os modelos processem e relacionem diferentes modalidades. As incorporações multimodais são essenciais para aplicativos como legendas de vídeo, assistentes de voz e pesquisa multimodal, em que diferentes tipos de dados devem interagir perfeitamente. Por exemplo, o modelo CLIP da OpenAI alinha texto e imagens incorporadas para permitir a recuperação de imagens baseadas em texto.

Tipos de incorporação

Os embeddings variam de acordo com sua estrutura e uso pretendido:

-

- Embeddings de palavras representam palavras individuais com base em padrões de co-ocorrência.

- Embeddings de frases codificar frases inteiras para capturar um significado contextual mais amplo.

- Embeddings de documentos se estendem a corpos de texto mais longos.

- Embeddings intermodais alinhar diferentes tipos de dados em um espaço compartilhado para facilitar as interações entre texto, imagens e áudio.

- Incorporação específica de domínio são ajustados em conjuntos de dados especializados para melhorar o desempenho em áreas como medicina ou finanças.

Cada tipo de incorporação serve a diferentes tarefas, como otimização de pesquisa ou recomendação de conteúdo.

Casos de uso para embeddings LLM

As incorporações LLM potencializam uma ampla gama de aplicativos, permitindo comparações eficientes de textos e dados:

-

- Mecanismos de pesquisa melhorar a relevância, recuperando documentos com características semelhantes semântico em vez de apenas correspondências de palavras-chave.

- Chatbots e assistentes virtuais usar embeddings para entender as consultas e gerar respostas com reconhecimento de contexto.

- Sistemas de recomendação usar embeddings para sugerir conteúdo com base nas preferências do usuário.

- Detecção de fraudes usa embeddings para ajudar a identificar padrões em transações financeiras.

- Ferramentas de autocompletar código dependem de embeddings para sugerir funções relevantes.

- Os embeddings também aprimoram a sumarização, a tradução e as plataformas de aprendizado personalizado.

Agentes de IAque usam a GenAI para imitar e automatizar o raciocínio e os processos humanos, são o novo caso de uso mais quente para os LLMs. Serviços de IA do Couchbase Capella ajudam os desenvolvedores a criar agentes de IA mais rapidamente, abordando muitos dos desafios mais críticos da GenAI, incluindo confiabilidade e custo.

Como escolher uma abordagem de incorporação

A melhor abordagem de incorporação para o seu projeto depende das tarefas que você deseja executar, do tipo de dados com os quais está trabalhando e do nível de precisão necessário. Os embeddings pré-treinados, como o BERT ou o GPT, são eficazes para a compreensão geral da linguagem, mas se a precisão específica do domínio for crucial, você deverá ajustar seus embeddings em conjuntos de dados especializados para melhorar o desempenho. Tarefas multimodais exigirão embeddings multimodais, enquanto os aplicativos de recuperação de alta velocidade se beneficiarão de técnicas de pesquisa vetorial densa como a Faiss.

A complexidade do seu caso de uso determinará se um modelo leve será suficiente ou se será necessária uma abordagem profunda baseada em transformadores. Você também deve considerar os custos de computação e as restrições de armazenamento ao selecionar uma estratégia de incorporação que atenda aos seus requisitos.

Como incorporar dados para LLMs

A incorporação de dados envolve o pré-processamento do texto, sua tokenização e sua passagem por um modelo de incorporação para obter vetores numéricos. A tokenização divide o texto em subpalavras ou caracteres antes de mapeá-los em um espaço de alta dimensão. Em seguida, o modelo refina os embeddings por meio de várias camadas de transformações neurais.

Depois de gerados, você pode armazenar os embeddings para uma recuperação eficiente ou ajustá-los para tarefas específicas. Ferramentas como a API de incorporação da OpenAI, Hugging Face Transformers ou as camadas de incorporação do TensorFlow simplificam o processo. As etapas de pós-processamento, como normalização ou redução de dimensionalidade, aumentam a eficiência de aplicativos posteriores, como clustering e pesquisa.

Para os clientes do Couchbase que armazenam documentos JSON no Capella, eliminamos a necessidade de criar um sistema de incorporação personalizado. Serviço de Vetorização da Capella acelera seu desenvolvimento de IA convertendo perfeitamente os dados em representações vetoriais.

Principais conclusões e próximas etapas

As incorporações LLM são um componente essencial do Aplicativos com tecnologia de IA como mecanismos de pesquisa, assistentes virtuais, sistemas de recomendação e agentes de IA. Eles permitem comparações de texto e dados altamente eficientes que geram resultados significativos e excelentes experiências de usuário.

A plataforma unificada de dados para desenvolvedores do Couchbase Capella suporta LLMs populares e é ideal para criar e executar pesquisas, IA agênticae aplicativos de borda que aproveitam os embeddings LLM. O Capella inclui o Capella iQ, um assistente de codificação com tecnologia de IA que ajuda os desenvolvedores a escrever consultas SQL, criar dados de teste e escolher os índices certos para reduzir os tempos de consulta. Você pode começar a trabalhar em nosso nível gratuito em minutos, sem necessidade de cartão de crédito.

PERGUNTAS FREQUENTES

Os LLMs usam incorporação de palavras? Os LLMs usam embeddings de palavras, mas normalmente geram embeddings contextuais em vez de embeddings estáticos de palavras. Ao contrário dos métodos tradicionais, como o Word2Vec, as incorporações LLM mudam com base no contexto circundante.

O que são modelos de incorporação no LLM? Os modelos de incorporação nos LLMs convertem o texto em vetores numéricos de alta dimensão que capturam o significado semântico. Esses modelos ajudam os LLMs a processar, comparar e recuperar textos com eficiência.

O que é um exemplo de um modelo de incorporação? Os modelos de incorporação de texto da OpenAI (por exemplo, text-embedding-3-small e text-embedding-3-large) geram incorporações para tarefas de pesquisa, agrupamento e recuperação. Outros exemplos incluem modelos baseados em BERT e SentenceTransformers.

Qual é a diferença entre tokens e embeddings no LLM? Os tokens são unidades discretas de texto (palavras, subpalavras ou caracteres) que os LLMs processam, enquanto os embeddings são as representações vetoriais numéricas desses tokens. Os embeddings codificam relações semânticas que permitem que os modelos compreendam o significado.

Por que os LLMs fazem tokenização? A tokenização divide o texto em unidades menores para que os LLMs possam processar e gerar embeddings com eficiência. Isso permite que o modelo lide com diversos idiomas, palavras raras e diferentes estruturas de frases.