오늘 유니티는 NVIDIA NIM/NeMo와의 새로운 통합을 발표하게 되어 기쁘게 생각합니다. 이 블로그 게시물에서는 다음을 기반으로 하는 대화형 챗봇의 솔루션 컨셉을 소개합니다. 검색 증강 세대 (RAG) 아키텍처와 카우치베이스 카펠라를 벡터 데이터베이스로 사용합니다. RAG 파이프라인의 검색 및 생성 단계는 NVIDIA NIM/NeMo를 통해 가속화됩니다. 몇 줄의 코드만 있으면 됩니다.

다양한 업종의 기업들은 고객에게 최고의 고객 서비스를 제공하기 위해 노력하고 있습니다. 이를 위해 응급실 간호사, 매장 판매 직원, 헬프 데스크 담당자 등 일선 직원들이 관련성 있는 최신 정보를 신속하게 검색할 수 있도록 AI 기반 대화형 질의응답(QA) 챗봇으로 무장하고 있습니다.

챗봇은 일반적으로 다음을 기반으로 합니다. RAG는 기업의 지식 기반에서 사실을 검색하여 가장 정확하고 최신의 정보로 LLM 응답의 근거를 마련하는 데 사용되는 AI 프레임워크입니다. 이 프레임워크는 세 가지 단계로 구성되며, 가장 관련성이 높은 컨텍스트를 검색하는 것부터 시작됩니다. 벡터 검색를 사용하여 사용자의 쿼리를 컨텍스트에 맞게 보강하고, 마지막으로 LLM을 사용하여 관련 응답을 생성합니다.

기존 RAG 파이프라인의 문제점은 검색 단계에서 사용자 프롬프트를 벡터로 변환하기 위해 임베딩 서비스를 호출하면 상당한 지연 시간이 추가되어 상호작용이 필요한 애플리케이션의 속도가 느려질 수 있다는 것입니다. 수백만 개의 PDF, 문서 및 기타 지식 베이스로 구성된 문서 코퍼스를 벡터화하는 데 시간이 오래 걸릴 수 있으므로 오래된 데이터를 RAG에 사용할 가능성이 높아집니다. 또한 챗봇 애플리케이션의 응답 시간을 줄이기 위해 비용 효율적으로 추론(토큰/초)을 가속화하는 것이 어렵다는 것을 알게 됩니다.

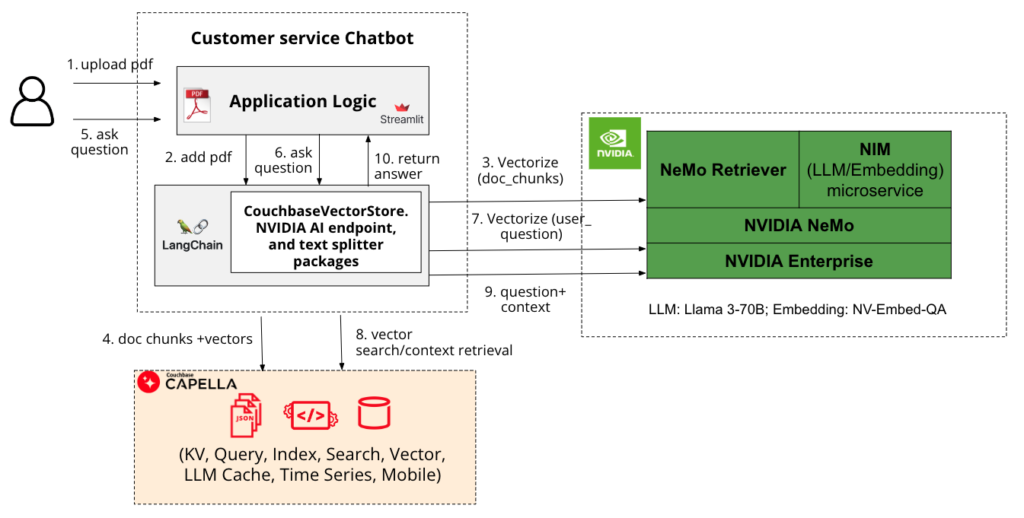

그림 1은 쉽게 개발할 수 있는 성능 스택을 보여줍니다. 대화형 고객 서비스 챗봇입니다. StreamLit 애플리케이션 프레임워크, 오케스트레이션을 위한 LangChain, 벡터 인덱싱 및 검색을 위한 Couchbase Capella, 검색 및 생성 단계를 가속화하는 NVIDIA NIM/NeMo로 구성됩니다.

고성능 서비스형 데이터베이스(DBaaS)인 Couchbase Capella를 사용하면 JSON의 유연성을 활용하면서 연산, 벡터, 텍스트, 시계열 및 위치 기반 데이터의 저장, 색인 및 쿼리를 빠르게 시작할 수 있습니다. 다음 용도로 Capella를 쉽게 통합할 수 있습니다. 벡터 검색 또는 다음과 같은 오케스트레이션 프레임워크를 통합하여 별도의 벡터 데이터베이스 없이도 시맨틱 검색을 수행할 수 있습니다. LangChain 또는 LlamaIndex 를 프로덕션 RAG 파이프라인에 도입하세요. 이 솔루션은 하이브리드 검색 기능을 사용하면 벡터 검색과 기존 검색을 혼합하여 검색 성능을 크게 향상시킬 수 있습니다. 또한 엣지 AI 사용 사례를 위해 Couchbase 모바일을 사용하여 벡터 검색을 엣지까지 확장할 수 있습니다.

아카펠라 벡터 검색을 구성한 후에는 다음에서 성능 좋은 모델을 선택할 수 있습니다. NVIDIA API 카탈로그는 오픈 소스, NVIDIA AI 기반 및 커스텀 모델을 아우르는 광범위한 기반 모델을 제공하며, NVIDIA 가속 인프라에서 최고의 성능을 제공하도록 최적화되어 있습니다. 이러한 모델은 다음과 같이 배포됩니다. NVIDIA NIM 단일 명령으로 사용하기 쉬운 사전 빌드된 컨테이너를 사용하여 온프레미스 또는 클라우드에 구축할 수 있습니다. NeMo 리트리버, NVIDIA NeMo의 일부입니다, 는 가장 낮은 지연 시간, 가장 높은 처리량, 최대의 데이터 프라이버시로 정보 검색을 제공합니다.

앞서 언급한 스택을 사용하여 개발한 챗봇을 사용하면 다음을 수행할 수 있습니다. PDF 문서를 업로드하고 대화형으로 질문할 수 있습니다. 다음을 사용합니다. NV-QA-임베드질문과 답변 검색에 사용되는 GPU 가속 텍스트 임베딩 모델과 라마 3 - 70B로 패키징되어 NVIDIA 인프라에서 가속됩니다. 그리고 랭체인-엔비디아-AI-엔드포인트 패키지에는 NVIDIA NIM에서 모델을 사용하여 애플리케이션을 구축하기 위한 LangChain 통합이 포함되어 있습니다. 프로토타이핑 목적으로 NVIDIA 호스팅 엔드포인트를 사용했지만, 자체 호스팅 NIM을 사용하려면 다음을 참조하여 NIM 문서 프로덕션 배포용입니다.

이 솔루션을 사용하여 다음과 같이 빠른 정보 검색이 필요한 사용 사례를 지원할 수 있습니다:

-

- 응급실 간호사가 관련 의료 정보에 빠르게 액세스하여 환자 분류 속도를 높여 과밀, 긴 진료 대기, 환자 만족도 저하를 완화할 수 있습니다.

- 고객 서비스 상담원이 내부 지식 기반 챗봇을 통해 관련 지식을 빠르게 검색하여 통화 대기 시간을 줄일 수 있도록 지원합니다. 이는 CSAT 점수를 높이는 데 도움이 될 뿐만 아니라 많은 통화량을 관리할 수 있게 해줍니다.

- 매장 내 판매 직원이 쇼핑객이 요청했지만 현재 품절(품절)된 품목의 사진이나 설명과 유사한 품목을 제품 카탈로그에서 빠르게 찾아 추천하여 쇼핑 경험을 개선할 수 있도록 지원합니다.

결론적으로, 챗봇과 같은 대화형 GenAI 애플리케이션을 개발할 때 Couchbase Capella 기반 RAG를 사용하여 근거가 있고 관련성이 높은 응답을 제공하고 NVIDIA NIM/NeMo를 사용하여 가속화할 수 있습니다. 이 조합은 확장성, 안정성, 사용 편의성을 제공합니다. DBaaS 환경을 위해 Capella와 함께 배포하는 것 외에도, 보안 및 개인정보 보호에 대한 요구 사항이 더 엄격한 사용 사례를 위해 VPC 내의 퍼블릭 클라우드에서 온프레미스 또는 자체 관리형 Couchbase와 함께 NIM/NeMo를 배포할 수 있습니다. 또한 다음을 사용할 수 있습니다. NeMo 가드레일 를 사용하여 회사에서 불쾌하다고 판단하는 콘텐츠에 대한 LLM의 출력을 제어할 수 있습니다.

챗봇 애플리케이션에 대한 자세한 내용은 카우치베이스에서 확인할 수 있습니다. 개발자 포털 와 함께 코드 완성. 에 가입하세요. 카펠라 평가판 계정, 무료 NVIDIA NIM 계정를 클릭하고 GenAI 애플리케이션 개발을 시작하세요.