El preprocesamiento de datos es un paso vital en el aprendizaje automático que transforma los datos brutos y desordenados en un formato limpio y estructurado para el entrenamiento de modelos. Implica limpiar, transformar, codificar y dividir los datos para mejorar la precisión del modelo, evitar la fuga de datos y garantizar la compatibilidad con los algoritmos. Aunque a menudo se confunde con la limpieza de datos, el preprocesamiento engloba un conjunto más amplio de tareas fundamentales para que las cadenas de aprendizaje automático sean fiables. El uso de herramientas como Pandas, Scikit-learn y Apache Spark ayuda a agilizar este proceso, haciéndolo escalable y eficaz en proyectos de diferentes tamaños y complejidades.

¿Qué es el preprocesamiento de datos en el aprendizaje automático?

El preprocesamiento de datos en el aprendizaje automático hace referencia a los pasos que se dan para limpiar, organizar y transformar los datos sin procesar en un formato que los algoritmos de aprendizaje automático puedan utilizar con eficacia. Los datos del mundo real suelen ser confusos porque incluyen valores perdidos, formatos incoherentes, valores atípicos y características irrelevantes. Sin un preprocesamiento adecuado, incluso los modelos de aprendizaje automático más sofisticados pueden tener dificultades para encontrar patrones o producir resultados engañosos.

Un preprocesamiento de datos eficaz no solo mejora la precisión y la eficacia de los modelos de ML, sino que también ayuda a descubrir conocimientos más profundos ocultos en los datos. Sienta las bases para el éxito de cualquier proyecto de ML al garantizar que los datos de entrada son de alta calidad, coherentes y relevantes.

Preprocesamiento de datos frente a limpieza de datos

Aunque el preprocesamiento y la limpieza de datos suelen utilizarse indistintamente, se refieren a etapas distintas del proceso de preparación de datos. En realidad, la limpieza de datos es un subconjunto del proceso más amplio de preprocesamiento de datos. Comprender las diferencias entre ambos es crucial para crear modelos de aprendizaje automático fiables, ya que cada uno desempeña un papel único en la preparación de los datos. datos brutos para el análisis. La tabla siguiente aclara sus propósitos, tareas e importancia específicos.

| Aspecto | Limpieza de datos | Preprocesamiento de datos |

| Alcance | Estrecha: se centra en eliminar los problemas de datos | Amplio: incluye la limpieza, transformación y preparación de datos para el aprendizaje automático. |

| Objetivo principal | Mejorar la calidad de los datos | Adecuar los datos para el entrenamiento y la evaluación de modelos |

| Tareas típicas | Eliminación de duplicados, tratamiento de valores omitidos | Limpieza, normalización, codificación, ingeniería de rasgos y división |

| ¿Implica transformación? | Raramente | Con frecuencia (por ejemplo, escalado, codificación, agregación) |

| Usado en | Procesamiento de datos, análisis inicial | Proceso completo de aprendizaje automático: de los datos brutos al formato listo para el modelo |

| Herramientas utilizadas | Pandas, OpenRefine, Excel | Scikit-learn, Pandas, TensorFlow, NumPy |

| Ejemplo | Rellenar los valores que faltan con la media | Rellenado de valores omitidos y codificación de una sola vez, junto con normalización y división entre entrenamiento y prueba. |

Por qué es importante el preprocesamiento de datos en el aprendizaje automático

El preprocesamiento eficaz de los datos es un paso fundamental en el proceso de aprendizaje automático. Garantiza que los datos introducidos en un modelo estén limpios y sean coherentes e informativos, lo que repercute directamente en su rendimiento y fiabilidad. He aquí algunas razones clave por las que el preprocesamiento de datos es importante en el aprendizaje automático:

-

- Mejora la precisión del modelo: Unos datos limpios y bien estructurados permiten a los algoritmos aprender patrones con mayor eficacia, lo que se traduce en mejores predicciones y resultados.

- Reduce el ruido y las incoherencias: La eliminación de datos irrelevantes o erróneos ayuda a evitar percepciones erróneas y confusión en los modelos.

- Gestiona los datos que faltan o están incompletos: Las técnicas de preprocesamiento, como la imputación o la eliminación, garantizan que las lagunas en los datos no degraden el rendimiento del modelo.

- Garantiza la compatibilidad de los datos: Muchos algoritmos de aprendizaje automático requieren datos en formatos específicos; pasos de preprocesamiento como normalización o codificación hacen que los datos sean compatibles con estos requisitos.

- Evita la fuga de datos: Una división adecuada de los datos durante el preprocesamiento (en conjuntos de entrenamiento, validación y prueba) ayuda a evitar el sobreajuste y garantiza una evaluación justa del modelo.

- Ahorra tiempo y recursos: Unos datos limpios y organizados agilizan la formación de modelos, reducen los costes de cálculo y acortan los ciclos de desarrollo.

Técnicas de preprocesamiento de datos

El preprocesamiento de datos incluye varias técnicas diseñadas para preparar los datos brutos para su uso en modelos de aprendizaje automático. Cada técnica aborda problemas específicos del conjunto de datos y contribuye a obtener entradas más limpias y fiables. A continuación se presentan algunas de las técnicas de preprocesamiento de datos más utilizadas:

-

- Limpieza de datos: Detecta y corrige errores, elimina duplicados y gestiona los valores omitidos mediante estrategias como la imputación o la eliminación.

- Normalización y escalado: Ajusta los valores numéricos a una escala común sin distorsionar las diferencias en los rangos, a menudo esencial para algoritmos como KNN o modelos basados en el descenso de gradiente.

- Codificación de variables categóricas: Convierte datos no numéricos (por ejemplo, etiquetas o categorías) en formatos numéricos utilizando la codificación de un solo paso o la codificación de etiquetas.

- Detección y eliminación de valores atípicos: Identifica los puntos de datos que se desvían significativamente de otros, lo que puede afectar negativamente al rendimiento del modelo si no se tiene en cuenta.

- Reducción de la dimensionalidad: Reduce el número de características de entrada conservando la información importante, mediante métodos como el análisis de componentes principales (ACP).

- División de datos: Divide el conjunto de datos en conjuntos de entrenamiento, validación y prueba para evaluar el modelo con eficacia y evitar el sobreajuste.

Pasos del preprocesamiento de datos en el aprendizaje automático

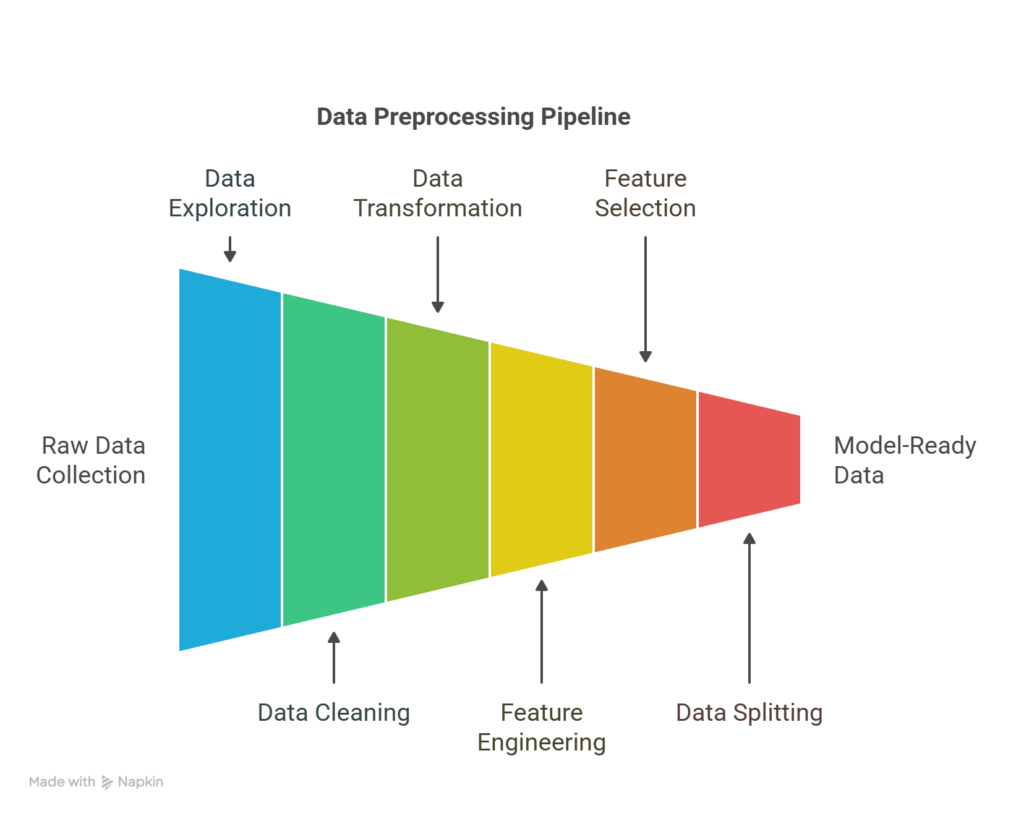

Pasos del proceso de preprocesamiento de datos

El preprocesamiento de datos es un proceso de varios pasos que prepara los datos brutos para el aprendizaje automático. Cada paso ayuda a garantizar que el conjunto de datos sea preciso, coherente y optimizado para el rendimiento del modelo. He aquí un desglose paso a paso del flujo de trabajo típico del preprocesamiento de datos:

Recogida de datos

El proceso comienza con la recopilación de datos de fuentes pertinentes como bases de datos, APIso archivos. La calidad y la pertinencia de los datos recogidos influyen directamente en el éxito de las tareas posteriores.

Exploración de datos

Antes de realizar cambios, es esencial comprender el conjunto de datos mediante el análisis exploratorio de datos (AED). Este paso consiste en resumir las características de los datos, visualizar distribuciones, detectar patrones e identificar anomalías o incoherencias.

Limpieza de datos

Este paso se ocupa de los valores que faltan, los registros duplicados, el formato incoherente y los valores atípicos. La limpieza garantiza que el conjunto de datos sea fiable y esté libre de ruidos o errores que puedan interferir en el entrenamiento del modelo.

Transformación de datos

En esta fase, los datos se formatean para que sean compatibles con el modelo. Este proceso incluye normalizar o escalar valores numéricos, codificar variables categóricas y transformar distribuciones sesgadas para mejorar el aprendizaje del modelo.

Ingeniería de funciones

Se crean nuevas características a partir de los datos existentes para captar mejor los patrones subyacentes. Este proceso puede incluir la extracción de variables temporales, la combinación de campos o la aplicación de conocimientos de dominio para enriquecer el conjunto de datos.

Selección de características

No todas las características contribuyen por igual al rendimiento del modelo. Este paso consiste en seleccionar las variables más relevantes y eliminar las redundantes o irrelevantes, lo que ayuda a reducir el sobreajuste y mejorar la eficiencia.

División de datos

El conjunto de datos depurado y diseñado se divide en conjuntos de entrenamiento, validación y prueba. De este modo, se garantiza que el modelo se evalúe con datos desconocidos y se generalice a situaciones reales.

Revisión final

Antes de modelar, una comprobación final asegura que todos los pasos de preprocesamiento se han aplicado correctamente. En esta etapa se verifican las distribuciones, la calidad de las características y las divisiones de los datos para evitar problemas como la fuga de datos o el desequilibrio.

Ejemplo de preprocesamiento de datos

Supongamos que está creando un modelo para predecir si un cliente abandonará un servicio de suscripción. Imagina que tienes un conjunto de datos de una empresa de telecomunicaciones con las siguientes columnas:

| ID_cliente | Edad | Género | Gastos_mensuales | Tipo_contrato | Churn |

| 1 | 34 | Hombre | 70.5 | Mes a mes | Sí |

| 2 | NaN | Mujer | 85 | Un año | No |

| 3 | 45 | Mujer | NaN | Mes a mes | Sí |

| 4 | 29 | Hombre | 65.5 | Dos años | No |

Veamos los pasos del preprocesamiento:

-

- Tratamiento de los valores omitidos

-

-

- Completa la Edad que falta con la edad media (36).

- Rellene los Monthly_Charges que faltan con la mediana de la columna (73,5).

-

-

- Codificación de variables categóricas

-

-

- Género (Hombre/Mujer) y Tipo_contrato (Mes a mes, Un año, Dos años) son categóricas.

- Aplicar:

- Codificación de etiquetas para Sexo (Masculino = 0, Femenino = 1)

- Codificación en caliente para Tipo_Contrato, dando como resultado:

- Contrato_mes a mes, Contrato_un año, Contrato_dos años

-

-

- Escalado de características

-

-

- Normalice Age y Monthly_Charges para ponerlos a la misma escala (esto es especialmente útil para modelos basados en la distancia como KNN).

-

-

- Codificación del objetivo

-

-

- Convertir Churn (Sí/No) a binario:

- Sí = 1

- No = 0

- Convertir Churn (Sí/No) a binario:

-

-

- Conjunto de datos depurados y preprocesados

| Edad | Género | Gastos_mensuales | Contrato_Mes | Contrato_Uno | Contrato_dos | Churn |

| 34 | 0 | 70.5 | 1 | 0 | 0 | 1 |

| 36 | 1 | 85 | 0 | 1 | 0 | 0 |

| 45 | 1 | 73.5 | 1 | 0 | 0 | 1 |

| 29 | 0 | 65.5 | 0 | 0 | 1 | 0 |

Ahora el conjunto de datos está limpio, es numérico y está listo para el entrenamiento del modelo.

Herramientas de preprocesamiento de datos

Elegir las herramientas adecuadas para el preprocesamiento de datos puede influir en la eficacia de su flujo de trabajo de aprendizaje automático. A continuación se muestra una lista de las herramientas más utilizadas, junto con sus ventajas y limitaciones:

Pandas (Python)

El más adecuado para:

-

- Manejo de datos estructurados (por ejemplo, CSV, Excel, tablas SQL)

- Limpieza, filtrado y transformación de datos

- Análisis exploratorio rápido de datos

No es adecuado para:

-

- Procesamiento distribuido a gran escala

- Canalizaciones ETL complejas o datos no estructurados (por ejemplo, imágenes, audio)

NumPy (Python)

El más adecuado para:

-

- Operaciones numéricas y manejo de matrices multidimensionales

- Cálculos matriciales de rendimiento optimizado

No es adecuado para:

-

- Manipulación o limpieza de datos de alto nivel

- Trabajar directamente con conjuntos de datos etiquetados (Pandas es más apropiado)

Scikit-learn (Python)

El más adecuado para:

-

- Escalado, codificación y selección de características

- División de datos (entrenamiento/prueba/validación)

- Integración con modelos y procesos de ML

No es adecuado para:

-

- Tareas de aprendizaje profundo

- Manipulación de datos pesados (uso con Pandas)

OpenRefine

El más adecuado para:

-

- Limpieza de datos desordenados, no estructurados o incoherentes

- Conciliación y transformación de datos procedentes de distintas fuentes

- No programadores que necesitan una herramienta basada en GUI

No es adecuado para:

-

- Grandes conjuntos de datos

- Integración en flujos de trabajo automatizados de aprendizaje automático

Apache Spark (con PySpark o Scala)

El más adecuado para:

-

- Procesamiento de conjuntos de datos a gran escala en un entorno distribuido

- Preprocesamiento de datos en Big Data Pipelines

- Integración con plataformas en la nube (AWS, Azure, GCP)

No es adecuado para:

-

- Conjuntos de datos pequeños y medianos (los gastos generales pueden no estar justificados)

- Manipulación de datos interactiva y detallada

Dataiku

El más adecuado para:

-

- Flujos de trabajo de ML de extremo a extremo, incluido el preprocesamiento, el modelado y la implantación

- Equipos con usuarios técnicos y no técnicos

- Programación visual y automatización

No es adecuado para:

-

- Personalización profunda o control de datos de bajo nivel

- Proyectos personales ligeros o flujos de trabajo de sólo código

Validación de datos TensorFlow (TFDV)

El más adecuado para:

-

- Validación de canalizaciones de datos en flujos de trabajo ML de producción

- Detección de anomalías en los esquemas y desviación de datos a escala

- Uso dentro del ecosistema TensorFlow Extended (TFX)

No es adecuado para:

-

- Limpieza general de datos

- Uso fuera de entornos TensorFlow o TFX

Los puntos fuertes y las limitaciones de estas herramientas dependen en última instancia del tamaño del proyecto, la complejidad y el entorno técnico. La combinación de herramientas (por ejemplo, Pandas para la limpieza y Scikit-learn para el escalado de características) suele proporcionar los mejores resultados.

Principales conclusiones y recursos

El preprocesamiento de datos es crucial para el proceso de aprendizaje automático. Transforma los datos brutos y desordenados en un conjunto de datos limpios y estructurados, listos para el entrenamiento del modelo. Incluye tareas como el tratamiento de los valores que faltan, la codificación de variables categóricas, el escalado de características y la ingeniería de otras nuevas, todo lo cual ayuda a mejorar la precisión y fiabilidad del modelo. Omitir el preprocesamiento suele dar lugar a un rendimiento deficiente y a resultados engañosos.

Herramientas como Pandas, Scikit-learn y TensorFlow simplifican el proceso, mientras que OpenRefine o Excel son útiles para tareas más ligeras o visuales.

Puede seguir aprendiendo sobre los distintos enfoques de la preparación de datos a través de los recursos que se indican a continuación:

-

- Guía para la fragmentación de datos

- Preparación de conjuntos de datos para el ajuste fino de modelos de ML: Una guía completa

- Guía paso a paso para preparar los datos para la generación mejorada por recuperación (RAG)

- Tratamiento por lotes - Conceptos

- ¿Qué es la minería de datos? Técnicas, herramientas y aplicaciones