Etiqueta: langchain

Integrar a inferência LLM rápida do Groq com a pesquisa vetorial do Couchbase

Integre a rápida inferência LLM do Groq com o Couchbase Vector Search para obter aplicativos RAG eficientes. Compare sua velocidade com a do OpenAI, Gemini e Ollama.

Do conceito ao código: LLM + RAG com Couchbase

Saiba como criar um mecanismo de recomendação de IA generativa usando LLM, RAG e integração com o Couchbase. Guia passo a passo para desenvolvedores.

Novos avanços do Couchbase Capella impulsionam o desenvolvimento

Impulsione o desenvolvimento orientado por IA com as atualizações mais recentes da Capella: análise em tempo real, pesquisa vetorial na borda e um nível gratuito para começar rapidamente.

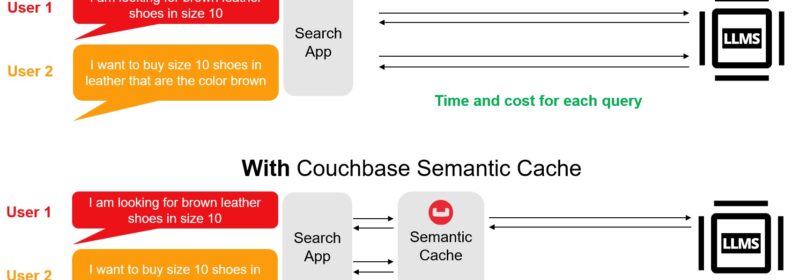

Crie aplicativos LLM mais rápidos e baratos com o Couchbase e o LangChain

O pacote LangChain-Couchbase integra a pesquisa vetorial, o cache semântico e o cache de conversação do Couchbase para fluxos de trabalho de IA generativa.

Comece a usar o Couchbase Vector Search em 5 minutos

A pesquisa vetorial e a pesquisa de texto completo são métodos usados para pesquisar em coleções de dados, mas operam de maneiras diferentes e são adequadas a diferentes tipos de dados e casos de uso.

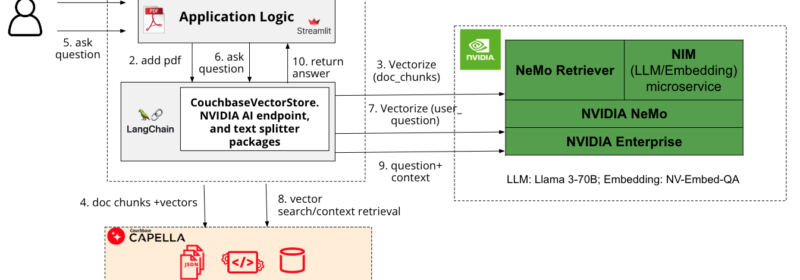

Acelere o aplicativo de IA RAG com base em Couchbase com NVIDIA NIM/NeMo e LangChain

Desenvolva um aplicativo GenAI interativo com respostas fundamentadas e relevantes usando o RAG baseado no Couchbase Capella e acelere-o usando o NVIDIA NIM/NeMo

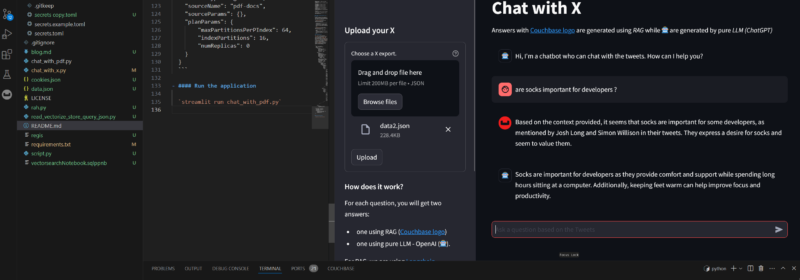

Twitter Thread tl;dr Com IA? Parte 2

Crie um aplicativo Streamlit que use LangChain e Vector Search para dados JSON extraídos do Twitter e indexados no banco de dados NoSQL do Couchbase para bate-papo interativo.

Principais publicações

- Capella AI Services: Build Enterprise-Grade Agents

- O início de um novo ciclo de nuvens

- O Enterprise Analytics agora está disponível no Microsoft Azure

- Explicação da modelagem de dados: Conceitual, físico, lógico

- Métodos de análise de dados: Técnicas qualitativas versus técnicas quantitativas

- N1QL E SEARCH: Aproveite o índice de pesquisa de texto completo (FTS) no N1QL

- O que são modelos de incorporação? Uma visão geral

- O que é análise de dados? Tipos, métodos e ferramentas para pesquisa

- Servidor Couchbase na atualização de aniversário do Windows 10