Primeiros passos com o Kubernetes 1.4 usando Spring Boot e Couchbase explica como começar a usar o Kubernetes 1.4 no Amazon Web Services. A

O serviço Couchbase é criado no cluster e um aplicativo Spring Boot armazena um documento JSON no banco de dados. Ele usa kube-up.sh a partir do download do binário do Kubernetes em github.com/kubernetes/kubernetes/releases/download/v1.4.0/kubernetes.tar.gz para iniciar o cluster. Esse script é capaz de criar um cluster do Kubernetes apenas com um único mestre. Essa é uma falha fundamental dos aplicativos distribuídos, em que o mestre se torna um ponto único de falha.

Conheça kops - abreviação de Kubernetes Operations.

Essa é a maneira mais fácil de colocar um cluster Kubernetes altamente disponível em funcionamento. O kubectl é a CLI para executar comandos em clusters em execução. Pense em kops como kubectl para cluster.

Este blog mostrará como criar um cluster Kubernetes altamente disponível na Amazon usando kops. Depois que o cluster for criado, ele criará um serviço Couchbase nele e executará um aplicativo Spring Boot para armazenar o documento JSON

no banco de dados.

Muito obrigado a justinsb, sarahz, lâminas, jaygorrell, shrugs, bkpandey e outros em Canal do Kubernetes no Slack por me ajudar com os detalhes!

Faça o download do kops e do kubectl

- Baixar Última versão do Kops. Este blog foi testado com 1.4.1 no OSX.Conjunto completo de comandos para

kopspode ser visto:

1234567891011121314151617181920212223242526272829303132333435kops-Darwin-amd64 --ajudakops é kubernetes operações.Ele permite você para criar, destruir, atualização e manter agrupamentos.Uso:kops [comando]Disponível Comandos:criar criar recursosexcluir excluir agrupamentosdescrever descrever objetoseditar editar itensexportação exportação agrupamentos/kubecfgobter lista ou obter objetosimportação importação agrupamentosrolante-atualização rolante atualização agrupamentossegredos Gerenciar segredos & chavescaixa de ferramentas Diversos com pouca frequência usado comandosatualização atualização agrupamentosatualização atualização agrupamentosversão Imprimir o cliente versão informaçõesBandeiras:--alsologtostderr registro para padrão erro como bem como arquivos--configuração string configuração arquivo (padrão é $INÍCIO/.kops.yaml)--log_backtrace_at traceLocation quando registro sucessos linha arquivo:N, emitir a pilha rastro (padrão :0)--log_dir string Se não-vazio, escrever registro arquivos em este diretório--logtostderr registro para padrão erro em vez disso de arquivos (padrão falso)--nome string Nome de agrupamento--estado string Localização de estado armazenamento--Limite de stderr severidade registros em ou acima este limite ir para stderr (padrão 2)-v, --v Nível registro nível para V registros--vmódulo moduleSpec vírgula-separados lista de padrão=N configurações para arquivo-filtrada registroUso "kops [comando] --help" para mais informações sobre a comando. - Baixar

kubectl:

1enrolar -Lo kubectl http://storage.googleapis.com/kubernetes-release/release/v1.4.1/bin/darwin/amd64/kubectl && chmod +x kubectl - Incluir

kubectlem seuPATH.

Criar registros de Bucket e NS na Amazon

No momento, há um pouco de configuração envolvida, e esperamos que isso seja resolvido nas próximas versões. Criação de um cluster no AWS fornecem etapas detalhadas e mais informações.

Aqui está o que o blog seguiu:

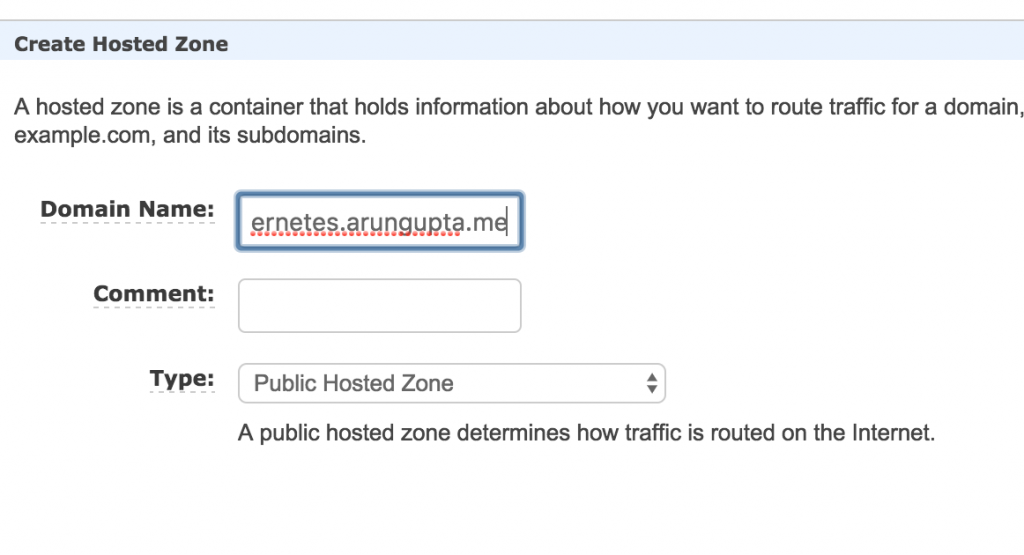

- Escolha um domínio onde o cluster do Kubernetes será hospedado. Este blog usa

kubernetes.arungupta.medomínio. Você pode escolher um domínio de nível superior ou um subdomínio. - Amazon Route 53 é um serviço de DNS altamente disponível e dimensionável. Faça login no Console da Amazon e criou um zona hospedada para esse domínio usando o serviço Route 53.

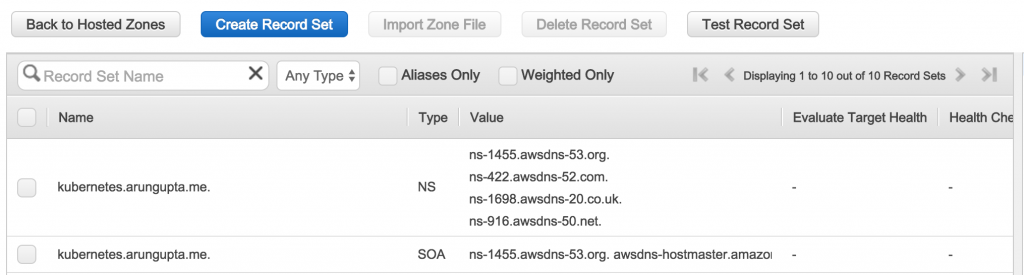

A zona criada tem a mesma aparência:

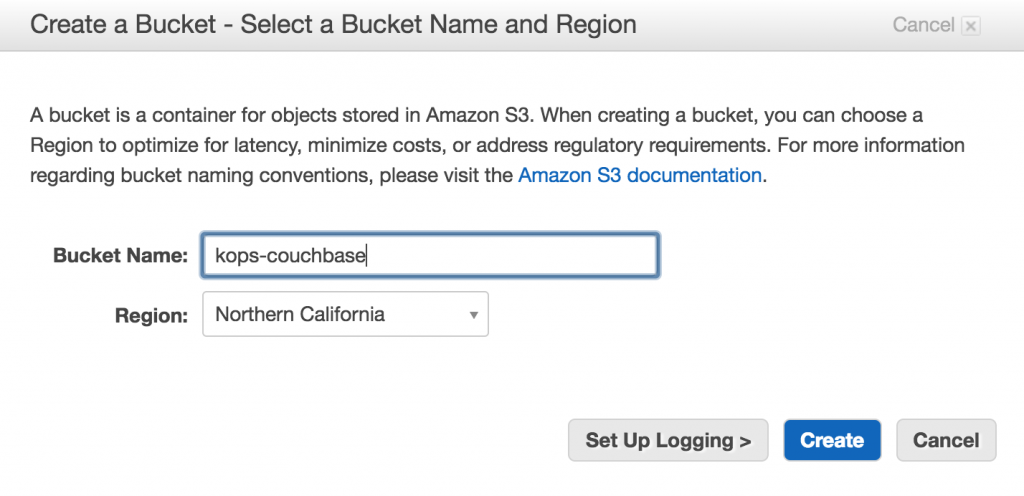

Os valores mostrados noValorsão importantes, pois serão usadas posteriormente para criar registros NS. - Crie um bucket S3 usando Console da Amazon para armazenar a configuração do cluster - isso é chamado de

loja estatal.

- O domínio

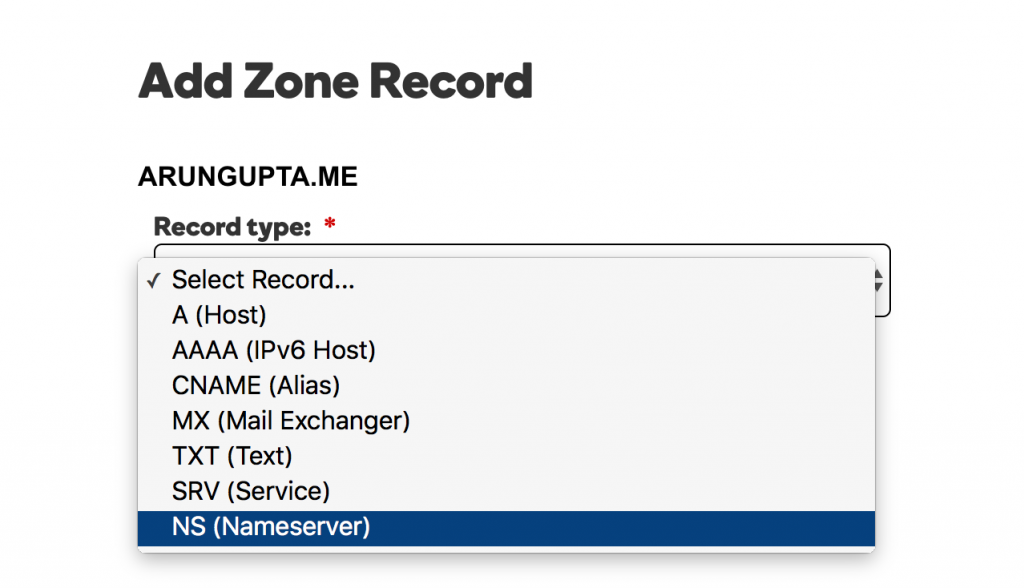

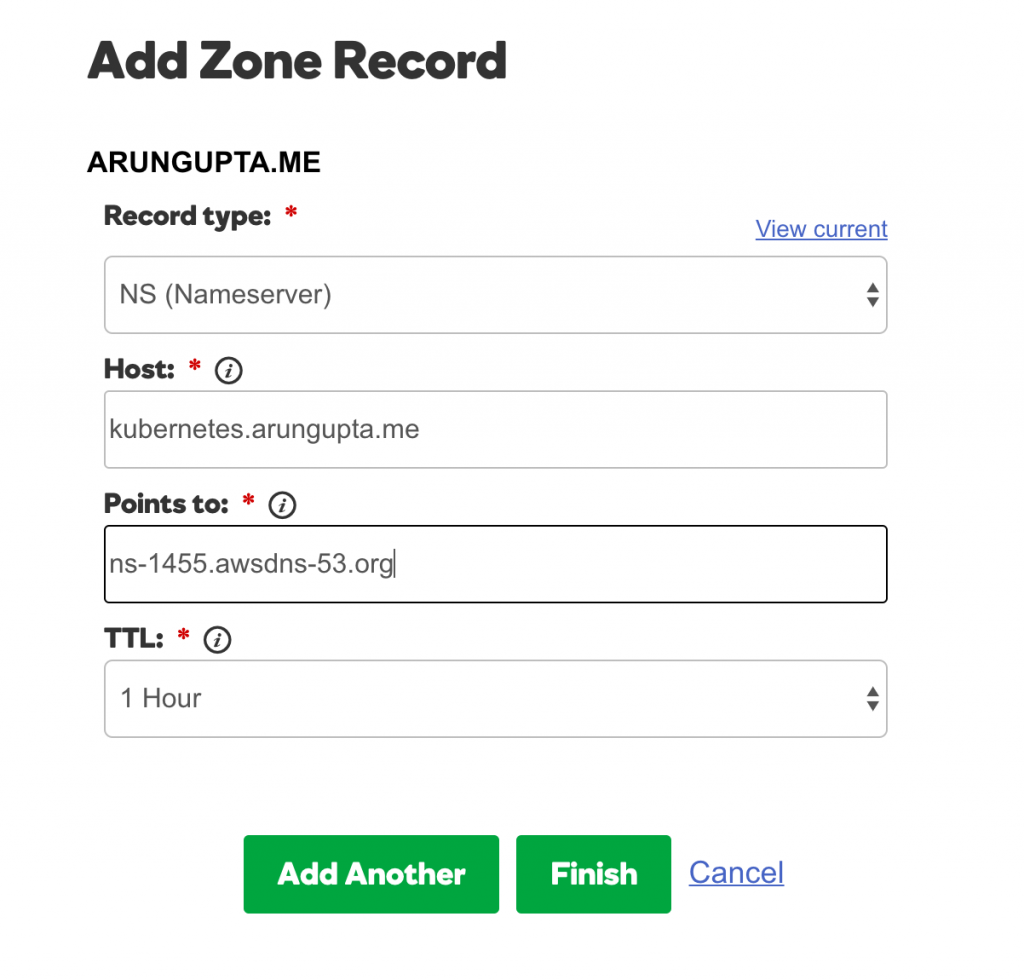

kubernetes.arungupta.meestá hospedado na GoDaddy. Para cada valor mostrado na coluna Value (Valor) da zona hospedada no Route53, crie um registro NS usando Centro de Controle de Domínios da GoDaddy para

Selecione o tipo de registro:

Para cada valor, adicione o registro conforme mostrado:

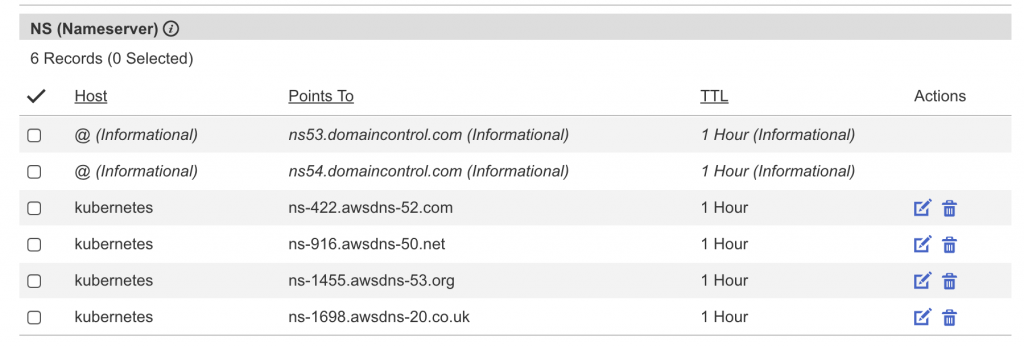

O conjunto completo de registros tem a seguinte aparência:

Iniciar o cluster multimaster do Kubernetes

Vamos entender um pouco sobre as regiões e zonas da Amazônia:

O Amazon EC2 está hospedado em vários locais em todo o mundo. Esses locais são compostos por regiões e zonas de disponibilidade. Cada região é uma área geográfica separada. Cada região tem vários locais isolados, conhecidos como Zonas de Disponibilidade.

Um cluster Kubernetes altamente disponível pode ser criado entre zonas, mas não entre regiões.

- Descubra as zonas de disponibilidade em uma região:

1234567891011121314151617181920212223aws ec2 descrever-disponibilidade-zonas --região nós-oeste-2{"AvailabilityZones" (zonas de disponibilidade): [{"Estado": "disponível","RegionName" (nome da região): "us-west-2","Mensagens": [],"ZoneName": "us-west-2a"},{"Estado": "disponível","RegionName" (nome da região): "us-west-2","Mensagens": [],"ZoneName": "us-west-2b"},{"Estado": "disponível","RegionName" (nome da região): "us-west-2","Mensagens": [],"ZoneName": "us-west-2c"}]} - Crie um cluster com vários mestres:

1kops-Darwin-amd64 criar agrupamento --nome=kubernetes.arungupta.eu --nuvem=aws --zonas=nós-oeste-2a,nós-oeste-2b,nós-oeste-2c --mestre-tamanho=m4.grande --nó-contagem=3 --nó-tamanho=m4.2xgrande --mestre-zonas=nós-oeste-2a,nós-oeste-2b,nós-oeste-2c --estado=s3://kops-couchbase --yes

A maioria dos switches é autoexplicativa. Alguns switches precisam de um pouco de explicação:- Especificação de várias zonas usando

--zonas-mestre(deve ser um número ímpar) criar vários mestres no AZ --cloud=awsé opcional se a nuvem puder ser inferida das zonas-simé usado para especificar a criação imediata do cluster. Caso contrário, somente o estado é armazenado no bucket, e o cluster precisa ser criado separadamente.

O conjunto completo de switches da CLI pode ser visto:

12345678910111213141516171819202122232425262728293031323334353637383940./kops-Darwin-amd64 criar agrupamento --ajudaCria a k8s agrupamento.Uso:kops criar agrupamento [bandeiras]Bandeiras:--administrador-acesso string Restringir acesso para administrador pontos finais (SSH, HTTPS) para este CIDR. Se não definir, acesso vontade não ser restrito por IP.--associado-público-ip Especificar --associado-público-ip=[verdadeiro|falso] para ativar/desativar associação de público IP para mestre ASG e nós. Padrão é 'true' (verdadeiro). (padrão verdadeiro)--canal string Canal para padrão versões e configuração para uso (padrão "estável")--nuvem string Nuvem provedor para uso - gce, aws--dns-zona string DNS hospedado zona para uso (padrões para último dois componentes de agrupamento nome)--imagem string Imagem para uso--kubernetes-versão string Versão de kubernetes para executar (padrões para versão em canal)--mestre-tamanho string Conjunto instância tamanho para mestres--mestre-zonas string Zonas em que para executar mestres (deve ser e estranho número)--modelo string Modelos para aplicar (separado múltiplos modelos com vírgulas) (padrão "config,proto,cloudup")--rede-cidr string Conjunto para anular o padrão rede CIDR--rede string Trabalho em rede modo para uso. kubenet (padrão), clássico, externo. (padrão "kubenet")--nó-contagem int Conjunto o número de nós--nó-tamanho string Conjunto instância tamanho para nós--fora string Caminho para escrever qualquer local saída--projeto string Projeto para uso (deve ser definir em GCE)--ssh-público-chave string SSH público chave para uso (padrão "~/.ssh/id_rsa.pub")--alvo string Alvo - direto, terraformação (padrão "direto")--vpc string Conjunto para uso a compartilhada VPC--sim Especificar --sim para imediatamente criar o agrupamento--zonas string Zonas em que para executar o agrupamentoGlobal Bandeiras:--alsologtostderr registro para padrão erro como bem como arquivos--configuração string configuração arquivo (padrão é $INÍCIO/.kops.yaml)--log_backtrace_at traceLocation quando registro sucessos linha arquivo:N, emitir a pilha rastro (padrão :0)--log_dir string Se não-vazio, escrever registro arquivos em este diretório--logtostderr registro para padrão erro em vez disso de arquivos (padrão falso)--nome string Nome de agrupamento--estado string Localização de estado armazenamento--Limite de stderr severidade registros em ou acima este limite ir para stderr (padrão 2)-v, --v Nível registro nível para V registros--vmódulo moduleSpec vírgula-separados lista de padrão=N configurações para arquivo-filtrada registro - Especificação de várias zonas usando

- Depois que o cluster for criado, obtenha mais detalhes sobre o cluster:

12345kubectl agrupamento-informaçõesKubernetes mestre é em execução em https://api.kubernetes.arungupta.meKubeDNS é em execução em https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dnsPara mais depurar e diagnosticar agrupamento problemas, uso 'kubectl cluster-info dump'.

- Verifique a versão do cliente e do servidor do cluster:

123kubectl versãoCliente Versão: versão.Informações{Maior:"1", Menor:"4", GitVersion:"v1.4.1", GitCommit:"33cf7b9acbb2cb7c9c72a10d6636321fb180b159", Estado do GitTree:"limpo", BuildDate:"2016-10-10T18:19:49Z", GoVersion:"go1.7.1", Compilador:"gc", Plataforma:"darwin/amd64"}Servidor Versão: versão.Informações{Maior:"1", Menor:"4", GitVersion:"v1.4.3", GitCommit:"4957b090e9a4f6a68b4a40375408fdc74a212260", Estado do GitTree:"limpo", BuildDate:"2016-10-16T06:20:04Z", GoVersion:"go1.6.3", Compilador:"gc", Plataforma:"linux/amd64"}

- Verifique todos os nós do cluster:

12345678kubectl obter nósNOME STATUS IDADEip-172-20-111-151.us-oeste-2.compute.internal Pronto 1hip-172-20-116-40.us-oeste-2.compute.internal Pronto 1hip-172-20-48-41.us-oeste-2.compute.internal Pronto 1hip-172-20-49-105.us-oeste-2.compute.internal Pronto 1hip-172-20-80-233.us-oeste-2.compute.internal Pronto 1hip-172-20-82-93.us-oeste-2.compute.internal Pronto 1h

Ou descobrir apenas os nós mestres:

12345kubectl obter nós -l kubernetes.io/função=mestreNOME STATUS IDADEip-172-20-111-151.us-oeste-2.compute.internal Pronto 1hip-172-20-48-41.us-oeste-2.compute.internal Pronto 1hip-172-20-82-93.us-oeste-2.compute.internal Pronto 1h - Verifique todos os clusters:

123kops-Darwin-amd64 obter agrupamentos --estado=s3://kops-couchbaseNOME NUVEM ZONASkubernetes.arungupta.eu aws nós-oeste-2a,nós-oeste-2b,nós-oeste-2c

Complemento do painel do Kubernetes

Por padrão, um cluster criado com o kops não tem o painel da interface do usuário. Mas ele pode ser adicionado como um complemento:

|

1 2 3 |

kubectl criar -f https://raw.githubusercontent.com/kubernetes/kops/master/addons/kubernetes-dashboard/v1.4.0.yaml implantação "kubernetes-dashboard-v1.4.0" criado serviço "kubernetes-dashboard" criado |

Agora, os detalhes completos sobre o cluster podem ser vistos:

|

1 2 3 4 5 6 |

kubectl agrupamento-informações Kubernetes mestre é em execução em https://api.kubernetes.arungupta.me KubeDNS é em execução em https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dns kubernetes-painel de controle é em execução em https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kubernetes-dashboard Para mais depurar e diagnosticar agrupamento problemas, uso 'kubectl cluster-info dump'. |

E o painel da interface do usuário do Kubernetes está no URL mostrado. No nosso caso, ele é https://api.kubernetes.arungupta.me/ui e se parece com isso:

As credenciais para acessar esse painel podem ser obtidas usando o Visualização de configuração do kubectl comando. Os valores são mostrados da seguinte forma:

|

1 2 3 4 |

- nome: kubernetes.arungupta.eu-básico-autenticação usuário: senha: SENHA nome de usuário: administrador |

Implantar o serviço Couchbase

Conforme explicado em Primeiros passos com o Kubernetes 1.4 usando Spring Boot e CouchbaseVamos executar um serviço do Couchbase:

|

1 2 3 |

kubectl criar -f ~/espaços de trabalho/kubernetes-java-amostra/mentor/couchbase-serviço.yml serviço "couchbase-service" criado controlador de replicação "couchbase-rc" criado |

Esse arquivo de configuração está em github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/couchbase-service.yml. Obtenha a lista de serviços:

|

1 2 3 4 |

kubectl obter serviço NOME CLUSTER-IP EXTERNO-IP PORTO(S) IDADE couchbase-serviço 100.65.4.139 8091/TCP,8092/TCP,8093/TCP,11210/TCP 27s kubernetes 100.64.0.1 443/TCP 2h |

Descreva o serviço:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 |

kubectl descrever serviço/couchbase-serviço Nome: couchbase-serviço Namespace: padrão Rótulos: Seletor: aplicativo=couchbase-rc-cápsula Tipo: ClusterIP IP: 100.65.4.139 Porto: administrador 8091/TCP Pontos finais: 100.96.5.2:8091 Porto: visualizações 8092/TCP Pontos finais: 100.96.5.2:8092 Porto: consulta 8093/TCP Pontos finais: 100.96.5.2:8093 Porto: memcached 11210/TCP Pontos finais: 100.96.5.2:11210 Sessão Afinidade: Nenhum |

Obtenha as cápsulas:

|

1 2 3 |

kubectl obter cápsulas NOME PRONTO STATUS RESTARTS IDADE couchbase-rc-e35v5 1/1 Em execução 0 1m |

Executar o aplicativo Spring Boot

O aplicativo Spring Boot é executado no serviço Couchbase e armazena um documento JSON nele. Inicie o aplicativo Spring Boot:

|

1 2 |

kubectl criar -f ~/espaços de trabalho/kubernetes-java-amostra/mentor/bonito-couchbase.yml trabalho "bootiful-couchbase" criado |

Esse arquivo de configuração está em github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/bootiful-couchbase.yml. Veja a lista de todos os pods:

|

1 2 3 4 |

kubectl obter cápsulas --show-todos NOME PRONTO STATUS RESTARTS IDADE bonito-couchbase-ainv8 0/1 Concluído 0 1m couchbase-rc-e35v5 1/1 Em execução 0 3m |

Verifique os registros do pod completo:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 |

kubectl registros bonito-couchbase-ainv8 . ____ _ __ _ _ /\ / ___'_ __ _ _(_)_ __ __ _ ( ( )___ | '_ | '_| | '_ / _` | \/ ___)| |_)| | | | | || (_| | ) ) ) ) ' |____| .__|_| |_|_| |___, | / / / / =========|_|==============|___/=/_/_/_/ :: Spring Boot :: (v1.4.0.RELEASE) 2016-11-02 18:48:56.035 INFO 7 --- [ main] org.example.webapp.Application : Iniciando o aplicativo v1.0-SNAPSHOT em bootiful-couchbase-ainv8 com PID 7 (/maven/bootiful-couchbase.jar iniciado pelo root em /) 2016-11-02 18:48:56.040 INFO 7 --- [ main] org.example.webapp.Application : Nenhum perfil ativo definido, voltando aos perfis padrão: default 2016-11-02 18:48:56.115 INFO 7 --- [ main] s.c.a.AnnotationConfigApplicationContext : Atualizando org.springframework.context.annotation.AnnotationConfigApplicationContext@108c4c35: data de inicialização [Wed Nov 02 18:48:56 UTC 2016]; raiz da hierarquia de contexto 2016-11-02 18:48:57.021 INFO 7 --- [ main] com.couchbase.client.core.CouchbaseCore : CouchbaseEnvironment: {sslEnabled=false, sslKeystoreFile='nulo', sslKeystorePassword='nulo', queryEnabled=falso, queryPort=8093, bootstrapHttpEnabled=verdadeiro, bootstrapCarrierEnabled=verdadeiro, bootstrapHttpDirectPort=8091, bootstrapHttpSslPort=18091, bootstrapCarrierDirectPort=11210, bootstrapCarrierSslPort=11207, ioPoolSize=8, computationPoolSize=8, responseBufferSize=16384, requestBufferSize=16384, kvServiceEndpoints=1, viewServiceEndpoints=1, queryServiceEndpoints=1, searchServiceEndpoints=1, ioPool=NioEventLoopGroup, coreScheduler=Agendador principal, eventBus=DefaultEventBus, packageNameAndVersion (nome do pacote e versão)=couchbase-java-cliente/2.2.8 (git: 2.2.8, núcleo: 1.2.9), dcpEnabled=falso, retryStrategy=BestEffort, maxRequestLifetime=75000, retryDelay=ExponentialDelay (Atraso Exponencial){crescerPor 1.0 MICROSSEGUNDOS, poderes de 2; inferior=100, superior=100000}, reconnectDelay=ExponentialDelay (Atraso Exponencial){crescerPor 1.0 MILISSEGUNDOS, poderes de 2; inferior=32, superior=4096}, observeIntervalDelay=ExponentialDelay (Atraso Exponencial){crescerPor 1.0 MICROSSEGUNDOS, poderes de 2; inferior=10, superior=100000}, keepAliveInterval=30000, autoreleaseAfter=2000, bufferPoolingEnabled=verdadeiro, tcpNodelayEnabled=verdadeiro, mutationTokensEnabled=falso, socketConnectTimeout=1000, dcpConnectionBufferSize=20971520, dcpConnectionBufferAckThreshold=0.2, dcpConnectionName=dcp/núcleo-io, callbacksOnIoPool=falso, tempo limite de consulta=7500, viewTimeout=7500, kvTimeout=2500, connectTimeout=5000, tempo limite de desconexão=25000, dnsSrvEnabled=falso} 2016-11-02 18:48:57.245 INFORMAÇÕES 7 --- [ cb-io-1-1] com.couchbase.cliente.núcleo.nó.Nó : Conectado para Nó couchbase-serviço 2016-11-02 18:48:57.291 INFORMAÇÕES 7 --- [ cb-io-1-1] com.couchbase.cliente.núcleo.nó.Nó : Desconectado de Nó couchbase-serviço 2016-11-02 18:48:57.533 INFORMAÇÕES 7 --- [ cb-io-1-2] com.couchbase.cliente.núcleo.nó.Nó : Conectado para Nó couchbase-serviço 2016-11-02 18:48:57.638 INFORMAÇÕES 7 --- [-cálculos-4] c.c.c.núcleo.configuração.Provedor de configuração : Aberto balde livros 2016-11-02 18:48:58.152 INFORMAÇÕES 7 --- [ principal] o.s.j.e.a.Exportador de AnotaçãoMBean : Registro feijões para JMX exposição em inicialização Livro{isbn=978-1-4919-1889-0, nome=Minecraft Modificação com Forja, custo=29.99} 2016-11-02 18:48:58.402 INFORMAÇÕES 7 --- [ principal] org.exemplo.aplicativo da web.Aplicativo : Iniciado Aplicativo em 2.799 segundos (JVM em execução para 3.141) 2016-11-02 18:48:58.403 INFORMAÇÕES 7 --- [ Tópico-5] s.c.a.AnnotationConfigApplicationContext : Fechamento org.estrutura de mola.contexto.anotação.AnnotationConfigApplicationContext@108c4c35: inicialização data [Quarta Nov 02 18:48:56 UTC 2016]; raiz de contexto hierarquia 2016-11-02 18:48:58.404 INFORMAÇÕES 7 --- [ Tópico-5] o.s.j.e.a.Exportador de AnotaçãoMBean : Cancelamento de registro JMX-exposto feijões em desligamento 2016-11-02 18:48:58.410 INFORMAÇÕES 7 --- [ cb-io-1-2] com.couchbase.cliente.núcleo.nó.Nó : Desconectado de Nó couchbase-serviço 2016-11-02 18:48:58.410 INFORMAÇÕES 7 --- [ Tópico-5] c.c.c.núcleo.configuração.Provedor de configuração : Fechado balde livros |

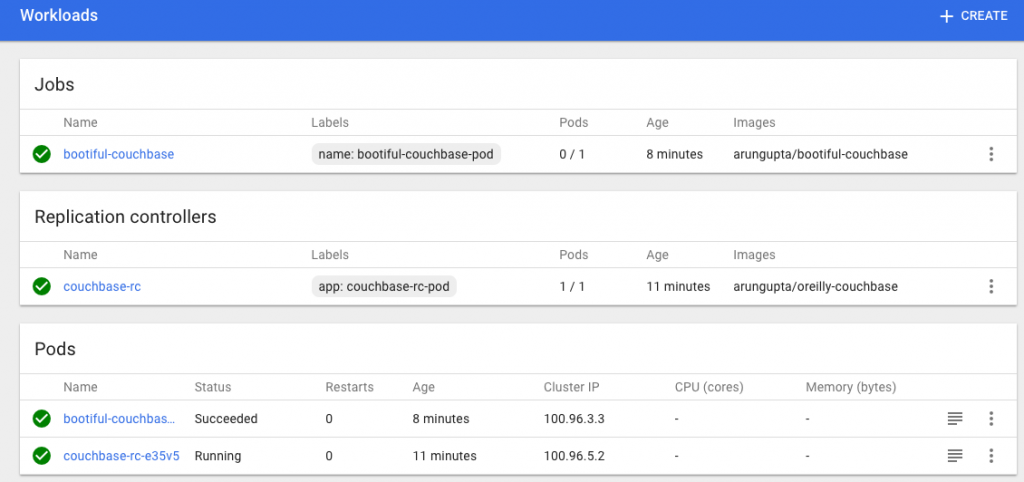

O painel atualizado agora tem a seguinte aparência:

Excluir o cluster do Kubernetes

O cluster do Kubernetes pode ser excluído como:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 |

kops-Darwin-amd64 excluir agrupamento --nome=kubernetes.arungupta.eu --estado=s3://kops-couchbase --yes TIPO NOME ID dimensionamento automático-configuração mestre-nós-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 mestre-nós-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 dimensionamento automático-configuração mestre-nós-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 mestre-nós-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 dimensionamento automático-configuração mestre-nós-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 mestre-nós-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 dimensionamento automático-configuração nós.kubernetes.arungupta.eu-20161101235639 nós.kubernetes.arungupta.eu-20161101235639 dimensionamento automático-grupo mestre-nós-oeste-2a.masters.kubernetes.arungupta.me mestre-nós-oeste-2a.masters.kubernetes.arungupta.me dimensionamento automático-grupo mestre-nós-oeste-2b.masters.kubernetes.arungupta.me mestre-nós-oeste-2b.masters.kubernetes.arungupta.me dimensionamento automático-grupo mestre-nós-oeste-2c.masters.kubernetes.arungupta.me mestre-nós-oeste-2c.masters.kubernetes.arungupta.me dimensionamento automático-grupo nós.kubernetes.arungupta.eu nós.kubernetes.arungupta.eu dhcp-opções kubernetes.arungupta.eu dopt-9b7b08ff iam-instância-perfil mestres.kubernetes.arungupta.eu mestres.kubernetes.arungupta.eu iam-instância-perfil nós.kubernetes.arungupta.eu nós.kubernetes.arungupta.eu iam-função mestres.kubernetes.arungupta.eu mestres.kubernetes.arungupta.eu iam-função nós.kubernetes.arungupta.eu nós.kubernetes.arungupta.eu instância mestre-nós-oeste-2a.masters.kubernetes.arungupta.me i-8798eb9f instância mestre-nós-oeste-2b.masters.kubernetes.arungupta.me i-eca96ab3 instância mestre-nós-oeste-2c.masters.kubernetes.arungupta.me i-63fd3dbf instância nós.kubernetes.arungupta.eu i-21a96a7e instância nós.kubernetes.arungupta.eu i-57fb3b8b instância nós.kubernetes.arungupta.eu i-5c99ea44 Internet-portal kubernetes.arungupta.eu igw-b624abd2 par de chaves kubernetes.kubernetes.arungupta.eu-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 kubernetes.kubernetes.arungupta.eu-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 rota-tabela kubernetes.arungupta.eu rtb-e44df183 rota53-registro API.interno.kubernetes.arungupta.eu. Z6I41VJM5VCZV/API.interno.kubernetes.arungupta.eu. rota53-registro API.kubernetes.arungupta.eu. Z6I41VJM5VCZV/API.kubernetes.arungupta.eu. rota53-registro etcd-eventos-nós-oeste-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-nós-oeste-2a.internal.kubernetes.arungupta.me. rota53-registro etcd-eventos-nós-oeste-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-nós-oeste-2b.internal.kubernetes.arungupta.me. rota53-registro etcd-eventos-nós-oeste-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-nós-oeste-2c.internal.kubernetes.arungupta.me. rota53-registro etcd-nós-oeste-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-nós-oeste-2a.internal.kubernetes.arungupta.me. rota53-registro etcd-nós-oeste-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-nós-oeste-2b.internal.kubernetes.arungupta.me. rota53-registro etcd-nós-oeste-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-nós-oeste-2c.internal.kubernetes.arungupta.me. segurança-grupo mestres.kubernetes.arungupta.eu sg-3e790f47 segurança-grupo nós.kubernetes.arungupta.eu sg-3f790f46 sub-rede nós-oeste-2a.kubernetes.arungupta.me sub-rede-3cdbc958 sub-rede nós-oeste-2b.kubernetes.arungupta.me sub-rede-18c3f76e sub-rede nós-oeste-2c.kubernetes.arungupta.me sub-rede-b30f6deb volume nós-oeste-2a.etcd-eventos.kubernetes.arungupta.eu vol-202350a8 volume nós-oeste-2a.etcd-principal.kubernetes.arungupta.eu vol-0a235082 volume nós-oeste-2b.etcd-eventos.kubernetes.arungupta.eu vol-401f5bf4 volume nós-oeste-2b.etcd-principal.kubernetes.arungupta.eu vol-691f5bdd volume nós-oeste-2c.etcd-eventos.kubernetes.arungupta.eu vol-aefe163b volume nós-oeste-2c.etcd-principal.kubernetes.arungupta.eu vol-e9fd157c vpc kubernetes.arungupta.eu vpc-e5f50382 Internet-portal:igw-b624abd2 ainda tem dependências, vontade tentar novamente par de chaves:kubernetes.kubernetes.arungupta.eu-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 ok instância:i-5c99ea44 ok instância:i-63fd3dbf ok instância:i-eca96ab3 ok instância:i-21a96a7e ok dimensionamento automático-grupo:mestre-nós-oeste-2a.masters.kubernetes.arungupta.me ok dimensionamento automático-grupo:mestre-nós-oeste-2b.masters.kubernetes.arungupta.me ok dimensionamento automático-grupo:mestre-nós-oeste-2c.masters.kubernetes.arungupta.me ok dimensionamento automático-grupo:nós.kubernetes.arungupta.eu ok iam-instância-perfil:nós.kubernetes.arungupta.eu ok iam-instância-perfil:mestres.kubernetes.arungupta.eu ok instância:i-57fb3b8b ok instância:i-8798eb9f ok rota53-registro:Z6I41VJM5VCZV/etcd-eventos-nós-oeste-2a.internal.kubernetes.arungupta.me. ok iam-função:nós.kubernetes.arungupta.eu ok iam-função:mestres.kubernetes.arungupta.eu ok dimensionamento automático-configuração:nós.kubernetes.arungupta.eu-20161101235639 ok dimensionamento automático-configuração:mestre-nós-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 ok sub-rede:sub-rede-b30f6deb ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-3cdbc958 ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-18c3f76e ainda tem dependências, vontade tentar novamente dimensionamento automático-configuração:mestre-nós-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 ok dimensionamento automático-configuração:mestre-nós-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 ok volume:vol-0a235082 ainda tem dependências, vontade tentar novamente volume:vol-202350a8 ainda tem dependências, vontade tentar novamente volume:vol-401f5bf4 ainda tem dependências, vontade tentar novamente volume:vol-e9fd157c ainda tem dependências, vontade tentar novamente volume:vol-aefe163b ainda tem dependências, vontade tentar novamente volume:vol-691f5bdd ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3f790f46 ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3e790f47 ainda tem dependências, vontade tentar novamente Não todos recursos excluído; esperando antes de nova tentativa exclusão Internet-portal:igw-b624abd2 segurança-grupo:sg-3f790f46 volume:vol-aefe163b rota-tabela:rtb-e44df183 volume:vol-401f5bf4 sub-rede:sub-rede-18c3f76e segurança-grupo:sg-3e790f47 volume:vol-691f5bdd sub-rede:sub-rede-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-opções:dopt-9b7b08ff sub-rede:sub-rede-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382 Internet-portal:igw-b624abd2 ainda tem dependências, vontade tentar novamente volume:vol-e9fd157c ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-3cdbc958 ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-18c3f76e ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-b30f6deb ainda tem dependências, vontade tentar novamente volume:vol-0a235082 ainda tem dependências, vontade tentar novamente volume:vol-aefe163b ainda tem dependências, vontade tentar novamente volume:vol-691f5bdd ainda tem dependências, vontade tentar novamente volume:vol-202350a8 ainda tem dependências, vontade tentar novamente volume:vol-401f5bf4 ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3f790f46 ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3e790f47 ainda tem dependências, vontade tentar novamente Não todos recursos excluído; esperando antes de nova tentativa exclusão sub-rede:sub-rede-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382 Internet-portal:igw-b624abd2 segurança-grupo:sg-3f790f46 volume:vol-aefe163b rota-tabela:rtb-e44df183 volume:vol-401f5bf4 sub-rede:sub-rede-18c3f76e segurança-grupo:sg-3e790f47 volume:vol-691f5bdd sub-rede:sub-rede-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-opções:dopt-9b7b08ff sub-rede:sub-rede-18c3f76e ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-b30f6deb ainda tem dependências, vontade tentar novamente Internet-portal:igw-b624abd2 ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-3cdbc958 ainda tem dependências, vontade tentar novamente volume:vol-691f5bdd ainda tem dependências, vontade tentar novamente volume:vol-0a235082 ainda tem dependências, vontade tentar novamente volume:vol-202350a8 ainda tem dependências, vontade tentar novamente volume:vol-401f5bf4 ainda tem dependências, vontade tentar novamente volume:vol-aefe163b ainda tem dependências, vontade tentar novamente volume:vol-e9fd157c ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3e790f47 ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3f790f46 ainda tem dependências, vontade tentar novamente Não todos recursos excluído; esperando antes de nova tentativa exclusão Internet-portal:igw-b624abd2 segurança-grupo:sg-3f790f46 volume:vol-aefe163b rota-tabela:rtb-e44df183 volume:vol-401f5bf4 sub-rede:sub-rede-18c3f76e segurança-grupo:sg-3e790f47 volume:vol-691f5bdd sub-rede:sub-rede-3cdbc958 volume:vol-202350a8 volume:vol-0a235082 dhcp-opções:dopt-9b7b08ff sub-rede:sub-rede-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382 sub-rede:sub-rede-b30f6deb ainda tem dependências, vontade tentar novamente volume:vol-202350a8 ainda tem dependências, vontade tentar novamente Internet-portal:igw-b624abd2 ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-18c3f76e ainda tem dependências, vontade tentar novamente volume:vol-e9fd157c ainda tem dependências, vontade tentar novamente volume:vol-aefe163b ainda tem dependências, vontade tentar novamente volume:vol-401f5bf4 ainda tem dependências, vontade tentar novamente volume:vol-691f5bdd ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3e790f47 ainda tem dependências, vontade tentar novamente segurança-grupo:sg-3f790f46 ainda tem dependências, vontade tentar novamente sub-rede:sub-rede-3cdbc958 ainda tem dependências, vontade tentar novamente volume:vol-0a235082 ainda tem dependências, vontade tentar novamente Não todos recursos excluído; esperando antes de nova tentativa exclusão Internet-portal:igw-b624abd2 segurança-grupo:sg-3f790f46 volume:vol-aefe163b rota-tabela:rtb-e44df183 sub-rede:sub-rede-18c3f76e segurança-grupo:sg-3e790f47 volume:vol-691f5bdd volume:vol-401f5bf4 volume:vol-202350a8 sub-rede:sub-rede-3cdbc958 volume:vol-0a235082 dhcp-opções:dopt-9b7b08ff sub-rede:sub-rede-b30f6deb volume:vol-e9fd157c vpc:vpc-e5f50382 sub-rede:sub-rede-18c3f76e ok volume:vol-e9fd157c ok volume:vol-401f5bf4 ok volume:vol-0a235082 ok volume:vol-691f5bdd ok sub-rede:sub-rede-3cdbc958 ok volume:vol-aefe163b ok sub-rede:sub-rede-b30f6deb ok Internet-portal:igw-b624abd2 ok volume:vol-202350a8 ok segurança-grupo:sg-3f790f46 ok segurança-grupo:sg-3e790f47 ok rota-tabela:rtb-e44df183 ok vpc:vpc-e5f50382 ok dhcp-opções:dopt-9b7b08ff ok Aglomerado excluído |

couchbase.com/containers fornecem mais detalhes sobre como executar o Couchbase em diferentes estruturas de contêineres. Mais informações sobre o Couchbase: