Para os líderes e desenvolvedores de tecnologia, o processo de integração de dados ricos e proprietários em aplicativos de IA generativa geralmente é cheio de desafios. A pesquisa de similaridade vetorial e a geração aumentada de recuperação são ferramentas poderosas para ajudar nisso, mas um erro ao extrair, dividir ou vetorizar seus dados pode significar a diferença entre um agente de IA com bom desempenho e outro que frustra os usuários com respostas ruins e alucinações. Hoje, temos o prazer de anunciar que a criação de índices vetoriais altamente otimizados no Capella ficou muito mais fácil!

Isso porque as equipes da Couchbase e da Vectorize têm trabalhado arduamente para trazer o poder dos experimentos da Vectorize para o Couchbase Capella, uma plataforma DBaaS para que você comece rapidamente a usar seu RAG-Aplicativo GenAI com tecnologia de ponta. Alavancagem essa integração, você pode encontrar rapidamente o melhor modelo de incorporação de textoestratégias de fragmentação e parâmetros de recuperação para maximizar a relevância de seus resultados de pesquisa sem escrever uma única linha de código.

Para qualquer pessoa que esteja criando aplicativos com LLM usando o Capella como base de conhecimento para o RAG, isso é um divisor de águas que permitirá que você crie aplicativos de IA generativa melhores e mais precisos em uma fração do tempo, sem a necessidade de tentativa e erro para descobrir a melhor estratégia de vetorização para seus dados.

Recursos e capacidades

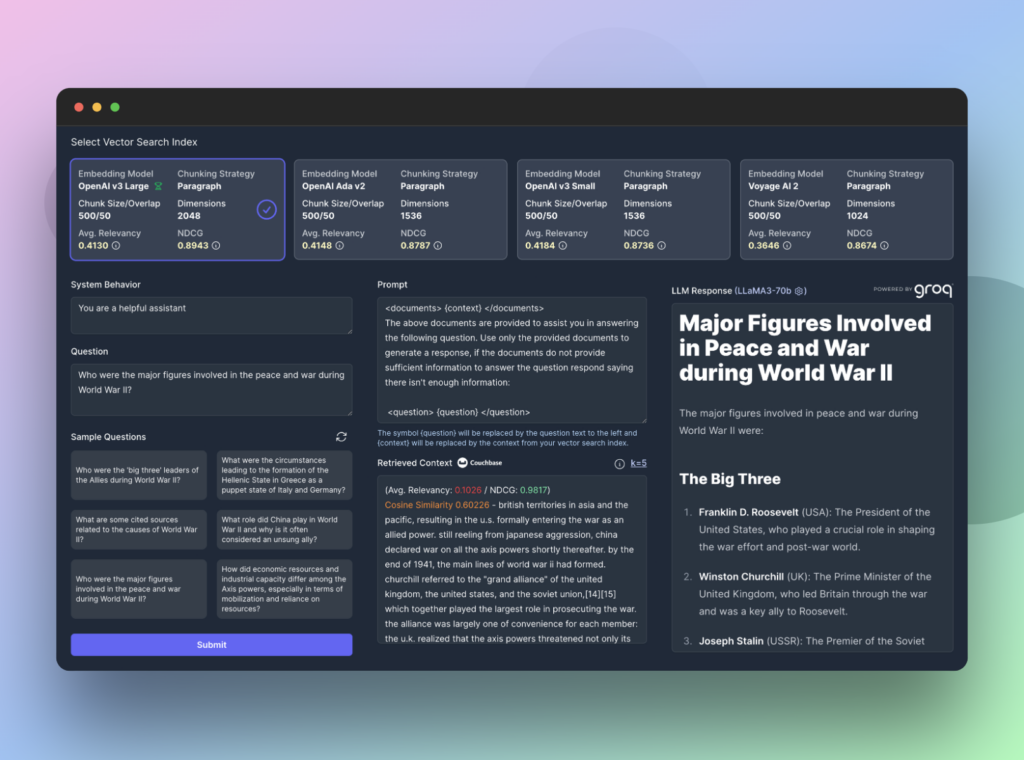

Ao executar um experimento no Vectorize, você criará até 4 índices de pesquisa vetorial diferentes no Couchbase Capella simultaneamente. Esses índices são preenchidos a partir de um conjunto de documentos que você carrega e cada índice de pesquisa é preenchido usando os modelos de incorporação e as estratégias de fragmentação que você especificar.

Com base nos seus documentos, o Vectorize gerará um conjunto de perguntas sintéticas que permitem prever os tipos de perguntas que os usuários podem fazer sobre os seus dados. Em seguida, o Vectorize recupera o contexto mais relevante para cada pergunta, pontuando os resultados que são retornados do Capella usando um algoritmo de relevância e um ganho cumulativo com desconto normalizado.

O resultado líquido são dados concretos que mostram com precisão o desempenho de diferentes estratégias de vetorização em seus dados. No entanto, a jornada não termina aí.

Usando o Vectorize RAG Sandbox, você pode explorar ainda mais seus dados em uma interface interativa ao vivo que fornece uma interface de ponta a ponta para testar seus fluxos de Retrieval Augmented Generation. Você pode usar uma das perguntas sintéticas do experimento ou inserir seu próprio prompt para ver exatamente o que foi retornado pelo Capella e inspecionar como diferentes modelos de linguagem grande respondem à sua consulta.

Com o Vectorize e o Capella como base de conhecimento, você pode criar uma solução de Pipeline RAG para garantir que seus aplicativos de IA de geração e agentes de IA sempre tenham o contexto mais relevante. Isso significa usuários mais felizes e menos alucinações dos seus LLMs!

Inscreva-se e comece a fazer experiências gratuitamente!

Para começar, Inscreva-se para obter uma conta gratuita da Vectorize e um Conta de avaliação de 30 dias para Capella para executar seu primeiro experimento hoje mesmo!