Las incrustaciones LLM son representaciones numéricas de palabras, frases u otros datos que captan el significado semántico, lo que permite un procesamiento eficaz de los textos, la búsqueda de similitudes y la recuperación en aplicaciones de IA. Se generan mediante transformaciones de redes neuronales, en particular utilizando mecanismos de autoatención en modelos transformadores como GPT y BERT, y pueden ajustarse para tareas específicas de cada dominio. Estas incrustaciones potencian una amplia gama de aplicaciones, incluyendo motores de búsqueda, sistemas de recomendación, asistentes virtuales y agentes de IA, con herramientas como Couchbase Capella™ que agilizan su integración en soluciones del mundo real.

¿Qué son las incrustaciones LLM?

Las incrustaciones LLM son representaciones numéricas de palabras, frases u otros tipos de datos que capturan el significado semántico en un espacio de alta dimensión. Permiten grandes modelos lingüísticos (LLM) para procesar, comparar y recuperar texto de forma eficaz. En lugar de manejar directamente el texto en bruto, los LLM convierten los datos de entrada en vectores que agrupan significados similares. Esta agrupación permite la comprensión contextual, búsqueda de similitudesy la recuperación eficaz de conocimientos para una amplia variedad de tareas, como la comprensión del lenguaje natural y los sistemas de recomendación.

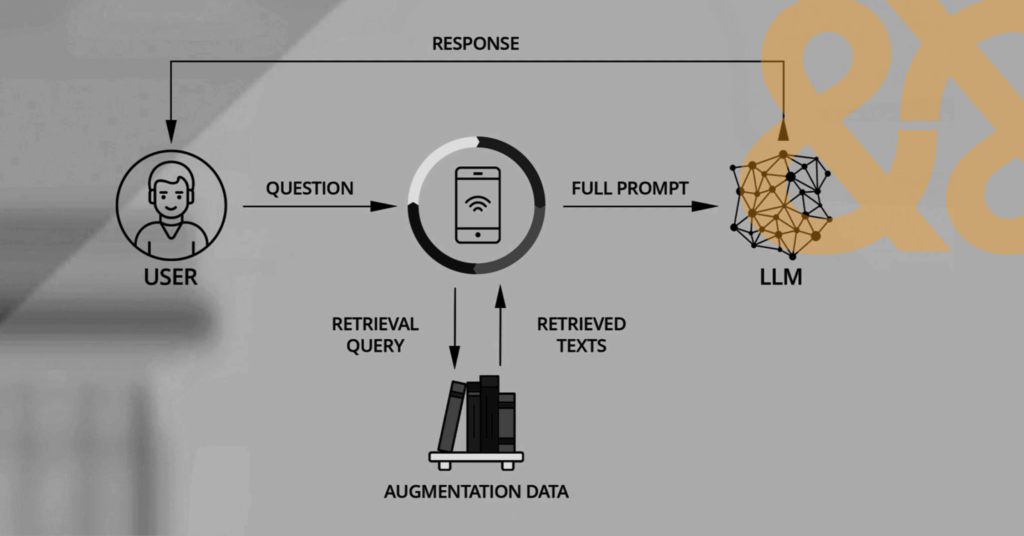

Una aplicación típica que ayuda a crear incrustaciones a partir de datos introducidos por el usuario para preparar su uso por un LLM.

¿Cómo funcionan las incrustaciones?

Los LLM crean incrustaciones haciendo pasar el texto por capas de transformaciones de redes neuronales que mapean los tokens de entrada en el espacio vectorial. Estas transformaciones captan las relaciones sintácticas y semánticas para garantizar que las palabras con significados similares tengan representaciones vectoriales más parecidas. Los modelos basados en transformadores, como GPT y BERT utilizan mecanismos de autoatención para asignar un peso contextual a las palabras y perfeccionar las incrustaciones en función de las palabras circundantes. Al convertir las palabras en forma numérica, las incrustaciones permiten realizar comparaciones de similitud, agrupaciones y operaciones de recuperación eficientes.

También puede afinar las incrustaciones preentrenadas para aplicaciones específicas de dominio con el fin de mejorar el rendimiento en tareas especializadas como la recuperación de documentos jurídicos o médicos. Para optimizar aún más los resultados, puede utilizar generación aumentada por recuperación (RAG) para referenciar una base de conocimiento o dominio adicional antes de generar una respuesta. Couchbase puede ayudarle a construir aplicaciones RAG de extremo a extremo utilizando la búsqueda vectorial junto con el popular marco LLM de código abierto Cadena LangChain.

Componentes de los LLM

Los LLM constan de varios componentes clave que funcionan conjuntamente para generar incrustaciones y procesar texto. En conjunto, estos componentes permiten a los LLM captar relaciones lingüísticas profundas y producir incrustaciones significativas:

-

- En capa de tokenización descompone la entrada en subpalabras o caracteres y los convierte en representaciones numéricas.

- En capa de incrustación transforma estos tokens en vectores de alta dimensión.

- En mecanismo de atención, en particular la autoatención, determina cómo las palabras se influyen mutuamente en función del contexto.

- En capas feedforward refinar las incrustaciones y generar predicciones de salida.

- Codificación posicional ayuda a modelos Comprender el orden de las palabras para garantizar un tratamiento coherente del texto.

Incrustaciones unimodales frente a multimodales

Las incrustaciones unimodales representan un único tipo de datos, como texto, imágenes o audio, dentro de un espacio vectorial específico. Las incrustaciones de texto, por ejemplo, se centran únicamente en patrones lingüísticos.

Las incrustaciones multimodales integran múltiples tipos de datos en un espacio compartido, lo que permite a los modelos procesar y relacionar distintas modalidades. Las incrustaciones multimodales son cruciales para aplicaciones como los subtítulos de vídeo, los asistentes de voz y la búsqueda multimodal, en las que distintos tipos de datos deben interactuar a la perfección. Por ejemplo, el modelo CLIP de OpenAI alinea incrustaciones de texto e imagen para permitir la recuperación de imágenes basada en texto.

Tipos de incrustaciones

Las incrustaciones varían en función de su estructura y uso previsto:

-

- Incrustación de palabras representan palabras individuales basándose en patrones de co-ocurrencia.

- Incrustación de frases codificar frases enteras para captar un significado contextual más amplio.

- Incrustación de documentos se extienden a cuerpos de texto más largos.

- Incrustaciones intermodales alinear distintos tipos de datos en un espacio compartido para facilitar las interacciones entre texto, imágenes y audio.

- Incrustaciones específicas de dominio se perfeccionan en conjuntos de datos especializados para mejorar el rendimiento en ámbitos como la medicina o las finanzas.

Cada tipo de incrustación sirve para tareas diferentes, como optimización de la búsqueda o recomendación de contenidos.

Casos prácticos de las incrustaciones LLM

Las incrustaciones LLM potencian una amplia gama de aplicaciones al permitir comparaciones eficaces de textos y datos:

-

- Motores de búsqueda mejorar la relevancia recuperando documentos con semántica en lugar de coincidencias de palabras clave.

- Chatbots y asistentes virtuales utilizar incrustaciones para comprender las consultas y generar respuestas adaptadas al contexto.

- Sistemas de recomendación utilizar incrustaciones para sugerir contenidos en función de las preferencias del usuario.

- Detección de fraudes utiliza incrustaciones para ayudar a identificar patrones en las transacciones financieras.

- Herramientas de finalización de código se basan en incrustaciones para sugerir funciones relevantes.

- Las incrustaciones también mejoran las plataformas de resumen, traducción y aprendizaje personalizado.

Agentes de IAque utilizan la GenAI para imitar y automatizar el razonamiento y los procesos humanos, son el nuevo caso de uso más candente para los LLM. Servicios de IA de Couchbase Capella ayudan a los desarrolladores a crear agentes de IA más rápidamente, abordando muchos de los retos más críticos de GenAI, como la fiabilidad y el coste.

Cómo elegir un enfoque de integración

El mejor enfoque de incrustación para su proyecto depende de las tareas que desee realizar, el tipo de datos con los que trabaje y el nivel de precisión que requiera. Las incrustaciones preentrenadas, como BERT o GPT, son eficaces para la comprensión general del lenguaje, pero si la precisión específica del dominio es crucial, entonces querrá afinar sus incrustaciones en conjuntos de datos especializados para mejorar el rendimiento. Las tareas intermodales requerirán incrustaciones multimodales, mientras que las aplicaciones de recuperación de alta velocidad se beneficiarán de técnicas de búsqueda de vectores densos como Faiss.

La complejidad de su caso de uso determinará si basta con un modelo ligero o si es necesario un enfoque basado en transformadores profundos. También debe tener en cuenta los costes de cálculo y las limitaciones de almacenamiento a la hora de seleccionar una estrategia de incrustación que cumpla sus requisitos.

Cómo integrar los datos en los LLM

La incrustación de datos implica el preprocesamiento del texto, su tokenización y su paso por un modelo de incrustación para obtener vectores numéricos. La tokenización divide el texto en subpalabras o caracteres antes de asignarlos a un espacio de alta dimensión. A continuación, el modelo refina las incrustaciones mediante múltiples capas de transformaciones neuronales.

Una vez generadas, puede almacenar las incrustaciones para recuperarlas de forma eficiente o ajustarlas para tareas específicas. Herramientas como la API de incrustación de OpenAI, Hugging Face Transformers o las capas de incrustación de TensorFlow simplifican el proceso. Los pasos posteriores al procesamiento, como la normalización o la reducción de la dimensionalidad, mejoran la eficiencia para aplicaciones posteriores como la agrupación y la búsqueda.

Para los clientes de Couchbase que almacenan documentos JSON en Capella, hemos eliminado la necesidad de construir un sistema de incrustación personalizado. Servicio de vectorización de Capella acelera el desarrollo de la IA convirtiendo sin problemas los datos en representaciones vectoriales.

Principales conclusiones y próximos pasos

Las incrustaciones LLM son un componente crítico de Aplicaciones basadas en IA como motores de búsqueda, asistentes virtuales, sistemas de recomendación y agentes de IA. Permiten realizar comparaciones de texto y datos muy eficientes que impulsan resultados significativos y excelentes experiencias de usuario.

Couchbase La plataforma unificada de datos para desarrolladores de Capella admite los LLM más populares y es ideal para crear y ejecutar búsquedas, IA agénticay aplicaciones avanzadas que aprovechan las incrustaciones LLM. Capella incluye Capella iQ, un asistente de codificación basado en IA que ayuda a los desarrolladores a escribir consultas SQL, crear datos de prueba y elegir los índices adecuados para reducir los tiempos de consulta. Puede empezar a utilizar nuestro nivel gratuito en minutos sin necesidad de tarjeta de crédito.

PREGUNTAS FRECUENTES

¿Utilizan los LLM las incrustaciones de palabras? Los LLM utilizan incrustaciones de palabras, pero suelen generar incrustaciones contextuales en lugar de incrustaciones de palabras estáticas. A diferencia de métodos tradicionales como Word2Vec, las incrustaciones LLM cambian en función del contexto circundante.

¿Qué son los modelos de incrustación en LLM? Los modelos de incrustación de los LLM convierten el texto en vectores numéricos de alta dimensión que captan el significado semántico. Estos modelos ayudan a los LLM a procesar, comparar y recuperar texto de forma eficiente.

¿Cuál es un ejemplo de modelo de incrustación? Los modelos de incrustación de texto de OpenAI (por ejemplo, text-embedding-3-small y text-embedding-3-large) generan incrustaciones para tareas de búsqueda, agrupación y recuperación. Otros ejemplos son los modelos basados en BERT y SentenceTransformers.

¿Cuál es la diferencia entre tokens e incrustaciones en LLM? Los tokens son unidades discretas de texto (palabras, subpalabras o caracteres) que procesan los LLM, mientras que las incrustaciones son las representaciones vectoriales numéricas de esos tokens. Las incrustaciones codifican las relaciones semánticas que permiten a los modelos comprender el significado.

¿Por qué se tokenizan los LLM? La tokenización divide el texto en unidades más pequeñas para que los LLM puedan procesar y generar incrustaciones de forma eficaz. De este modo, el modelo puede trabajar con distintos idiomas, palabras raras y estructuras oracionales diferentes.