기술 리더와 개발자에게 풍부한 독점 데이터를 제너레이티브 AI 애플리케이션에 통합하는 프로세스는 종종 다음과 같이 복잡합니다. 도전으로 가득 찬 도전. 벡터 유사도 검색 및 검색 증강 생성은 이를 지원하는 강력한 도구이지만, 데이터를 추출, 청크 또는 벡터화하는 과정에서 한 번의 실수로 인해 성능이 우수한 AI 에이전트와 잘못된 응답과 환각으로 사용자를 실망시키는 AI 에이전트의 차이가 생길 수 있습니다. 오늘 Capella에서 고도로 최적화된 벡터 인덱스를 구축하는 것이 훨씬 쉬워졌다는 기쁜 소식을 알려드립니다!

이는 카우치베이스와 벡터라이즈 팀이 DBaaS 플랫폼인 카우치베이스 카펠라에 벡터라이즈 실험의 강력한 기능을 제공하기 위해 열심히 노력해왔기 때문입니다. RAG-GenAI 기반 애플리케이션. 활용 이 통합을 사용하면 최고의 텍스트 임베딩 모델, 청크 전략, 검색 매개변수를 사용하여 코드를 한 줄도 작성하지 않고도 검색 결과의 연관성을 극대화할 수 있습니다.

카펠라를 RAG의 지식 베이스로 사용하여 LLM 기반 애플리케이션을 구축하는 모든 사람에게 이 기능은 데이터에 가장 적합한 벡터화 전략을 찾기 위한 시행착오 없이 단시간에 더 정확하고 우수한 제너레이티브 AI 애플리케이션을 구축할 수 있는 획기적인 기술입니다.

특징 및 기능

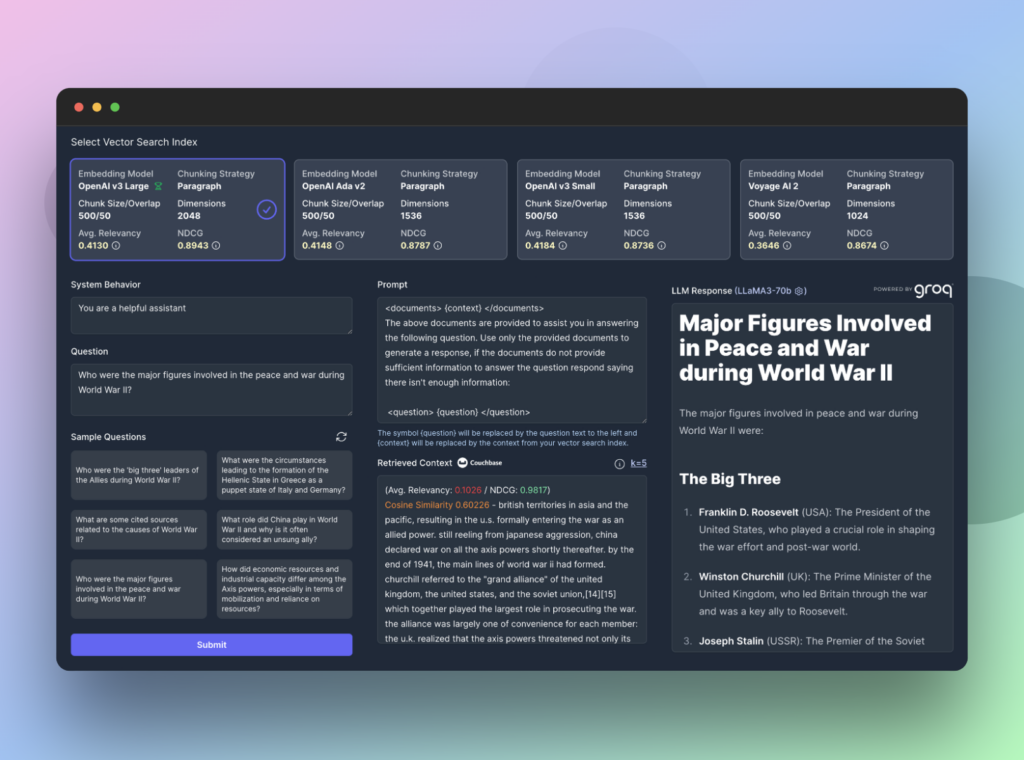

Vectorize에서 실험을 실행하면 Couchbase Capella에서 최대 4개의 서로 다른 벡터 검색 인덱스를 동시에 구축하게 됩니다. 이러한 인덱스는 업로드한 문서 집합에서 채워지며, 각 검색 인덱스는 사용자가 지정한 임베딩 모델과 청킹 전략을 사용하여 채워집니다.

문서를 기반으로 Vectorize는 사용자가 데이터에 대해 질문할 수 있는 질문의 유형을 예측할 수 있는 일련의 합성 질문을 생성합니다. 그런 다음 Vectorize는 관련성 알고리즘과 정규화된 할인 누적 이득을 사용하여 Capella에서 반환된 결과를 점수화하여 각 질문에 가장 관련성이 높은 컨텍스트를 검색합니다.

그 결과, 다양한 벡터화 전략이 데이터에서 얼마나 잘 작동하는지 정확하게 보여주는 구체적인 데이터를 얻을 수 있습니다. 하지만 여정은 여기서 끝나지 않습니다.

Vectorize RAG 샌드박스를 사용하면 검색 증강 생성 흐름을 테스트할 수 있는 엔드투엔드 인터페이스를 제공하는 실시간 대화형 인터페이스에서 데이터를 더욱 자세히 탐색할 수 있습니다. 실험의 합성 질문 중 하나를 사용하거나 직접 프롬프트를 입력하여 Capella에서 반환된 내용을 정확히 확인하고 다양한 대규모 언어 모델이 쿼리에 어떻게 응답하는지 검사할 수 있습니다.

벡터라이즈와 카펠라를 지식 베이스로 사용하면 성능 좋은 RAG 파이프라인 를 통해 Gen AI 애플리케이션과 AI 에이전트가 항상 가장 적절한 컨텍스트를 갖출 수 있도록 합니다. 이는 사용자 만족도가 높아지고 LLM의 환각이 줄어든다는 것을 의미합니다!

가입하고 무료로 체험을 시작하세요!

시작하려면, 벡터라이즈 무료 계정 가입 및 카펠라 30일 평가판 계정 를 클릭해 오늘 첫 실험을 실행하세요!