Introducción a Kubernetes 1.4 con Spring Boot y Couchbase explica cómo empezar a utilizar Kubernetes 1.4 en Amazon Web Services. A

El servicio Couchbase se crea en el clúster y una aplicación Spring Boot almacena un documento JSON en la base de datos. Utiliza kube-up.sh de la descarga binaria de Kubernetes en github.com/kubernetes/kubernetes/releases/download/v1.4.0/kubernetes.tar.gz para iniciar el clúster. Este script es capaz de crear un clúster Kubernetes con un único maestro. Este es un defecto fundamental de las aplicaciones distribuidas en las que el maestro se convierte en un único punto de fallo.

Conozca kops - abreviatura de Kubernetes Operations.

Esta es la forma más sencilla de poner en marcha un clúster Kubernetes de alta disponibilidad. El sitio kubectl es la CLI para ejecutar comandos contra clusters en ejecución. Piensa en kops como kubectl para cluster.

Este blog mostrará cómo crear un clúster Kubernetes de alta disponibilidad en Amazon utilizando kops. Y una vez creado el cluster, creará un servicio Couchbase en él y ejecutará una aplicación Spring Boot para almacenar el documento JSON

en la base de datos.

Muchas gracias a justinsbsarahz, razic, jaygorrell, shrugs, bkpandey y otros en Canal Slack de Kubernetes ¡por ayudarme con los detalles!

Descargar kops y kubectl

- Descargar Última publicación de Kops. Este blog ha sido probado con 1.4.1 en OSX.Conjunto completo de comandos para

kopsse puede ver:

1234567891011121314151617181920212223242526272829303132333435kops-darwin-amd64 --ayudakops es kubernetes ops.En permite usted a crear, destruir, actualizar y mantener racimos.Utilización:kops [comando]Disponible Comandos:crear crear recursosborrar borrar racimosdescriba describa objetoseditar editar artículosexportar exportar racimos/kubecfgconsiga lista o consiga objetosimportar importar racimosrodante-actualización rodante actualización racimossecretos Gestione secretos & llavescaja de herramientas Varios con poca frecuencia usado comandosactualización actualización racimosactualizar actualizar racimosversión Imprimir el cliente versión informaciónBanderas:--alsologtostderr registro a estándar error como bien como archivos--config cadena config archivo (por defecto es $INICIO/.kops.yaml)--log_backtrace_at traceLocation cuando registro hits línea archivo:N, emite a pila rastrear (por defecto :0)--log_dir cadena Si no-vacío, escriba a registro archivos en este directorio--logtostderr registro a estándar error en su lugar de archivos (por defecto falso)--nombre cadena Nombre de grupo--estado cadena Ubicación de estado almacenamiento--stderrthreshold gravedad Registros en o sobre este umbral ir a stderr (por defecto 2)-v, --v Nivel registro nivel para V Registros--vmódulo moduleSpec coma-separado lista de patrón=N ajustes para archivo-filtrado registroUtilice "kops [comando] --help" para más información acerca de a comando. - Descargar

kubectl:

1rizo -Lo kubectl http://storage.googleapis.com/kubernetes-release/release/v1.4.1/bin/darwin/amd64/kubectl && chmod +x kubectl - Incluya

kubectlen suSENDERO.

Crear registros Bucket y NS en Amazon

Por el momento, hay que realizar algunos ajustes, pero esperamos que se solucionen en las próximas versiones. Crear un clúster en AWS proporcionan pasos detallados y más antecedentes.

Esto es lo que siguió el blog:

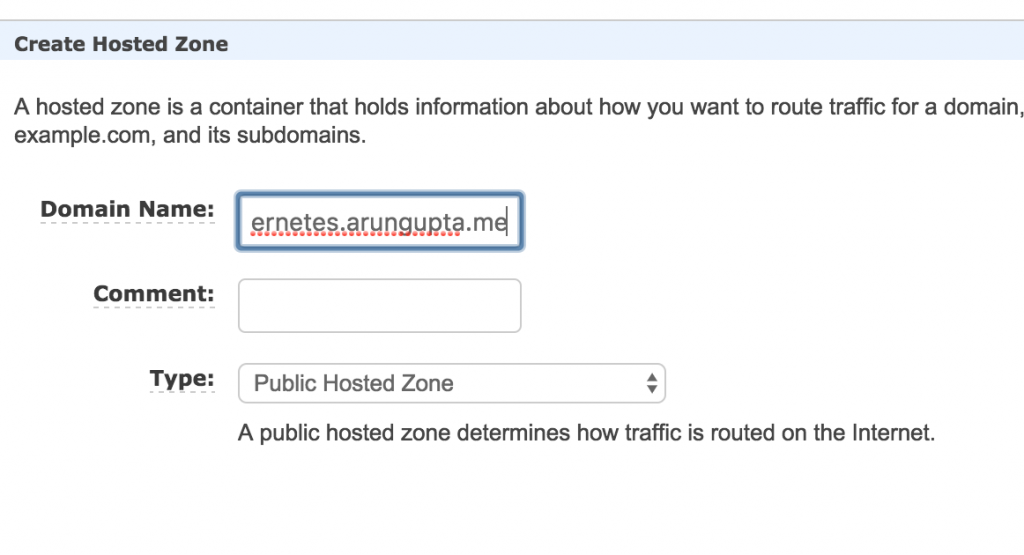

- Elija un dominio donde se alojará el clúster Kubernetes. Este blog utiliza

kubernetes.arungupta.medominio. Puede elegir un dominio de nivel superior o un subdominio. - Ruta 53 de Amazon es un servicio DNS altamente disponible y escalable. Acceda a Consola Amazon y creó un zona alojada para este dominio utilizando el servicio Route 53.

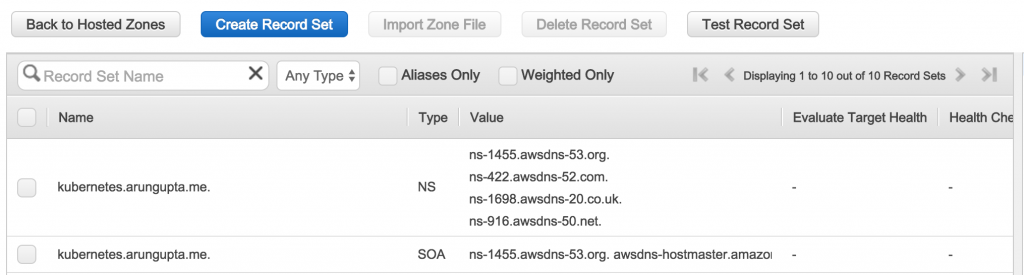

Zona creada parece:

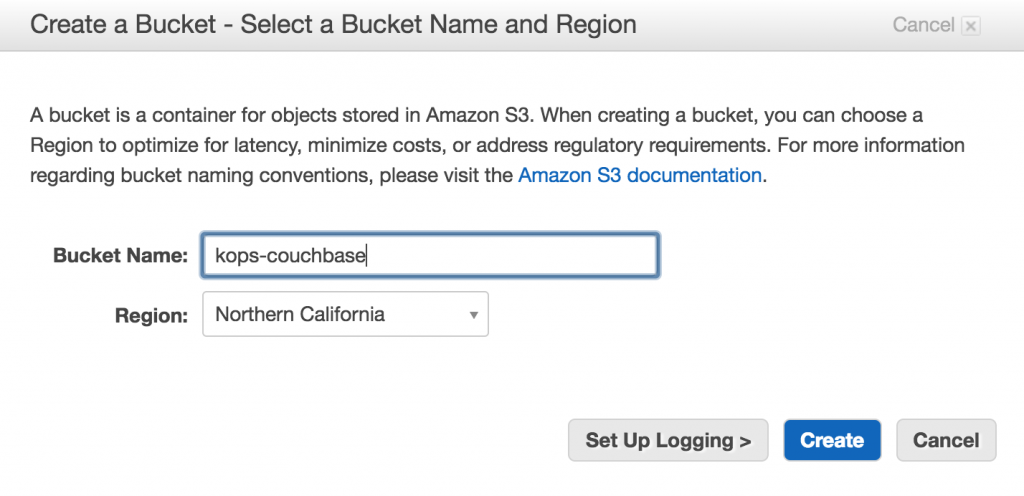

Los valores indicados en elValorson importantes, ya que se utilizarán más adelante para crear registros NS. - Crear un bucket S3 utilizando Consola Amazon para almacenar la configuración del cluster - esto se llama

tienda estatal.

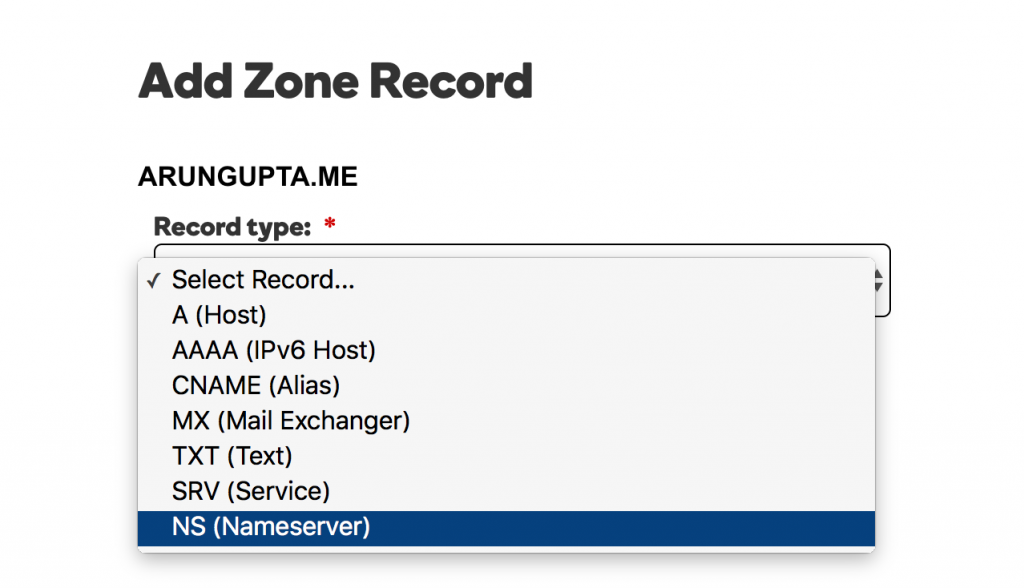

- El dominio

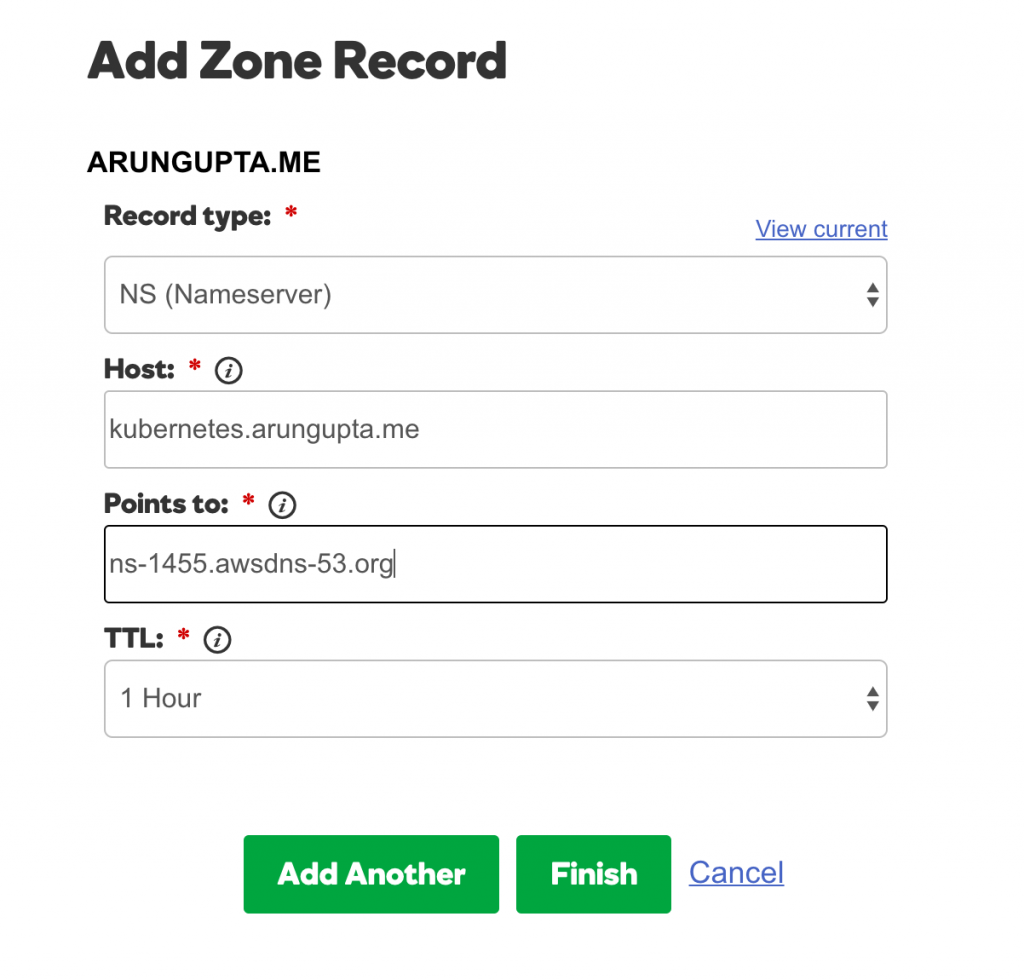

kubernetes.arungupta.meestá alojada en GoDaddy. Para cada valor mostrado en la columna Valor de la zona alojada en Route53, cree un registro NS utilizando Centro de control de dominios de GoDaddy para

Seleccione el tipo de registro:

Para cada valor, añada el registro como se muestra:

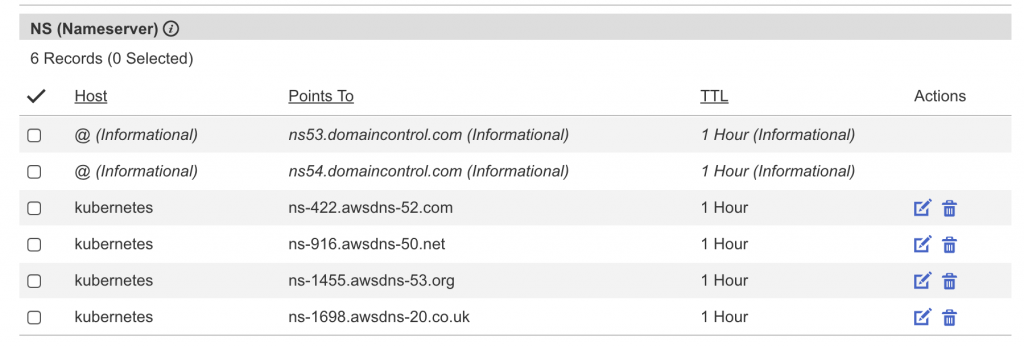

El conjunto completo de registros tiene el siguiente aspecto:

Iniciar clúster multimaster Kubernetes

Entendamos un poco las regiones y zonas de Amazon:

Amazon EC2 se hospeda en varias ubicaciones de todo el mundo. Estas ubicaciones se componen de regiones y zonas de disponibilidad. Cada región es un área geográfica independiente. Cada región tiene varias ubicaciones aisladas conocidas como zonas de disponibilidad.

Se puede crear un clúster Kubernetes de alta disponibilidad entre zonas, pero no entre regiones.

- Averigüe las zonas de disponibilidad dentro de una región:

1234567891011121314151617181920212223aws ec2 describa-disponibilidad-zonas --región us-oeste-2{"Zonas de disponibilidad": [{"Estado": "disponible","NombreRegión": "us-oeste-2","Mensajes": [],"ZoneName": "us-oeste-2a"},{"Estado": "disponible","NombreRegión": "us-oeste-2","Mensajes": [],"ZoneName": "us-oeste-2b"},{"Estado": "disponible","NombreRegión": "us-oeste-2","Mensajes": [],"ZoneName": "us-west-2c"}]} - Crear un clúster multimaestro:

1kops-darwin-amd64 crear grupo --nombre=kubernetes.arungupta.me --nube=aws --zonas=us-oeste-2a,us-oeste-2b,us-oeste-2c --maestro-talla=m4.grande --nodo-cuente=3 --nodo-talla=m4.2xgrande --maestro-zonas=us-oeste-2a,us-oeste-2b,us-oeste-2c --estado=s3://kops-couchbase --yes

La mayoría de los interruptores se explican por sí mismos. Algunos interruptores necesitan un poco de explicación:- Especificación de varias zonas mediante

--master-zones(debe ser un número impar) crear múltiples maestros a través de AZ --cloud=awses opcional si la nube puede deducirse de las zonas--síse utiliza para especificar la creación inmediata del cluster. De lo contrario, solo se almacena el estado en el bucket y el clúster debe crearse por separado.

Se puede ver el conjunto completo de interruptores CLI:

12345678910111213141516171819202122232425262728293031323334353637383940./kops-darwin-amd64 crear grupo --ayudaCrea a k8s grupo.Utilización:kops crear grupo [banderas]Banderas:--admin-acceda a cadena Restringir acceda a a admin puntos finales (SSH, HTTPS) a este CIDR. Si no configure, acceda a se no sea restringido por IP.--asociado-público-ip Especifique --asociado-público-ip=[verdadero|falso] a active/desactivar asociación de público IP para maestro ASG y nodos. Por defecto es verdadero. (por defecto verdadero)--canal cadena Canal para por defecto versiones y configuración a utilice (por defecto "estable")--nube cadena Nube proveedor a utilice - gce, aws--dns-zona cadena DNS alojado zona a utilice (valores predeterminados a último dos componentes de grupo nombre)--imagen cadena Imagen a utilice--kubernetes-versión cadena Versión de kubernetes a ejecute (valores predeterminados a versión en canal)--maestro-talla cadena Establecer instancia talla para masters--maestro-zonas cadena Zonas en que a ejecute masters (debe sea un extraño número)--modelo cadena Modelos a aplicar (separar varios modelos con comas) (por defecto "config,proto,cloudup")--red-cidr cadena Establecer a anular el por defecto red CIDR--red cadena Red modo a utilice. kubenet (por defecto), clásico, externo. (por defecto "kubenet")--nodo-cuente int Establecer el número de nodos--nodo-talla cadena Establecer instancia talla para nodos--fuera cadena Ruta a escriba a cualquier local salida--proyecto cadena Proyecto a utilice (debe sea configure en CME)--ssh-público-clave cadena SSH público clave a utilice (por defecto "~/.ssh/id_rsa.pub")--objetivo cadena Objetivo - directo, terraformar (por defecto "directo")--vpc cadena Establecer a utilice a compartido VPC--sí Especifique --sí a inmediatamente crear el grupo--zonas cadena Zonas en que a ejecute el grupoGlobal Banderas:--alsologtostderr registro a estándar error como bien como archivos--config cadena config archivo (por defecto es $INICIO/.kops.yaml)--log_backtrace_at traceLocation cuando registro hits línea archivo:N, emite a pila rastrear (por defecto :0)--log_dir cadena Si no-vacío, escriba a registro archivos en este directorio--logtostderr registro a estándar error en su lugar de archivos (por defecto falso)--nombre cadena Nombre de grupo--estado cadena Ubicación de estado almacenamiento--stderrthreshold gravedad Registros en o sobre este umbral ir a stderr (por defecto 2)-v, --v Nivel registro nivel para V Registros--vmódulo moduleSpec coma-separado lista de patrón=N ajustes para archivo-filtrado registro - Especificación de varias zonas mediante

- Una vez creado el clúster, obtenga más detalles sobre el clúster:

12345kubectl grupo-informaciónKubernetes maestro es corriendo en https://api.kubernetes.arungupta.meKubeDNS es corriendo en https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dnsA más depurar y diagnosticar grupo problemas, utilice 'kubectl cluster-info dump'.

- Compruebe la versión del cliente y del servidor del clúster:

123kubectl versiónCliente Versión: versión.Información{Mayor:"1", Menor:"4", GitVersion:"v1.4.1", GitCommit:"33cf7b9acbb2cb7c9c72a10d6636321fb180b159", GitTreeState:"limpio", Fecha de construcción:"2016-10-10T18:19:49Z", GoVersion:"go1.7.1", Compilador:"gc", Plataforma:"darwin/amd64"}Servidor Versión: versión.Información{Mayor:"1", Menor:"4", GitVersion:"v1.4.3", GitCommit:"4957b090e9a4f6a68b4a40375408fdc74a212260", GitTreeState:"limpio", Fecha de construcción:"2016-10-16T06:20:04Z", GoVersion:"go1.6.3", Compilador:"gc", Plataforma:"linux/amd64"}

- Compruebe todos los nodos del clúster:

12345678kubectl consiga nodosNOMBRE ESTADO EDADip-172-20-111-151.us-oeste-2.informática.interna Listo 1hip-172-20-116-40.us-oeste-2.informática.interna Listo 1hip-172-20-48-41.us-oeste-2.informática.interna Listo 1hip-172-20-49-105.us-oeste-2.informática.interna Listo 1hip-172-20-80-233.us-oeste-2.informática.interna Listo 1hip-172-20-82-93.us-oeste-2.informática.interna Listo 1h

O averigua sólo los nodos maestros:

12345kubectl consiga nodos -l kubernetes.io/papel=maestroNOMBRE ESTADO EDADip-172-20-111-151.us-oeste-2.informática.interna Listo 1hip-172-20-48-41.us-oeste-2.informática.interna Listo 1hip-172-20-82-93.us-oeste-2.informática.interna Listo 1h - Comprueba todos los grupos:

123kops-darwin-amd64 consiga racimos --estado=s3://kops-couchbaseNOMBRE NUBE ZONASkubernetes.arungupta.me aws us-oeste-2a,us-oeste-2b,us-oeste-2c

Complemento Kubernetes Dashboard

Por defecto, un clúster creado usando kops no tiene el panel de control UI. Pero esto se puede añadir como un complemento:

|

1 2 3 |

kubectl crear -f https://raw.githubusercontent.com/kubernetes/kops/master/addons/kubernetes-dashboard/v1.4.0.yaml despliegue "kubernetes-dashboard-v1.4.0" creado servicio "kubernetes-dashboard" creado |

Ahora se pueden ver todos los detalles sobre el clúster:

|

1 2 3 4 5 6 |

kubectl grupo-información Kubernetes maestro es corriendo en https://api.kubernetes.arungupta.me KubeDNS es corriendo en https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kube-dns kubernetes-salpicadero es corriendo en https://api.kubernetes.arungupta.me/api/v1/proxy/namespaces/kube-system/services/kubernetes-dashboard A más depurar y diagnosticar grupo problemas, utilice 'kubectl cluster-info dump'. |

Y el dashboard de Kubernetes UI está en la URL mostrada. En nuestro caso, es https://api.kubernetes.arungupta.me/ui y parece:

Las credenciales para acceder a este cuadro de mandos pueden obtenerse utilizando la función kubectl config vista comando. Los valores se muestran como:

|

1 2 3 4 |

- nombre: kubernetes.arungupta.me-básico-auth usuario: contraseña: CONTRASEÑA nombre de usuario: admin |

Despliegue del servicio Couchbase

Como se explica en Introducción a Kubernetes 1.4 con Spring Boot y Couchbasevamos a ejecutar un servicio Couchbase:

|

1 2 3 |

kubectl crear -f ~/espacios de trabajo/kubernetes-java-muestra/maven/couchbase-servicio.yml servicio "couchbase-service" creado controlador de réplica "couchbase-rc" creado |

Este archivo de configuración se encuentra en github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/couchbase-service.yml. Obtenga la lista de servicios:

|

1 2 3 4 |

kubectl consiga svc NOMBRE CLÚSTER-IP EXTERNO-IP PUERTO(S) EDAD couchbase-servicio 100.65.4.139 8091/TCP,8092/TCP,8093/TCP,11210/TCP 27s kubernetes 100.64.0.1 443/TCP 2h |

Describa el servicio:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 |

kubectl describa svc/couchbase-servicio Nombre: couchbase-servicio Espacio de nombres: por defecto Etiquetas: Selector: aplicación=couchbase-rc-vaina Tipo: ClusterIP IP: 100.65.4.139 Puerto: admin 8091/TCP Puntos finales: 100.96.5.2:8091 Puerto: vistas 8092/TCP Puntos finales: 100.96.5.2:8092 Puerto: consulta 8093/TCP Puntos finales: 100.96.5.2:8093 Puerto: memcached 11210/TCP Puntos finales: 100.96.5.2:11210 Sesión Afinidad: Ninguno |

Coge las vainas:

|

1 2 3 |

kubectl consiga vainas NOMBRE LISTO ESTADO RESTARTS EDAD couchbase-rc-e35v5 1/1 Ejecutar 0 1m |

Ejecutar aplicación Spring Boot

La aplicación Spring Boot se ejecuta contra el servicio Couchbase y almacena en él un documento JSON. Inicia la aplicación Spring Boot:

|

1 2 |

kubectl crear -f ~/espacios de trabajo/kubernetes-java-muestra/maven/bootiful-couchbase.yml empleo "bootiful-couchbase" creado |

Este archivo de configuración se encuentra en github.com/arun-gupta/kubernetes-java-sample/blob/master/maven/bootiful-couchbase.yml. Ver lista de todas las vainas:

|

1 2 3 4 |

kubectl consiga vainas --Mostrar-todos NOMBRE LISTO ESTADO RESTARTS EDAD bootiful-couchbase-ainv8 0/1 Completado 0 1m couchbase-rc-e35v5 1/1 Ejecutar 0 3m |

Compruebe los registros de la vaina completa:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 |

kubectl Registros bootiful-couchbase-ainv8 . ____ _ __ _ _ /\ / ___'_ __ _ _(_)_ __ __ _ ( ( )___ | '_ | '_| | '_ / _` | \/ ___)| |_)| | | | | || (_| | ) ) ) ) ' |____| .__|_| |_|_| |___, | / / / / =========|_|==============|___/=/_/_/_/ :: Spring Boot :: (v1.4.0.RELEASE) 2016-11-02 18:48:56.035 INFO 7 --- [ main] org.example.webapp.Application : Starting Application v1.0-SNAPSHOT on bootiful-couchbase-ainv8 with PID 7 (/maven/bootiful-couchbase.jar started by root in /) 2016-11-02 18:48:56.040 INFO 7 --- [ main] org.example.webapp.Application : No hay perfiles activos, volviendo a los perfiles por defecto: default 2016-11-02 18:48:56.115 INFO 7 --- [ main] s.c.a.AnnotationConfigApplicationContext : Refrescando org.springframework.context.annotation.AnnotationConfigApplicationContext@108c4c35: fecha de inicio [Wed Nov 02 18:48:56 UTC 2016]; raíz de la jerarquía del contexto. 2016-11-02 18:48:57.021 INFO 7 --- [ main] com.couchbase.client.core.CouchbaseCore : CouchbaseEnvironment: {sslEnabled=false, sslKeystoreFile='null', sslKeystorePassword='null', queryEnabled=falso, queryPort=8093, bootstrapHttpEnabled=verdadero, bootstrapCarrierEnabled=verdadero, bootstrapHttpDirectPort=8091, bootstrapHttpSslPort=18091, bootstrapCarrierDirectPort=11210, bootstrapCarrierSslPort=11207, ioPoolSize=8, computationPoolSize=8, responseBufferSize=16384, requestBufferSize=16384, kvServiceEndpoints=1, viewServiceEndpoints=1, queryServiceEndpoints=1, searchServiceEndpoints=1, ioPool=NioEventLoopGroup, coreScheduler=CoreScheduler, eventBus=DefaultEventBus, packageNameAndVersion=couchbase-java-cliente/2.2.8 (git: 2.2.8, núcleo: 1.2.9), dcpEnabled=falso, retryStrategy=BestEffort, maxRequestLifetime=75000, retryDelay=Retardo exponencial{growBy 1.0 MICROSEGUNDOS, poderes de 2; inferior=100, superior=100000}, reconnectDelay=Retardo exponencial{growBy 1.0 MILLISEGUNDOS, poderes de 2; inferior=32, superior=4096}, observeIntervalDelay=Retardo exponencial{growBy 1.0 MICROSEGUNDOS, poderes de 2; inferior=10, superior=100000}, keepAliveInterval=30000, autoreleaseAfter=2000, bufferPoolingEnabled=verdadero, tcpNodelayEnabled=verdadero, mutationTokensEnabled=falso, socketConnectTimeout=1000, dcpConnectionBufferSize=20971520, dcpConnectionBufferAckThreshold=0.2, dcpConnectionName=dcp/núcleo-io, callbacksOnIoPool=falso, queryTimeout=7500, viewTimeout=7500, kvTimeout=2500, connectTimeout=5000, disconnectTimeout=25000, dnsSrvEnabled=falso} 2016-11-02 18:48:57.245 INFO 7 --- [ cb-io-1-1] com.couchbase.cliente.núcleo.nodo.Nodo : Conectado a Nodo couchbase-servicio 2016-11-02 18:48:57.291 INFO 7 --- [ cb-io-1-1] com.couchbase.cliente.núcleo.nodo.Nodo : Desconectado de Nodo couchbase-servicio 2016-11-02 18:48:57.533 INFO 7 --- [ cb-io-1-2] com.couchbase.cliente.núcleo.nodo.Nodo : Conectado a Nodo couchbase-servicio 2016-11-02 18:48:57.638 INFO 7 --- [-cálculos-4] c.c.c.núcleo.config.ConfigurationProvider : Abierto cubo libros 2016-11-02 18:48:58.152 INFO 7 --- [ principal] o.s.j.e.a.AnnotationMBeanExporter : Registro judías para JMX exposición en inicio Reserve{isbn=978-1-4919-1889-0, nombre=Minecraft Modificación con Forja, coste=29.99} 2016-11-02 18:48:58.402 INFO 7 --- [ principal] org.ejemplo.aplicación web.Aplicación : Comenzó Aplicación en 2.799 segundos (JVM corriendo para 3.141) 2016-11-02 18:48:58.403 INFO 7 --- [ Hilo-5] s.c.a.AnnotationConfigApplicationContext : Cerrar org.springframework.contexto.anotación.AnnotationConfigApplicationContext@108c4c35: inicio fecha [Miércoles Nov 02 18:48:56 UTC 2016]; raíz de contexto jerarquía 2016-11-02 18:48:58.404 INFO 7 --- [ Hilo-5] o.s.j.e.a.AnnotationMBeanExporter : Anulación del registro JMX-expuesto judías en cierre 2016-11-02 18:48:58.410 INFO 7 --- [ cb-io-1-2] com.couchbase.cliente.núcleo.nodo.Nodo : Desconectado de Nodo couchbase-servicio 2016-11-02 18:48:58.410 INFO 7 --- [ Hilo-5] c.c.c.núcleo.config.ConfigurationProvider : Cerrado cubo libros |

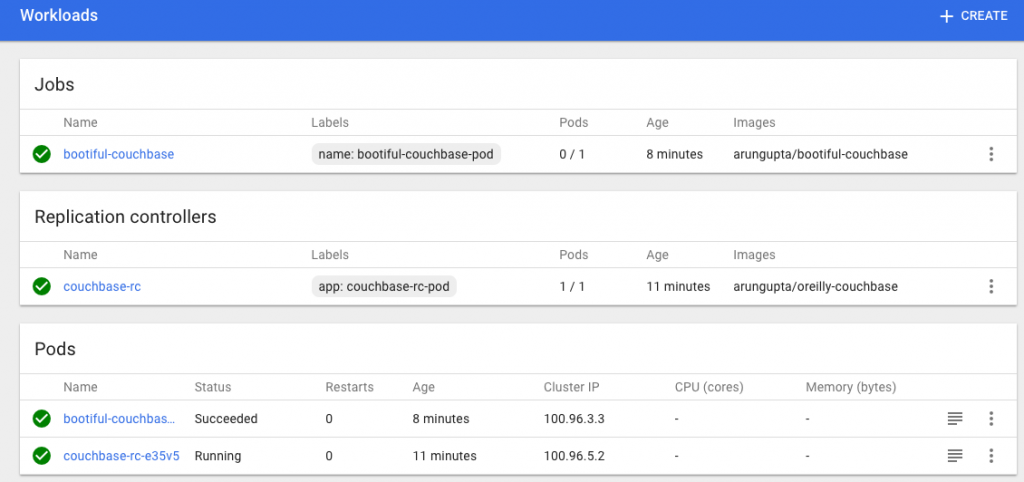

El salpicadero actualizado tiene ahora el siguiente aspecto:

Eliminar el clúster Kubernetes

El clúster Kubernetes se puede eliminar como:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 |

kops-darwin-amd64 borrar grupo --nombre=kubernetes.arungupta.me --estado=s3://kops-couchbase --yes TIPO NOMBRE ID autoescalado-config maestro-us-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 maestro-us-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 autoescalado-config maestro-us-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 maestro-us-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 autoescalado-config maestro-us-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 maestro-us-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 autoescalado-config nodos.kubernetes.arungupta.me-20161101235639 nodos.kubernetes.arungupta.me-20161101235639 autoescalado-grupo maestro-us-oeste-2a.masters.kubernetes.arungupta.me maestro-us-oeste-2a.masters.kubernetes.arungupta.me autoescalado-grupo maestro-us-oeste-2b.masters.kubernetes.arungupta.me maestro-us-oeste-2b.masters.kubernetes.arungupta.me autoescalado-grupo maestro-us-oeste-2c.masters.kubernetes.arungupta.me maestro-us-oeste-2c.masters.kubernetes.arungupta.me autoescalado-grupo nodos.kubernetes.arungupta.me nodos.kubernetes.arungupta.me dhcp-opciones kubernetes.arungupta.me dopt-9b7b08ff Soy-instancia-perfil masters.kubernetes.arungupta.me masters.kubernetes.arungupta.me Soy-instancia-perfil nodos.kubernetes.arungupta.me nodos.kubernetes.arungupta.me Soy-papel masters.kubernetes.arungupta.me masters.kubernetes.arungupta.me Soy-papel nodos.kubernetes.arungupta.me nodos.kubernetes.arungupta.me instancia maestro-us-oeste-2a.masters.kubernetes.arungupta.me i-8798eb9f instancia maestro-us-oeste-2b.masters.kubernetes.arungupta.me i-eca96ab3 instancia maestro-us-oeste-2c.masters.kubernetes.arungupta.me i-63fd3dbf instancia nodos.kubernetes.arungupta.me i-21a96a7e instancia nodos.kubernetes.arungupta.me i-57fb3b8b instancia nodos.kubernetes.arungupta.me i-5c99ea44 internet-pasarela kubernetes.arungupta.me igw-b624abd2 par de claves kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 ruta-tabla kubernetes.arungupta.me rtb-e44df183 ruta53-registro api.interno.kubernetes.arungupta.me. Z6I41VJM5VCZV/api.interno.kubernetes.arungupta.me. ruta53-registro api.kubernetes.arungupta.me. Z6I41VJM5VCZV/api.kubernetes.arungupta.me. ruta53-registro etcd-eventos-us-oeste-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-us-oeste-2a.internal.kubernetes.arungupta.me. ruta53-registro etcd-eventos-us-oeste-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-us-oeste-2b.internal.kubernetes.arungupta.me. ruta53-registro etcd-eventos-us-oeste-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-eventos-us-oeste-2c.internal.kubernetes.arungupta.me. ruta53-registro etcd-us-oeste-2a.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-oeste-2a.internal.kubernetes.arungupta.me. ruta53-registro etcd-us-oeste-2b.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-oeste-2b.internal.kubernetes.arungupta.me. ruta53-registro etcd-us-oeste-2c.internal.kubernetes.arungupta.me. Z6I41VJM5VCZV/etcd-us-oeste-2c.internal.kubernetes.arungupta.me. seguridad-grupo masters.kubernetes.arungupta.me sg-3e790f47 seguridad-grupo nodos.kubernetes.arungupta.me sg-3f790f46 subred us-oeste-2a.kubernetes.arungupta.me subred-3cdbc958 subred us-oeste-2b.kubernetes.arungupta.me subred-18c3f76e subred us-oeste-2c.kubernetes.arungupta.me subred-b30f6deb volumen us-oeste-2a.etcd-eventos.kubernetes.arungupta.me vol-202350a8 volumen us-oeste-2a.etcd-principal.kubernetes.arungupta.me vol-0a235082 volumen us-oeste-2b.etcd-eventos.kubernetes.arungupta.me vol-401f5bf4 volumen us-oeste-2b.etcd-principal.kubernetes.arungupta.me vol-691f5bdd volumen us-oeste-2c.etcd-eventos.kubernetes.arungupta.me vol-aefe163b volumen us-oeste-2c.etcd-principal.kubernetes.arungupta.me vol-e9fd157c vpc kubernetes.arungupta.me vpc-e5f50382 internet-pasarela:igw-b624abd2 todavía tiene dependencias, se reintentar par de claves:kubernetes.kubernetes.arungupta.me-18:90:41:6f:5f:79:6a:a8:d5:b6:b8:3f:10:d5:d3:f3 ok instancia:i-5c99ea44 ok instancia:i-63fd3dbf ok instancia:i-eca96ab3 ok instancia:i-21a96a7e ok autoescalado-grupo:maestro-us-oeste-2a.masters.kubernetes.arungupta.me ok autoescalado-grupo:maestro-us-oeste-2b.masters.kubernetes.arungupta.me ok autoescalado-grupo:maestro-us-oeste-2c.masters.kubernetes.arungupta.me ok autoescalado-grupo:nodos.kubernetes.arungupta.me ok Soy-instancia-perfil:nodos.kubernetes.arungupta.me ok Soy-instancia-perfil:masters.kubernetes.arungupta.me ok instancia:i-57fb3b8b ok instancia:i-8798eb9f ok ruta53-registro:Z6I41VJM5VCZV/etcd-eventos-us-oeste-2a.internal.kubernetes.arungupta.me. ok Soy-papel:nodos.kubernetes.arungupta.me ok Soy-papel:masters.kubernetes.arungupta.me ok autoescalado-config:nodos.kubernetes.arungupta.me-20161101235639 ok autoescalado-config:maestro-us-oeste-2b.masters.kubernetes.arungupta.me-20161101235639 ok subred:subred-b30f6deb todavía tiene dependencias, se reintentar subred:subred-3cdbc958 todavía tiene dependencias, se reintentar subred:subred-18c3f76e todavía tiene dependencias, se reintentar autoescalado-config:maestro-us-oeste-2a.masters.kubernetes.arungupta.me-20161101235639 ok autoescalado-config:maestro-us-oeste-2c.masters.kubernetes.arungupta.me-20161101235639 ok volumen:vol-0a235082 todavía tiene dependencias, se reintentar volumen:vol-202350a8 todavía tiene dependencias, se reintentar volumen:vol-401f5bf4 todavía tiene dependencias, se reintentar volumen:vol-e9fd157c todavía tiene dependencias, se reintentar volumen:vol-aefe163b todavía tiene dependencias, se reintentar volumen:vol-691f5bdd todavía tiene dependencias, se reintentar seguridad-grupo:sg-3f790f46 todavía tiene dependencias, se reintentar seguridad-grupo:sg-3e790f47 todavía tiene dependencias, se reintentar No todos recursos suprimido; a la espera antes de reintentar supresión internet-pasarela:igw-b624abd2 seguridad-grupo:sg-3f790f46 volumen:vol-aefe163b ruta-tabla:rtb-e44df183 volumen:vol-401f5bf4 subred:subred-18c3f76e seguridad-grupo:sg-3e790f47 volumen:vol-691f5bdd subred:subred-3cdbc958 volumen:vol-202350a8 volumen:vol-0a235082 dhcp-opciones:dopt-9b7b08ff subred:subred-b30f6deb volumen:vol-e9fd157c vpc:vpc-e5f50382 internet-pasarela:igw-b624abd2 todavía tiene dependencias, se reintentar volumen:vol-e9fd157c todavía tiene dependencias, se reintentar subred:subred-3cdbc958 todavía tiene dependencias, se reintentar subred:subred-18c3f76e todavía tiene dependencias, se reintentar subred:subred-b30f6deb todavía tiene dependencias, se reintentar volumen:vol-0a235082 todavía tiene dependencias, se reintentar volumen:vol-aefe163b todavía tiene dependencias, se reintentar volumen:vol-691f5bdd todavía tiene dependencias, se reintentar volumen:vol-202350a8 todavía tiene dependencias, se reintentar volumen:vol-401f5bf4 todavía tiene dependencias, se reintentar seguridad-grupo:sg-3f790f46 todavía tiene dependencias, se reintentar seguridad-grupo:sg-3e790f47 todavía tiene dependencias, se reintentar No todos recursos suprimido; a la espera antes de reintentar supresión subred:subred-b30f6deb volumen:vol-e9fd157c vpc:vpc-e5f50382 internet-pasarela:igw-b624abd2 seguridad-grupo:sg-3f790f46 volumen:vol-aefe163b ruta-tabla:rtb-e44df183 volumen:vol-401f5bf4 subred:subred-18c3f76e seguridad-grupo:sg-3e790f47 volumen:vol-691f5bdd subred:subred-3cdbc958 volumen:vol-202350a8 volumen:vol-0a235082 dhcp-opciones:dopt-9b7b08ff subred:subred-18c3f76e todavía tiene dependencias, se reintentar subred:subred-b30f6deb todavía tiene dependencias, se reintentar internet-pasarela:igw-b624abd2 todavía tiene dependencias, se reintentar subred:subred-3cdbc958 todavía tiene dependencias, se reintentar volumen:vol-691f5bdd todavía tiene dependencias, se reintentar volumen:vol-0a235082 todavía tiene dependencias, se reintentar volumen:vol-202350a8 todavía tiene dependencias, se reintentar volumen:vol-401f5bf4 todavía tiene dependencias, se reintentar volumen:vol-aefe163b todavía tiene dependencias, se reintentar volumen:vol-e9fd157c todavía tiene dependencias, se reintentar seguridad-grupo:sg-3e790f47 todavía tiene dependencias, se reintentar seguridad-grupo:sg-3f790f46 todavía tiene dependencias, se reintentar No todos recursos suprimido; a la espera antes de reintentar supresión internet-pasarela:igw-b624abd2 seguridad-grupo:sg-3f790f46 volumen:vol-aefe163b ruta-tabla:rtb-e44df183 volumen:vol-401f5bf4 subred:subred-18c3f76e seguridad-grupo:sg-3e790f47 volumen:vol-691f5bdd subred:subred-3cdbc958 volumen:vol-202350a8 volumen:vol-0a235082 dhcp-opciones:dopt-9b7b08ff subred:subred-b30f6deb volumen:vol-e9fd157c vpc:vpc-e5f50382 subred:subred-b30f6deb todavía tiene dependencias, se reintentar volumen:vol-202350a8 todavía tiene dependencias, se reintentar internet-pasarela:igw-b624abd2 todavía tiene dependencias, se reintentar subred:subred-18c3f76e todavía tiene dependencias, se reintentar volumen:vol-e9fd157c todavía tiene dependencias, se reintentar volumen:vol-aefe163b todavía tiene dependencias, se reintentar volumen:vol-401f5bf4 todavía tiene dependencias, se reintentar volumen:vol-691f5bdd todavía tiene dependencias, se reintentar seguridad-grupo:sg-3e790f47 todavía tiene dependencias, se reintentar seguridad-grupo:sg-3f790f46 todavía tiene dependencias, se reintentar subred:subred-3cdbc958 todavía tiene dependencias, se reintentar volumen:vol-0a235082 todavía tiene dependencias, se reintentar No todos recursos suprimido; a la espera antes de reintentar supresión internet-pasarela:igw-b624abd2 seguridad-grupo:sg-3f790f46 volumen:vol-aefe163b ruta-tabla:rtb-e44df183 subred:subred-18c3f76e seguridad-grupo:sg-3e790f47 volumen:vol-691f5bdd volumen:vol-401f5bf4 volumen:vol-202350a8 subred:subred-3cdbc958 volumen:vol-0a235082 dhcp-opciones:dopt-9b7b08ff subred:subred-b30f6deb volumen:vol-e9fd157c vpc:vpc-e5f50382 subred:subred-18c3f76e ok volumen:vol-e9fd157c ok volumen:vol-401f5bf4 ok volumen:vol-0a235082 ok volumen:vol-691f5bdd ok subred:subred-3cdbc958 ok volumen:vol-aefe163b ok subred:subred-b30f6deb ok internet-pasarela:igw-b624abd2 ok volumen:vol-202350a8 ok seguridad-grupo:sg-3f790f46 ok seguridad-grupo:sg-3e790f47 ok ruta-tabla:rtb-e44df183 ok vpc:vpc-e5f50382 ok dhcp-opciones:dopt-9b7b08ff ok Grupo suprimido |

couchbase.com/contenedores proporcionan más detalles sobre cómo ejecutar Couchbase en diferentes marcos de contenedores. Más información sobre Couchbase: