Para los líderes tecnológicos y los desarrolladores, el proceso de integración de datos ricos y propios en aplicaciones de IA generativa es a menudo lleno de retos. La búsqueda de similitud vectorial y la generación aumentada de recuperación son herramientas poderosas para ayudar con esto, pero un error al extraer, trocear o vectorizar sus datos puede significar la diferencia entre un agente de IA que funcione bien y uno que frustre a los usuarios con respuestas pobres y alucinaciones. Hoy nos complace anunciar que la creación de índices vectoriales altamente optimizados en Capella es ahora mucho más fácil.

Eso es porque los equipos de Couchbase y Vectorize han estado trabajando duro para llevar el poder de los experimentos de Vectorize a Couchbase Capella, una plataforma DBaaS para que empieces rápidamente con tu RAG-aplicación GenAI. Aprovechar esta integración, puede encontrar rápidamente el mejor modelo de incrustación de textoLa tecnología de búsqueda de Google permite a los usuarios acceder a los resultados de búsqueda de forma rápida y sencilla, con estrategias de fragmentación y parámetros de recuperación para maximizar la relevancia de los resultados de búsqueda sin escribir una sola línea de código.

Para cualquiera que esté creando aplicaciones basadas en LLM utilizando Capella como base de conocimiento para RAG, esto supone un cambio radical que le permitirá crear aplicaciones de IA generativa mejores y más precisas en una fracción del tiempo, sin necesidad de ensayo y error para averiguar cuál es la mejor estrategia de vectorización para sus datos.

Características y capacidades

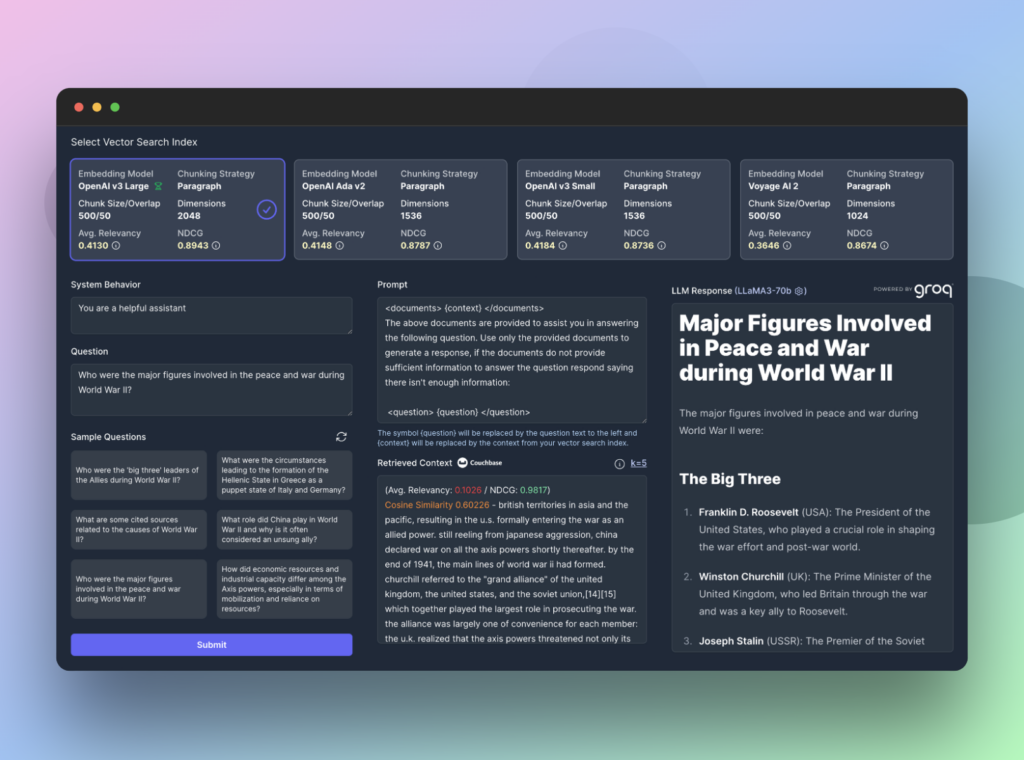

Cuando ejecutas un experimento en Vectorize, construirás hasta 4 índices de búsqueda vectorial diferentes en Couchbase Capella simultáneamente. Estos índices se rellenan a partir de un conjunto de documentos que subes y cada índice de búsqueda se rellena utilizando los modelos de incrustación y las estrategias de fragmentación que especifiques.

Basándose en sus documentos, Vectorize generará un conjunto de preguntas sintéticas que le permitirán predecir los tipos de preguntas que sus usuarios podrían hacer sobre sus datos. A continuación, Vectorize recupera el contexto más relevante para cada pregunta, puntuando los resultados devueltos por Capella mediante un algoritmo de relevancia y una ganancia acumulada descontada normalizada.

El resultado neto son datos concretos que muestran con precisión el rendimiento de las distintas estrategias de vectorización en sus datos. Pero el viaje no acaba aquí.

Con Vectorize RAG Sandbox, puede explorar más a fondo sus datos en una interfaz interactiva en vivo que proporciona una interfaz de extremo a extremo para probar sus flujos de Generación Aumentada de Recuperación. Puede utilizar una de las preguntas sintéticas del experimento o introducir su propia pregunta para ver exactamente qué devuelve Capella e inspeccionar cómo responden a su consulta los distintos modelos de lenguaje de gran tamaño.

Con Vectorize y Capella como base de conocimientos, puede construir una Canalización RAG para garantizar que sus aplicaciones Gen AI y sus agentes AI dispongan siempre del contexto más relevante. Esto significa usuarios más felices y menos alucinaciones de sus LLM.

Regístrate y empieza a experimentar gratis.

Para empezar, regístrate gratis en Vectorize y un Cuenta de prueba de 30 días para Capella para realizar su primer experimento hoy mismo.