¿Por qué exponer la base de datos Couchbase en la red pública?

A continuación figuran algunos ejemplos:

-

Replicación entre centros de datos (XDCR) para alta disponibilidad y recuperación ante desastres

-

Acceso del SDK de cliente al clúster de Couchbase

-

Plataformas de base de datos como servicio (DBaaS)

*Nota - Todos estos casos de uso comparten un objetivo común; permiten a los clientes acceder a la instancia de base de datos sin tener que establecer una VPN a una instancia de Kubernetes. También requieren una comunicación segura protegida por TLS que a veces es difícil de conseguir con la arquitectura típica de Kubernetes.

¿Cómo resolvimos la creación de redes públicas mediante el DNS externo de Kubernetes?

Al desplegar aplicaciones en Kubernetes, normalmente se utilizan recursos de Kubernetes como Service e Ingress para exponer aplicaciones fuera del clúster de Kubernetes en el dominio deseado. Esto implica una gran cantidad de configuración manual de los recursos de Kubernetes y también los registros DNS en su proveedor, que puede ser un proceso largo y erróneo. Esto pronto puede convertirse en un inconveniente a medida que su aplicación crece en complejidad, y también cuando la IP externa cambia, es necesario actualizar los registros DNS en consecuencia.

Para ello, la Equipo Kubernetes sig-network creó el DNS externo para gestionar registros DNS externos de forma autónoma desde un clúster Kubernetes. Una vez desplegado, el DNS externo funciona en segundo plano y apenas requiere configuración adicional. Crea registros DNS en proveedores DNS externos a Kubernetes para que los recursos de Kubernetes sean detectables a través de los proveedores DNS externos, y le permite controlar los registros DNS dinámicamente de forma agnóstica al proveedor DNS. Siempre que descubra que se está creando o actualizando un Servicio o Ingress, el controlador DNS externo actualizará los registros al instante.

Al desplegar la base de datos Couchbase utilizando la estrategia de red pública con DNS Externo para su arquitectura de red, los nodos del clúster Couchbase se exponen utilizando servicios de balanceo de carga que tienen asignadas direcciones IP públicas. El controlador de DNS Externo se encargará entonces de gestionar el DNS dinámico (DDNS) en un proveedor basado en la nube para proporcionar un direccionamiento estable y una base para TLS.

Ahora, ¡vamos a verlo en acción!

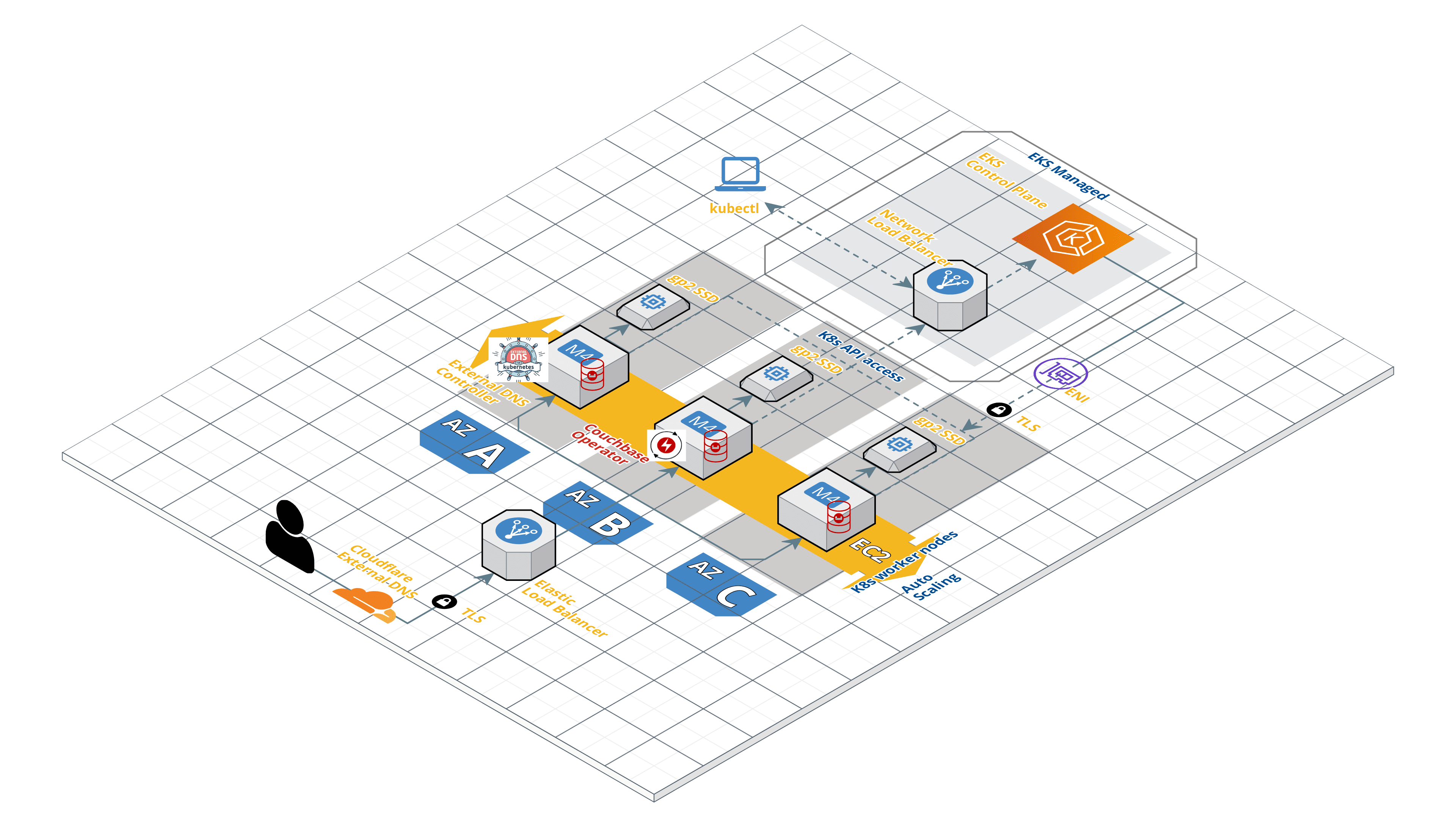

Ahora vamos a seguir los pasos para desplegar el cluster de Couchbase usando Operador Autónomo 2.0 en EKS y acceder al cluster de Couchbase a través de una red pública que se gestiona a través de DNS Externo. A continuación se muestra una visión general de la arquitectura de nuestro despliegue.

Redes Públicas con Couchbase Autonomous Operator usando Kubernetes DNS Externo

Requisitos previos

Antes de empezar, hay algunos requisitos previos importantes.

- Instalación y configuración kubectl kubectl es una interfaz de línea de comandos para ejecutar comandos en clústeres Kubernetes.

- Instale la última CLI DE AWS - La CLI de AWS es una herramienta unificada que le permite interactuar con los servicios de AWS mediante comandos en su shell de línea de comandos. En este caso, utilizaremos la CLI de AWS para comunicarnos de forma segura con el clúster de Kubernetes que se ejecuta en AWS.

- Despliegue el clúster EKS. El sitio Grupo EKS puede desplegarse utilizando la función Consola AWS o eksctl. En este artículo, desplegaremos el clúster EKS en la plataforma us-este-1 región con 3 nodos trabajadores en tres zonas de disponibilidad como se menciona a continuación.

$ eksctl create cluster \ --name cb-op2-edns \ --region us-east-1 \ --zones us-east-1a,us-east-1b,us-east-1c \ --nodegroup-name eks-workers \ --node-type m4.xlarge \ --nodes 3 --nodos-min 3 \ --nodes-max 6 \ --node-ami auto

4. Necesitará un dominio DNS público. El dominio puede adquirirse en un registrador como GoDaddy, Ruta 53 de AWS, Namecheapetc. Para este artículo, estoy usando mi propio dominio registrado (GoDaddy) balajiacloud.guru y le sugiero que consiga el suyo antes de continuar.

5. Por último, necesitará un proveedor de DNS externo. Durante el ciclo de vida de un cluster Couchbase, los nodos pueden ser añadidos y eliminados para escalar el cluster, actualizaciones, o recuperación de fallos. En cada instancia, nuevos nombres DNS necesitan ser creados para cualquier nuevo pod de Couchbase que sea creado, o nombres DNS eliminados de pods que sean borrados. El proveedor DDNS expone una API REST que permite al controlador DNS externo de Kubernetes sincronizar el aspecto del clúster Couchbase con el DNS público.

Aquí está la lista de todos los documentados y conocidos DNS externo para la plataforma Kubernetes. En este artículo, utilizaremos Cloudflare como proveedor de DNS externo. Si tiene previsto utilizar Cloudflare como proveedor de DNS externo, deberá crear una cuenta de Cloudflare y añadir el dominio DNS a la cuenta.

Creación de certificados TLS

El Operador se asegura de que configures tus clusters Couchbase de forma segura. Si el Operador detecta que un clúster está siendo expuesto en la Internet pública, impondrá el cifrado TLS.

Antes de generar los certificados TLS necesitamos determinar en qué dominio DNS estará el cluster de Couchbase. Podemos usar nuestro balajiacloud.guru directamente, pero entonces sólo podrá ser utilizado por un único cluster de Couchbase. Por lo tanto usaremos un subdominio llamado cbdemo.balajiacloud.guru como espacio de nombres único para nuestro clúster. En general, un nombre DNS comodín (*.cbdemo.balajiacloud.guru) manejará todos los nombres DNS públicos generados por el Operador. Esto necesita ser añadido al certificado del cluster Couchbase.

Utilizaremos el EasyRSA para crear los certificados TLS. EasyRSA de OpenVPN hace que el funcionamiento de una infraestructura de clave pública (PKI) sea relativamente sencillo y es el método recomendado para ponerse en marcha rápidamente.

1. Vamos a crear un directorio llamado tls y clone el repositorio EasyRSA.

$ git clone https://github.com/OpenVPN/easy-rsa Clonando en 'easy-rsa'... remoto: Enumerando objetos: 26, hecho. remoto: Contando objetos: 100% (26/26), hecho. remoto: Comprimiendo objetos: 100% (20/20), hecho. remoto: Total 1979 (delta 9), reutilizados 19 (delta 6), pack-reutilizados 1953 Recibiendo objetos: 100% (1979/1979), 5,75 MiB | 1,92 MiB/s, hecho. Resolviendo deltas: 100% (859/859), hecho.

2. Inicialice y cree el certificado/clave de la CA. Se le pedirá una contraseña de clave privada y el nombre común (CN) de la CA, algo así como Couchbase CA es suficiente. El certificado CA estará disponible como pki/ca.crt.

$ cd easy-rsa/easyrsa3

$ ./easyrsa init-pki init-pki completado; ahora puede crear una CA o peticiones. El directorio PKI recién creado es: /Users/balajinarayanan/k8s/couchbase/operator/tls/easy-rsa/easyrsa3/pki

$ ./easyrsa build-ca Uso de SSL: openssl LibreSSL 2.8.3 Introduzca la nueva contraseña de la clave de CA: Vuelva a introducir la nueva frase de contraseña de la clave de CA: Generar clave privada RSA, módulo largo de 2048 bits ..........................................+++ ................................................................+++ e es 65537 (0x10001) Se le va a pedir que introduzca información que se incorporará en su solicitud de certificado. Lo que está a punto de introducir es lo que se denomina Nombre Distinguido o DN. Hay bastantes campos pero puede dejar algunos en blanco Para algunos campos habrá un valor por defecto, Si introduce '.', el campo quedará en blanco. ----- Nombre común (por ejemplo: su nombre de usuario, host o servidor) [Easy-RSA CA]:Couchbase CA La creación de la CA se ha completado y ahora puede importar y firmar solicitudes de certificados. Su nuevo archivo de certificado CA para publicar está en: /Users/balajinarayanan/k8s/couchbase/operator/tls/easy-rsa/easyrsa3/pki/ca.crt

3. Cree el certificado del servidor de clúster Couchbase.

Necesitas crear un certificado comodín de servidor y una clave para ser usada en los pods de Couchbase Server. En este artículo, vamos a utilizar el siguiente comando para generar un certificado para el clúster Couchbase cbopedns en el demo y utilizando el espacio de nombres cbdemo.balajiacloud.guru subdominio.

$ ./easyrsa --subject-alt-name="DNS:*.cbopedns,DNS:*.cbopedns.demo,DNS:*.cbopedns.demo.svc,DNS:*.demo.svc,DNS:cbopedns-srv,DNS:cbopedns-srv.demo,DNS:cbopedns-srv.demo.svc,DNS:localhost,DNS:*.cbopedns.cbdemo.balajiacloud.guru,DNS:*.cbdemo.balajiacloud.guru" build-server-full couchbase-server nopass Usando SSL: openssl LibreSSL 2.8.3 Generando una clave privada RSA de 2048 bits ..............................+++ .......................................................+++ escribiendo la nueva clave privada en '/Users/balajinarayanan/k8s/couchbase/operator/tls/easy-rsa/easyrsa3/pki/easy-rsa-10086.2Q0Q2S/tmp.emWXHL' ----- Usando configuración de /Users/balajinarayanan/k8s/couchbase/operator/tls/easy-rsa/easyrsa3/pki/easy-rsa-10086.2Q0Q2S/tmp.Phz9Az Introduzca la frase de paso para /Users/balajinarayanan/k8s/couchbase/operator/tls/easy-rsa/easyrsa3/pki/private/ca.key: Compruebe que la solicitud coincide con la firma Firma ok El Nombre Distinguido del Sujeto es el siguiente commonName :ASN.1 12:'couchbase-servidor' El certificado estará certificado hasta el 5 de agosto 17:44:19 2022 GMT (825 días) Escribir base de datos con 1 nuevas entradas Base de datos actualizada

Nota: Las claves protegidas por contraseña no son soportadas por Couchbase Server o el Operador.

El par clave/certificado se encuentra en pki/private/couchbase-server.key y pki/issued/couchbase-server.crt y se utiliza como pkey.key y cadena.pemrespectivamente, en el spec.networking.tls.static.serverSecret parámetro de agrupación.

4. Formateo de claves privadas - Debido a una limitación con el manejo de claves privadas de Couchbase Server, las claves del servidor deben tener formato PKCS#1.

En primer lugar, copiemos los archivos .key y .pem en la carpeta tls para facilitar el acceso.

$ cp easy-rsa/easyrsa3/pki/private/couchbase-server.key pkey.key $ cp easy-rsa/easyrsa3/pki/issued/couchbase-server.crt chain.pem $ cp easy-rsa/easyrsa3/pki/ca.crt ca.crt

Ahora, vamos a formatear las claves del servidor.

$ openssl rsa -in pkey.key -out pkey.key.der -outform DER escribir clave RSA

$ openssl rsa -in pkey.key.der -inform DER -out pkey.key -outform PEM escribir clave RSA

Utilizaremos estas claves para crear el secreto del servidor del cluster Couchbase.

Despliegue Couchbase Autonomous Operator 2.0 (Última versión)

Couchbase Autonomous Operator for Kubernetes permite la portabilidad a la nube y automatiza las mejores prácticas operativas para desplegar y gestionar Couchbase.

El operador está formado por dos componentes: un controlador dinámico de admisión (DAC) por clúster y un operador por espacio de nombres. Consulte el arquitectura del operador para obtener información adicional sobre los requisitos y las consideraciones de seguridad.

1. Descargar el paquete Operator

Puede descargar la última Operador autónomo de Couchbase y descomprímalo en el equipo local. El paquete Operator contiene archivos de configuración YAML y herramientas de línea de comandos que utilizará para instalar Operator.

2. Instale la definición personalizada de recursos (CRD)

El primer paso para instalar Operator es instalar las definiciones de recursos personalizadas (CRD) que describen los tipos de recursos de Couchbase. Esto se puede lograr ejecutando el siguiente comando desde el directorio del paquete Operator:

$ kubectl create -f crd.yaml customresourcedefinition.apiextensions.k8s.io/couchbasebuckets.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbaseephemeralbuckets.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbasemcachedbuckets.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbasereplications.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbaseusers.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbasegroups.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbaserolebindings.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbaseclusters.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbasebackups.couchbase.com creado customresourcedefinition.apiextensions.k8s.io/couchbasebackuprestores.couchbase.com creado

3. Instalar el Controlador Dinámico de Admisión (DAC)

El DAC permite modificar e interrogar los recursos personalizados antes de aceptarlos y comprometerlos a etcd. Ejecutar el DAC nos permite añadir valores por defecto sensibles a las configuraciones del cluster Couchbase minimizando así el tamaño de las especificaciones. También nos permite mantener la compatibilidad con versiones anteriores cuando se añaden nuevos atributos y deben ser rellenados. Esto hace que la experiencia de uso de los recursos de Couchbase sea similar a la de los tipos de recursos nativos.

Ahora, vamos a instalar el Controlador Dinámico de Admisión.

Abra una ventana de Terminal y vaya al directorio donde desempaquetó el paquete Operator y cd a la carpeta bin. Ejecute el siguiente comando para instalar el DAC en la carpeta por defecto espacio de nombres.

$ ./cbopcfg --no-operator --namespace default | kubectl create -n default -f - - serviceaccount/couchbase-operator-admission creado clusterrole.rbac.authorization.k8s.io/couchbase-operator-admission creado clusterrolebinding.rbac.authorization.k8s.io/couchbase-operator-admission creado secret/couchbase-operator-admission creado deployment.apps/couchbase-operator-admission creado service/couchbase-operator-admission creado mutatingwebhookconfiguration.admissionregistration.k8s.io/couchbase-operator-admission creado validatingwebhookconfiguration.admissionregistration.k8s.io/couchbase-operator-admission creado

Confirme que el controlador de admisión se ha desplegado correctamente.

$ kubectl get deployments NAME READY UP-TO-DATE AVAILABLE AGE couchbase-operator-admission 1/1 1 1 70s

4. Crear un espacio de nombres

Los espacios de nombres son una forma de asignar recursos de clúster, además de establecer políticas de red y seguridad entre varias aplicaciones. Crearemos un espacio de nombres único llamado demo para desplegar el Operator y más tarde utilizaremos el espacio de nombres demo para desplegar el cluster Couchbase.

Ejecute el siguiente comando para crear el espacio de nombres.

$ kubectl create namespace demo namespace/demo creado

Confirme que el espacio de nombres se ha creado correctamente.

$ kubectl get namespaces NOMBRE ESTADO EDAD por defecto Activo 37m demo Activo 39s kube-node-lease Activo 37m kube-public Activo 37m kube-system Activo 37m

5. Configurar TLS

Los secretos se especifican en el recurso CouchbaseCluster, y lo notarás en el YAML de definición del cluster mientras desplegamos el cluster Couchbase.

Secreto de servidor

Los secretos de servidor deben montarse como un volumen dentro del pod de Couchbase Server con nombres específicos. La cadena de certificados debe llamarse cadena.pem y la clave privada como pkey.key. Ejecute el siguiente comando para crear el secreto del servidor Couchbase.

$ kubectl create secret generic couchbase-server-tls -n demo --from-file tls/chain.pem --from-file tls/pkey.key secret/couchbase-server-tls creado

Secreto del operador

Los secretos de cliente de Operator se leen directamente de la API. Sólo se espera un único valor; ca.crt es la CA de nivel superior que se utiliza para autenticar todas las cadenas de certificados de servidor TLS. Ejecute el siguiente comando para crear el Operator secret.

$ kubectl create secret generic couchbase-operator-tls -n demo --from-file tls/ca.crt secret/couchbase-operator-tls creado

6. Instalar el operador Couchbase

Ahora vamos a desplegar el Operador en el directorio demo ejecutando el siguiente comando desde la carpeta bin del directorio del paquete Operator.

$ ./cbopcfg --no-admission --namespace demo | kubectl create -n demo -f - - serviceaccount/couchbase-operator creado role.rbac.authorization.k8s.io/couchbase-operator creado rolebinding.rbac.authorization.k8s.io/couchbase-operator creado deployment.apps/couchbase-operator creado service/couchbase-operator creado

Al ejecutar el comando anterior se descarga la imagen Docker Operator y se crea un archivo despliegueque gestiona una única instancia de Operator. El pod Operator se ejecuta como despliegue para que Kubernetes pueda reiniciarse en caso de fallo.

Después de ejecutar el kubectl create por lo general, Kubernetes tarda menos de un minuto en desplegar el operador y dejarlo listo para ejecutarse.

Comprobar el estado de la implantación del operador

Puede utilizar el siguiente comando para comprobar el estado de la implantación:

$ kubectl get deployments -n demo NOMBRE LISTO ACTUALIZADO DISPONIBLE EDAD couchbase-operator 1/1 1 1 97s

Si ejecuta este comando inmediatamente después de desplegar el Operador, la salida tendrá el valor DISPONIBLE como 0. Sin embargo, el campo AVAILABLE indica que el pod aún no está listo, ya que su valor es 0 y no 1.

Ejecute el siguiente comando para verificar que el pod Operator se ha iniciado correctamente. Si Operator está en funcionamiento, el comando devuelve una salida en la que se muestra el icono LISTO exposiciones sobre el terreno 1/1como:

$ kubectl get pods -l app=couchbase-operator -n demo NAME READY STATUS RESTARTS AGE couchbase-operator-7f799565f8-c29ts 1/1 En ejecución 0 2m47s

También puede comprobar los registros para confirmar que el Operador está en funcionamiento, ejecutando el siguiente comando.

$ kubectl logs -f couchbase-operator-7f799565f8-c29ts -n demo

{"level":"info","ts":1588493860.1096337,"logger":"main","msg":"couchbase-operator","version":"2.0.0 (build 317)","revision":"release"}

{"level": "info", "ts":1588493860.1100397, "logger": "leader", "msg": "Intentando ser el líder."}

{"level": "info", "ts":1588493860.1653795, "logger": "leader", "msg": "No pre-existing lock was found."}

{"level":"info","ts":1588493860.1700613,"logger":"leader","msg":"Became the leader."}

{"level": "info", "ts":1588493860.2087, "logger": "kubebuilder.controller", "msg": "Starting EventSource", "controller": "couchbase-controller", "source": "tipo fuente: /, Kind="}

{"level": "info", "ts":1588493860.3104734, "logger": "kubebuilder.controller", "msg": "Starting Controller", "controller": "couchbase-controller"}

{"level": "info", "ts":1588493860.4107096, "logger": "kubebuilder.controller", "msg": "Starting workers", "controller": "couchbase-controller", "worker count":4}

Despliegue del DNS externo

Suponiendo que ya ha completado los pasos anteriores para desplegar el Operador en un espacio de nombres; la función demo lo siguiente que hay que instalar es el controlador DNS externo. Esto debe instalarse antes que el cluster Couchbase ya que el Operador esperará a la propagación DNS antes de crear en pods Couchbase Server. Esto se debe a que los clientes deben ser capaces de llegar a los pods de Couchbase Server con el fin de servir el tráfico y evitar errores de aplicación.

1. Cree una cuenta de servicio para el controlador DNS externo en el espacio de nombres donde va a instalar el Operator.

$ kubectl --namespace demo create serviceaccount external-dns serviceaccount/external-dns creado

2. El controlador DNS externo requiere un rol para poder sondear recursos y buscar registros DNS para replicar en el proveedor DDNS.

$ kubectl --namespace demo create -f - <<EOF apiVersion: rbac.authorization.k8s.io/v1beta1 tipo: ClusterRole metadatos: name: external-dns reglas: - apiGroups: [""] resources: ["services", "endpoints", "pods"] verbs: ["get","watch","list"] - apiGroups: ["extensions"] recursos: ["entradas"] verbos: ["get","watch","list"] - apiGroups: [""] recursos: ["nodos"] verbos: ["get","watch","list"] EOF clusterrole.rbac.authorization.k8s.io/external-dns creado

3. Ahora, vincule el rol DNS externo a la cuenta de servicio.

$ kubectl --namespace demo create -f - <<EOF apiVersion: rbac.authorization.k8s.io/v1beta1 kind: ClusterRoleBinding metadatos: name: external-dns roleRef: apiGroup: rbac.authorization.k8s.io tipo: ClusterRole nombre: external-dns subjects - tipo: ServiceAccount nombre: external-dns espacio de nombres: demo EOF clusterrolebinding.rbac.authorization.k8s.io/external-dns creado

4. El último paso es desplegar el DNS externo. No olvide actualizar los siguientes valores específicos para su despliegue.

-

- En spec.template.spec.serviceAccountName garantiza que los pods DNS externos se ejecutan como la cuenta de servicio que hemos configurado. Esto concede al controlador permiso para sondear recursos y buscar solicitudes DDNS.

- En -filtro de dominio indica a DNS Externo que sólo tenga en cuenta las entradas DDNS que estén asociadas a entradas DNS relacionadas con nuestro balajiacloud.guru dominio.

- En -txt-id-propietario indica a DNS Externo que etiquete los registros de gestión TXT con una cadena exclusiva de la instancia de DNS Externo. DNS externo utiliza registros TXT para registrar metadatos , especialmente información de propiedad asociada con los registros DNS que está administrando. Si el argumento balajiacloud.guru es utilizado por múltiples instancias de DNS Externo sin especificar ninguna propiedad, entonces entrarían en conflicto entre sí.

- En CF_API_KEY es utilizada por el proveedor de Cloudflare para autenticarse en la API de Cloudflare.

- En CF_API_EMAIL es utilizada por el proveedor de Cloudflare para identificar qué cuenta utilizar contra la API de Cloudflare.

Puedes obtener el CF_API_KEY desde la página de resumen de la cuenta de Cloudfare. Haz clic en el enlace "Obtén tu token de API" como se muestra a continuación y visualiza el Clave API global.

Despliegue del DNS externo

Por último, instale el despliegue de DNS externo ejecutando el siguiente comando.

$ kubectl --namespace demo create -f - <<EOF

apiVersion: apps/v1

tipo: Deployment

metadata:

name: external-dns

spec:

selector:

matchLabels:

app: external-dns

plantilla:

metadata:

labels:

app: external-dns

spec:

serviceAccountName: external-dns

contenedores:

- nombre: external-dns

imagen: registry.opensource.zalan.do/teapot/external-dns:latest

argumentos:

--source=service

--domain-filter=balajiacloud.guru

--provider=cloudflare

--txt-owner-id=cbop-edns-demo

env:

- nombre: CF_API_KEY

value: YOUR_CF_API_KEY

- nombre: CF_API_EMAIL

valor: YOUR_CF_API_EMAIL

EOF

deployment.apps/external-dns creado

Comprobar el estado de la implantación del DNS externo

Puede utilizar el siguiente comando para comprobar el estado de la implantación:

$ kubectl get deployments -n demo NOMBRE LISTO ACTUALIZADO DISPONIBLE EDAD couchbase-operator 1/1 1 1 10m external-dns 1/1 1 1 21s

Ejecute el siguiente comando para verificar que el external-dns se ha iniciado correctamente. Si el external-dns está en funcionamiento, el comando devuelve una salida en la que se muestra el icono RUNNING exposiciones sobre el terreno 1/1como:

$ kubectl get pods -n demo NAME READY STATUS RESTARTS AGE couchbase-operator-7f799565f8-c29ts 1/1 En ejecución 0 11m external-dns-6f74575d54-fp2wh 1/1 En ejecución 0 59s

También puede comprobar los registros para confirmar que external-dns está en funcionamiento.

$ kubectl logs -f external-dns-6f74575d54-fp2wh -n demo

time="2020-05-03T08:27:44Z" level=info msg="config: {Master: KubeConfig: RequestTimeout:30s IstioIngressGatewayServices:[] ContourLoadBalancerService:heptio-contour/contour SkipperRouteGroupVersion:zalando.org/v1 Sources:[service] Namespace: AnnotationFilter: FQDNTemplate: CombineFQDNAndAnnotation:false IgnoreHostnameAnnotation:false Compatibilidad: PublishInternal:false PublishHostIP:false AlwaysPublishNotReadyAddresses:false ConnectorSourceServer:localhost:8080 Provider:cloudflare GoogleProject: GoogleBatchChangeSize:1000 GoogleBatchChangeInterval:1s DomainFilter:[balajiacloud.guru] ExcludeDomains:[] ZoneIDFilter:[] AlibabaCloudConfigFile:/etc/kubernetes/alibaba-cloud.json AlibabaCloudZoneType: AWSZoneType: AWSZoneTagFilter:[] AWSAssumeRole: AWSBatchChangeSize:1000 AWSBatchChangeInterval:1s AWSEvaluateTargetHealth:true AWSAPIRetries:3 AWSPreferCNAME:false AzureConfigFile:/etc/kubernetes/azure.json AzureResourceGroup: AzureSubscriptionID: AzureUserAssignedIdentityClientID: CloudflareProxied:false CloudflareZonesPerPage:50 CoreDNSPrefix:/skydns/ RcodezeroTXTEncrypt:false AkamaiServiceConsumerDomain: AkamaiClientToken: AkamaiClientSecret: AkamaiAccessToken: InfobloxGridHost: InfobloxWapiPort:443 InfobloxWapiUsername:admin InfobloxWapiPassword: InfobloxWapiVersion:2.3.1 InfobloxSSLVerify:true InfobloxView: InfobloxMaxResults:0 DynCustomerName: DynUsername: DynPassword: DynMinTTLSeconds:0 OCIConfigFile:/etc/kubernetes/oci.yaml InMemoryZones:[] OVHEndpoint:ovh-eu PDNSServer:https://localhost:8081 PDNSAPIKey: PDNSTLSEnabled:false TLSCA: TLSClientCert: TLSClientCertKey: Policy:sync Registry:txt TXTOwnerID:cbop-edns-demo TXTPrefix: Interval:1m0s Once:false DryRun:false UpdateEvents:false LogFormat:text MetricsAddress::7979 LogLevel:info TXTCacheInterval:0s ExoscaleEndpoint:https://api.exoscale.ch/dns ExoscaleAPIKey: ExoscaleAPISecret: CRDSourceAPIVersion:externaldns.k8s.io/v1alpha1 CRDSourceKind:DNSEndpoint ServiceTypeFilter:[] CFAPIEndpoint: CFUsername: CFPassword: RFC2136Host: RFC2136Port:0 RFC2136Zone: RFC2136Insecure:false RFC2136TSIGKeyName: RFC2136TSIGSecret: RFC2136TSIGSecretAlg: RFC2136TAXFR:false RFC2136MinTTL:0s NS1Endpoint: NS1IgnoreSSL:false TransIPAccountName: TransIPPrivateKeyFile:}"

time="2020-05-03T08:27:44Z" level=info msg="Instalando nuevo cliente Kubernetes"

time="2020-05-03T08:27:44Z" level=info msg="Usando inCluster-config basado en serviceaccount-token"

time="2020-05-03T08:27:44Z" level=info msg="Creado cliente Kubernetes https://10.100.0.1:443"

Ahora hemos desplegado con éxito el DNS externo.

Despliegue del clúster Couchbase

Ahora que hemos desplegado el Operador Autónomo Couchbase y el DNS Externo en EKS, vamos a desplegar el Cluster Couchbase.

Desplegaremos el cluster Couchbase con 3 nodos de datos en 3 zonas de disponibilidad con los parámetros de configuración mínimos requeridos. Consulte la Configurar la red pública para las opciones de configuración necesarias.

Crear el secreto para la consola de administración de Couchbase

Vamos a crear una credencial secreta que será utilizada por la consola web administrativa durante el inicio de sesión. Al crear el siguiente secreto en su clúster Kubernetes, el secreto establece el nombre de usuario en Administrador y la contraseña a contraseña.

$ kubectl --namespace demo create -f - <<EOF apiVersion: v1 tipo: Secret metadatos: name: cb-example-auth type: Opaco datos: nombre de usuario: QWRtaW5pc3RyYXRvcg== # Administrador contraseña: cGFzc3dvcmQ= # contraseña EOF secret/cbopedns-auth creado

Despliegue de la definición del clúster Couchbase

Utilizaremos la opción por defecto StorageClass que obtenemos con EKS, comprobémoslo ejecutando el siguiente comando. Puedes crear una clase de almacenamiento que se ajuste a tus necesidades.

$ kubectl get sc NAME PROVISIONER AGE gp2 (por defecto) kubernetes.io/aws-ebs 67m

Para desplegar un clúster de Couchbase Server utilizando el Operador, todo lo que tienes que hacer es crear una definición de clúster de Couchbase que describa cómo quieres que sea el clúster (por ejemplo, el número de nodos, tipos de servicios, recursos del sistema, etc), y luego empujar esa definición de clúster en Kubernetes.

El paquete Operator contiene un archivo de definición de CouchbaseCluster de ejemplo (couchbase-cluster.yaml).

La siguiente definición de cluster desplegará el cluster Couchbase con 3 pods de datos a través de 3 zonas diferentes utilizando volúmenes persistentes. Por favor, compruebe la Recurso de clúster de Couchbase para obtener la lista completa de la configuración del clúster.

$ kubectl --namespace demo create -f - <<EOF

apiVersion: couchbase.com/v2

tipo: CouchbaseBucket

metadatos:

name: default

---

apiVersion: couchbase.com/v2

tipo: CouchbaseCluster

metadatos:

name: cbopedns

spec:

imagen: couchbase/server:6.5.0

red:

tls:

static:

serverSecret: couchbase-server-tls

operatorSecret: couchbase-operator-tls

exposeAdminConsole: true

adminConsoleServiceType: LoadBalancer

características expuestas:

- xdcr

- cliente

exposedFeatureServiceType: LoadBalancer

dns

domain: cbdemo.balajiacloud.guru

disableBucketManagement: false

cluster

clusterName: cbopedns

dataServiceMemoryQuota: 2048Mi

seguridad:

adminSecret: cbopedns-auth

servidores:

- nombre: data-east-1a

tamaño: 1

servicios:

- data

grupos de servidores:

- us-east-1a

vaina:

volumeMounts:

default: pvc-default # /opt/couchbase/var/lib/couchbase

datos: pvc-datos # /mnt/datos

- nombre: data-east-1b

tamaño: 1

servicios:

- data

serverGroups:

- us-east-1b

pod:

volumeMounts:

default: pvc-default

datos: pvc-datos

- nombre: data-east-1c

tamaño: 1

servicios:

- data

serverGroups:

- us-east-1c

pod:

volumeMounts:

default: pvc-default

datos: pvc-datos

volumeClaimTemplates:

- metadatos:

nombre: pvc-default

spec:

storageClassName: gp2

recursos:

requests:

almacenamiento: 1Gi

- metadatos:

nombre: pvc-data

spec:

storageClassName: gp2

recursos:

requests:

almacenamiento: 5Gi

EOF

couchbasebucket.couchbase.com/default creado

couchbasecluster.couchbase.com/cbopedns creado

Tras recibir la configuración, el Operador inicia automáticamente la creación del clúster. El tiempo que se tarda en crear el clúster depende de la configuración. Puede seguir el progreso de la creación del clúster utilizando la función estado del clúster.

Verificación de la implantación

Para comprobar el progreso ejecute el siguiente comando, que observará (argumento -w) el progreso de la creación de pods. Si todo va bien entonces tendremos tres pods del cluster Couchbase alojando los servicios según la definición del cluster Couchbase.

kubectl get pods --namespace demo -w cbopedns-0000 1/1 En ejecución 0 9m15s cbopedns-0001 1/1 En ejecución 0 8m34s cbopedns-0002 1/1 En ejecución 0 8m couchbase-operator-7f799565f8-c29ts 1/1 En ejecución 1 36m external-dns-6f74575d54-fp2wh 1/1 En ejecución 0 26m

Si por alguna razón se produce una excepción, puede encontrar los detalles de la excepción en el archivo de registro couchbase-operator. Para visualizar las últimas 20 líneas del registro, copie el nombre de su pod Operator y ejecute el siguiente comando sustituyendo el nombre del pod Operator por el nombre de su entorno.

$ kubectl logs couchbase-operator-7f799565f8-c29ts -n demo --tail 20

{"level":"info","ts":1588495709.7896624,"logger":"cluster","msg":"Watching new cluster","cluster":"demo/cbopedns"}

{"level":"info","ts":1588495709.7898946,"logger":"cluster","msg":"Janitor starting","cluster":"demo/cbopedns"}

{"level":"info","ts":1588495709.7987065,"logger":"cluster","msg":"Couchbase client starting","cluster":"demo/cbopedns"}

{"level": "info", "ts":1588495709.818881, "logger": "cluster", "msg": "El cluster ya existe, el operador lo gestionará ahora", "cluster": "demo/cbopedns"}

{"level":"info","ts":1588495709.8903878,"logger":"cluster","msg":"Running","cluster":"demo/cbopedns"}

{"level": "info", "ts":1588495710.0405645, "logger": "couchbaseutil", "msg": "Cluster status", "cluster": "demo/cbopedns", "balance": "unbalanced", "rebalancing":false}

{"level":"info","ts":1588495710.0406282,"logger":"couchbaseutil","msg":"Node status","cluster":"demo/cbopedns","name":"cbopedns-0000","version":"6.5.0","class":"data-east-1a","managed":true,"status":"active"}

{"level":"info","ts":1588495710.0406532,"logger":"couchbaseutil","msg":"Node status","cluster":"demo/cbopedns","name":"cbopedns-0001","version":"6.5.0","class":"data-east-1b","managed":true,"status":"pending_add"}

{"level":"info","ts":1588495710.040662,"logger":"couchbaseutil","msg":"Node status","cluster":"demo/cbopedns","name":"cbopedns-0002","version":"6.5.0","class":"data-east-1c","managed":true,"status":"pending_add"}

{"level":"info","ts":1588495710.0406775,"logger":"scheduler","msg":"Scheduler status","cluster":"demo/cbopedns","name":"cbopedns-0000","class":"data-east-1a","group":"us-east-1a"}

{"level":"info","ts":1588495710.0406868,"logger":"scheduler","msg":"Scheduler status","cluster":"demo/cbopedns","name":"cbopedns-0001","class":"data-east-1b","group":"us-east-1b"}

{"level":"info","ts":1588495710.040695,"logger":"scheduler","msg":"Scheduler status","cluster":"demo/cbopedns","name":"cbopedns-0002","class":"data-east-1c","group":"us-east-1c"}

{"level":"info","ts":1588495755.230221,"logger":"couchbaseutil","msg":"Rebalancing","cluster":"demo/cbopedns","progress":0}

{"level":"info","ts":1588495759.2380211,"logger":"cluster","msg":"Rebalance completed successfully","cluster":"demo/cbopedns"}

{"level":"info","ts":1588495759.286947,"logger":"cluster","msg":"Reconcile completed","cluster":"demo/cbopedns"}

Asegurémonos de comprobar los registros de external-dns para ver si se están creando los registros DNS para los pods de Couchbase.

$ kubectl logs -f external-dns-6f74575d54-fp2wh -n demo time="2020-05-03T08:46:46Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0000.cbdemo.balajiacloud.guru targets=1 ttl=1 type=CNAME zone=c3b835b8ec89e43a2492b62d5d82cc86 time="2020-05-03T08:46:46Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0002.cbdemo.balajiacloud.guru targets=1 ttl=1 type=CNAME zone=c3b835b8ec89e43a2492b62d5d82cc86 time="2020-05-03T08:46:47Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0001.cbdemo.balajiacloud.guru targets=1 ttl=1 type=CNAME zone=c3b835b8ec89e43a2492b62d5d82cc86 time="2020-05-03T08:46:47Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0000.cbdemo.balajiacloud.guru targets=1 ttl=1 type=TXT zone=c3b835b8ec89e43a2492b62d5d82cc86 time="2020-05-03T08:46:47Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0002.cbdemo.balajiacloud.guru targets=1 ttl=1 type=TXT zone=c3b835b8ec89e43a2492b62d5d82cc86 time="2020-05-03T08:46:47Z" level=info msg="Cambiando registro." action=CREATE record=cbopedns-0001.cbdemo.balajiacloud.guru targets=1 ttl=1 type=TXT zone=c3b835b8ec89e43a2492b62d5d82cc86

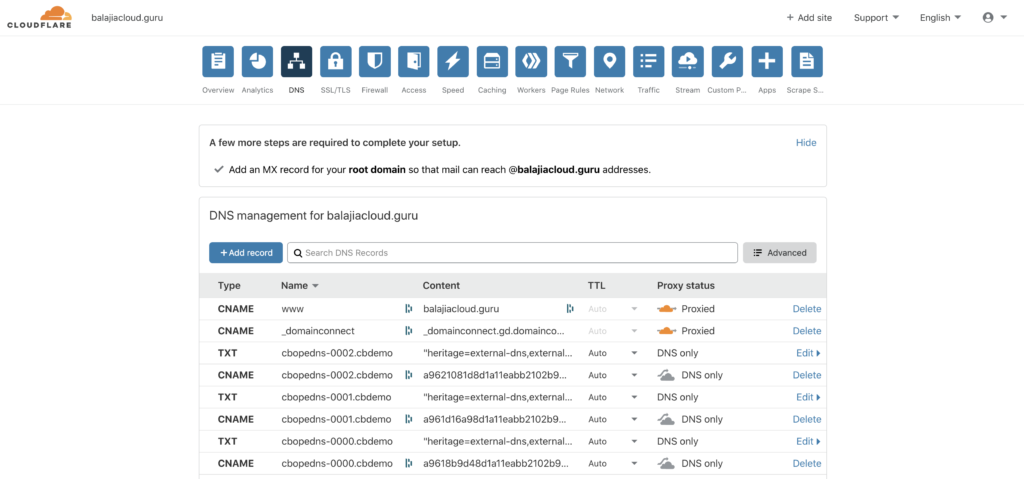

En este punto, también puede comprobar la página DNS accediendo a su Cloudfare cuenta. Puede ver los registros CNAME y TXT añadidos por su proveedor de DNS externo.

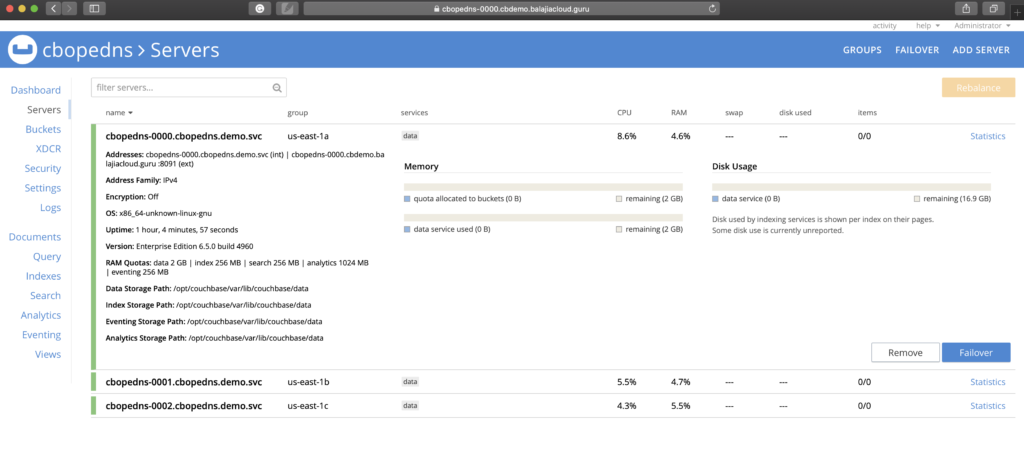

Acceso a la consola web de Couchbase

Ahora, tienes un cluster direccionable públicamente que puedes empezar a usarlo. En el entorno EKS, se puede acceder a la consola web de Couchbase a través de un servicio LoadBalancer expuesto de un pod específico. Debería poder conectarse a la consola de Couchbase utilizando la URL https://cbopedns-0000.cbdemo.balajiacloud.guru:18091/ (sustituya el nombre del pod y el dominio DNS en función de su entorno).

Consulte Acceder a la interfaz de usuario del servidor Couchbase para más detalles sobre cómo conectarse a la consola de Couchbase. También puedes consultar Configurar SDK de cliente para más detalles sobre cómo conectar el SDK cliente con el cluster de Couchbase mientras se usa DNS Based Addressing con DNS Externo.

Conclusión

En este blog, vimos cómo el clúster Couchbase puede ser direccionable públicamente usando Couchbase Operator con Kubernetes External DNS. Hablamos de cómo la solución de DNS externo ayuda a gestionar dinámicamente los registros DNS externos desde dentro de un clúster Kubernetes. En este artículo, hemos utilizado Amazon EKS como nuestro entorno Kubernetes, pero los mismos pasos también serían aplicables si está utilizando otros entornos Kubernetes como AKS, GKE, OpenShift, etc.

Recursos

- Pruébalo: Descargar Couchbase Autonomous Operator 2.0

- Comparta su opinión sobre el Foros de Couchbase

- Documentación:

Gracias Balaji. Esto es útil.

¿Es necesario registrar un nuevo dominio DNS público? Quiero decir, un dominio aws (por ejemplo, ap-sur-1.elb.amazonaws.com) no se puede utilizar, puede ser con un subdominio?