Couchbase anuncia la búsqueda vectorial

Couchbase anuncia la búsqueda vectorial en toda su línea de productos, incluidos Capella, Enterprise Server y Mobile, para permitir la creación de aplicaciones adaptativas impulsadas por IA que se ejecutan en cualquier lugar. ¡Feliz día bisiesto! Y felicidades a todo el equipo de Couchbase por ofrecer estos increíbles productos.

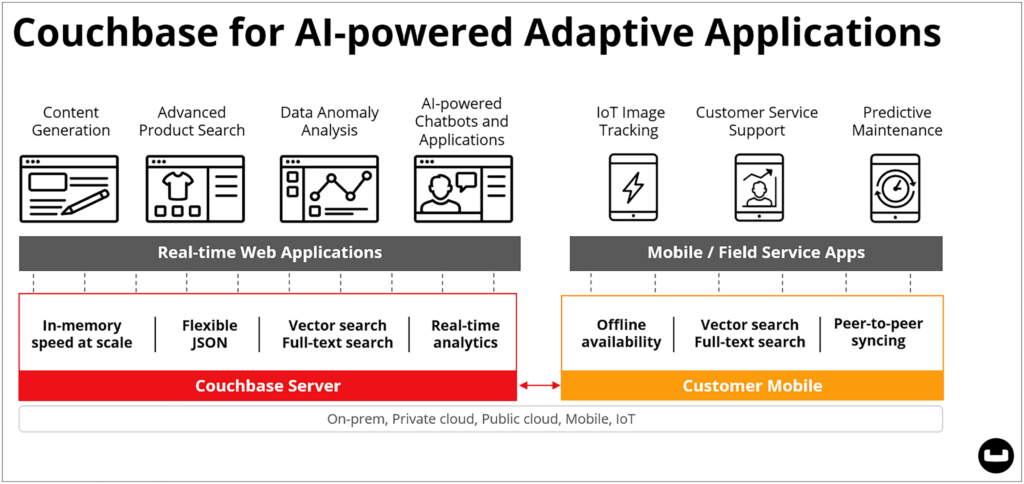

Sí, Couchbase añade búsqueda vectorial a todos sus productos y admite técnicas de generación aumentada de recuperación (RAG) mediante grandes modelos lingüísticos (LLM) vía Cadena LangChain y LlamaIndex interfaces. Esto permite construir aplicaciones hiperpersonalizadas y contextualizadas en tiempo real. Sus aplicaciones podrán adaptarse inmediatamente a las condiciones y situaciones en tiempo real, incluso en sus aplicaciones móviles. Las llamamos aplicaciones adaptativas.

TLDR: Añadir la búsqueda vectorial a las aplicaciones Edge, Cloud y de servidor

-

- Couchbase añade la búsqueda vectorial a nuestra búsqueda nativa servicio de búsqueda en lenguaje natural en Couchbase Enterprise Edition Server 7.6, Capella nuestra base de datos totalmente gestionada, y Couchbase Lite, nuestra base de datos móvil integrable. Estamos llevando la búsqueda vectorial al límite y a los dispositivos, y esto es muy emocionante.

- Couchbase anuncia la compatibilidad con LangChain y LlamaIndex en nuestros SDK de idiomas específicos para impulsar productividad de los desarrolladores en el uso de los modelos GenAI que elijan dentro de su aplicación.

- El uso de técnicas RAG con búsqueda vectorial ayuda a mejorar la precisión de las respuestas de GenAI, reduciendo la ansiedad de que los modelos alucinen y proporcionen respuestas poco fiables a una aplicación impulsada por IA.

- La búsqueda vectorial también ayuda a eliminar la preocupación de las empresas por compartir datos confidenciales o de propiedad exclusiva con los LLM como datos de formación.

- Los desarrolladores dispondrán de soporte completo de búsqueda vectorial en REST API, SDK y SQL++. Podrán aprovechar su larga familiaridad con SQL para desarrollar aplicaciones GenAI de forma rápida y eficaz.

- Esto también responde a la necesidad común de "búsqueda híbrida": combinar la búsqueda por similitud y semántica con búsquedas por rango, espaciales y de texto en una sola petición.

- Somos el primer proveedor que incorpora la búsqueda vectorial a una base de datos móvil.

También hemos añadido una miríada de nuevas capacidades a Capella y Enterprise Server 7.6 (ahora disponible para descargar y Prueba gratuita de Capella) incluyendo:

-

- Compatibilidad con los recorridos de relaciones de tipo gráfico mediante expresiones recursivas de tabla común en SQL++, por lo que ahora es posible navegar por organigramas y jerarquías formadas por colecciones y documentos.

- Reequilibrio de índices basado en archivos. Las reconstrucciones de índices durante un reequilibrio de datos no eran divertidas, así que hemos hecho este 80% más rápido y sencillo.

- Actualización de Couchstore a Magma en un solo paso y sin tiempo de inactividad. Disfrute de las ventajas de capacidad, velocidad y compresión de Magma.

- Tiempos de conmutación por error más rápidos para mejorar la alta disponibilidad y reducir los tiempos mínimos de reacción: 200 ms para la frecuencia de latido y un segundo para la activación automática de la conmutación por error.

- Simplificación de la creación de consultas durante el desarrollo al eliminar la necesidad de índices antes de la ejecución de la consulta.

Vea el vídeo del anuncio:

¿Qué significa el anuncio de Vector Search para los clientes de Couchbase?

Ha sido todo un año para el viaje de Couchbase en la adición de soporte para Inteligencia Artificial Generativa (GenAI) en todos nuestros productos. Como el resto del mundo, pudimos ver desde el lanzamiento inicial de ChatGPT que GenAI iba a transformar el desarrollo de aplicaciones. Proyectamos que casi todas las aplicaciones existentes y futuras serían examinadas para ver si GenAI podía aplicarse a características concretas. Incluso especulamos con que el alcance y la escala de este reexamen de las aplicaciones sería similar al problema del efecto 2000 de hace veinticinco años (sin la inminente fecha límite).

Si la búsqueda vectorial es un concepto nuevo para usted, vea nuestro vídeo de introducción para ponerse al día rápidamente. Siga leyendo a continuación para conocer en detalle por qué consideramos que la búsqueda vectorial es un requisito básico de las aplicaciones.

Apostamos por las aplicaciones adaptativas impulsadas por IA

El año pasado, nos pronunciamos sobre los siguientes principios clave en la creación de aplicaciones basadas en IA. Lara Greden, de IDC, es quien mejor lo ha captado.

JSON es el formato de datos de la IA

Esto se basaba en el entendimiento de que las aplicaciones impulsadas por IA iban a ofrecer experiencias hiperpersonalizadas y contextuales. Pensamos que JSON era el formato perfecto para actualizar dinámicamente los perfiles de cuenta que impulsan la personalización, sin necesidad de grandes cambios de esquema. En noviembre, OpenAI declaró que admitía Modo JSON como formato de datos.

También nos convino que somos una base de datos JSON distribuida de alto rendimiento cuyos clientes pasan a gestionar sus perfiles de cuenta dinámicos en nuestro sistema.

También argumentamos que JSON sería un gran formato para persistir y proporcionar variables de datos rápidas que se ensamblarían mediante programación para interacciones con la IA. Empezamos introduciendo Capella iQnuestro asistente de codificación basado en GenAI para ayudar a los desarrolladores a crear aplicaciones basadas en Couchbase.

Nuestro reto: Hacer frente a los temores de GenAI en la empresa

Cuando empezamos a hablar con analistas, clientes potenciales y clientes sobre sus temores acerca de GenAIdos preocupaciones (acertadamente ilustrado por Deloitte) nos llamó la atención de inmediato:

Compartir datos con modelos lingüísticos

La primera era la preocupación de meterse en problemas por ofrecer datos sensibles o privados a un modelo que luego se entrena con esos conocimientos. A muchos clientes les preocupa perder su ventaja competitiva si un LLM aprende y recuerda sus datos secretos. Caracterizamos esto como "Compartir en exceso sus datos con GenAI". Eso es preocupante. También podría tener implicaciones legales. La búsqueda vectorial ayuda a resolver este problema.

Los modelos de IA pueden estar equivocados o locos

El segundo temor era la preocupación de que GenAI alucinara y devolviera información inexacta o falsa. Las bases de datos prefieren que los datos sean válidos, verdaderos, exactos, fiables, transaccionales, etc. Las bases de datos tienen un sentido de lo correcto o incorrecto que no se puede evitar: hasta el céntimo, o hasta el bit. Esta constatación abrió una caja de Pandora de problemas potenciales, entre ellos:

-

- ¿Confías en los datos que proporcionas a GenAI?

- ¿Qué pasa si construyes avisos GenAI que utilizan múltiples fuentes de datos para diferentes variables en el aviso? ¿Confías en ello?

- ¿Y si el modelo lingüístico alucina y no puedes averiguar qué variable de aviso ha creado la confusión?

- ¿Qué pasaría si pretendiera utilizar su almacén de datos, sus sistemas operativos, sus fuentes en tiempo real, catálogos de metadatos, etc., como sistemas de alimentación para las indicaciones y los modelos de IA?

La IA odia la complejidad de los datos

Nos dimos cuenta de que considerar los usos apropiados de GenAI también obligaría a reexaminar la complejidad de su arquitectura general de datos. Si has seguido los principios de diseño de datos de la última década, sabrás que tienes un montón de bases de datos, movimientos de datos y APIs que examinar.

El uso de cualquier combinación de bases de datos específicas se convertirá en una práctica obsoleta, ya que los riesgos de alimentar los modelos de IA con datos incoherentes o incorrectos serán demasiado elevados. La consolidación de los patrones de acceso a los datos es inevitable. Por ello, el uso de una base de datos base de datos vectorial es miope.

Por eso declaramos que la IA odia la complejidad.

Hay que eliminar la complejidad de la arquitectura de datos

Menos mal que Couchbase es una base de datos multipropósito excepcional que puede ayudarte a limpiar tu arquitectura, acelerar tus aplicaciones y ofrecerte un camino para añadirles IA. ¡Incluso cuando tus aplicaciones son móviles!

A partir de esta versión, Couchbase admite los siguientes patrones de acceso a datos: clave/valor, JSON, SQL, búsqueda (texto, geográfica, vectorial), series temporales, gráficos, análisis y transmisión de eventos, todo en la misma plataforma distribuida. Cada servicio de acceso es escalable de forma independiente, por lo que puede ajustar el rendimiento de su aplicación para un uso óptimo de los recursos de infraestructura y así reducir costes y mantenerlos bajos. También puede desplegar el sistema como un servicio totalmente gestionado (Couchbase Capella), nube autogestionada, en las instalaciones, en el borde, y en el dispositivo.

La complejidad se trasladará a qué y cuántos modelos de IA utilizar

La complejidad va a pasar de la capa de datos a la capa de modelos de IA a medida que veamos una futura explosión de modelos especializados. Ya está ocurriendo. Mañana habrá disponibles miles de modelos de IA creados específicamente y empezaremos a utilizarlos combinados, como hacíamos con las bases de datos en nuestra arquitectura de datos.

Las aplicaciones adaptativas impulsadas por IA necesitarán análisis en tiempo real

En otoño anunciamos Capella columnar para agregaciones a gran escala en tiempo real. Los resultados se pueden insertar en la aplicación e incluso utilizar esos datos para mensajes de inteligencia artificial. Hemos resuelto un viejo problema de volver a escribir una visión analítica en la aplicación sin intervención humana. Esto será importante cuando construyas tu aplicación potenciada por IA, vas a querer contexto en tiempo real como "¿Cuánto inventario hay ahora mismo?".

Las aplicaciones adaptables serán móviles

Por lo tanto, si vas a crear una aplicación impulsada por GenAI, vas a querer ofrecerla allí donde tus usuarios estén mirando. En sus dispositivos móviles. Todas las capacidades, incluida la búsqueda vectorial, pueden almacenarse y accederse localmente en los dispositivos. Aquí es donde viven sus usuarios, donde se producen sus interacciones tecnológicas y donde se origina su contexto en tiempo real. Incluido el contexto como la ubicación, la hora del día, el tiempo, las noticias, la proximidad a los amigos, etc. Los vectores se almacenarán, protegerán y sincronizarán con los dispositivos para que pueda utilizar la similitud y la búsqueda híbrida en la periferia.

Hasta donde sabemos, la búsqueda vectorial en un dispositivo móvil integrable es la primera función de este tipo. Las ventajas serán enormes: conversaciones directas con LLM desde el dispositivo sin tener que hablar con el servidor principal, mayor privacidad, menor latencia, disponibilidad offline y usuarios más satisfechos. Todo ello será necesario en el futuro. Aplicación adaptativa basada en IA.

Los clientes que deseen probar el beta de búsqueda vectorial en Couchbase Lite puede inscribirse aquí.

Su arquitectura de datos debe ser rápida, disponible y estar en todas partes

Cuando pienses en crear tu primera aplicación adaptativa, debes recordar que las viejas reglas de las aplicaciones siguen siendo válidas. Deben ser rápidas, ejecutarse en cualquier lugar, ser fiables, ser escalables y estar disponibles cuando el usuario lo desee. No hay que transigir con los requisitos básicos.

Resumen

Couchbase anuncia la búsqueda vectorial y abre una nueva era en el desarrollo de aplicaciones. Hoy anunciamos que soportamos la búsqueda vectorial en toda nuestra línea de productos, incluyendo el soporte de búsqueda de similitudes vectoriales en dispositivos móviles. Pero es mucho más que eso. Hemos actualizado Couchbase Server a la versión 7.6, que soporta travesías de relaciones gráficas, actualización automática de Couchstore a Magma, reequilibrios de índices más rápidos, ejecución de consultas más sencilla y conmutación por error más rápida en entornos HA.

Couchbase está listo para ayudarte a construir tus aplicaciones adaptativas. ¿Está listo para empezar?

Disfrute de los siguientes recursos

-

- Comunicado de prensa de Vector Search

- Descargar Couchbase Server 7.6

- Prueba gratuita de Capella

- Novedades de Capella y Server 7.6 o ver Nuevo vídeo de lanzamiento

- Lea las notas de la versión cuando estén disponibles

- Más información Búsqueda vectorial en Couchbase

- Regístrate: Couchbase Mobile Vector Search Beta

- Más información Búsqueda vectorial, Incrustación vectorialy RAG

- Vea nuestros nuevos vídeos en Búsqueda vectorial y Vector Couchbase Lite beta

- Inscríbete: Webcast de Couchbase sobre servicios de IA