Etiqueta: LLMs

Libere la IA agenética en tiempo real con agentes de streaming en Confluent Cloud y Couchbase

Estamos encantados de colaborar hoy con Confluent en el anuncio de las nuevas funciones para Streaming Agents en Confluent Cloud y un nuevo motor de contexto en tiempo real.

Creación de agentes de IA listos para la producción con Couchbase y Nebius AI (resumen del seminario web)

Esta combinación de LLM, más las herramientas, la memoria y los objetivos es lo que da a los agentes la capacidad de hacer algo más que generar texto.

Liberar la potencia de AWS Bedrock con Couchbase

En este blog, exploramos cómo el almacén vectorial de Couchbase, cuando se integra con AWS Bedrock, crea una solución de IA potente, escalable y rentable.

Presentación de Model Context Protocol (MCP) Server para Couchbase

Presentamos Couchbase MCP Server: una solución de código abierto para potenciar agentes de IA y aplicaciones GenAI con acceso en tiempo real a tus datos de Couchbase.

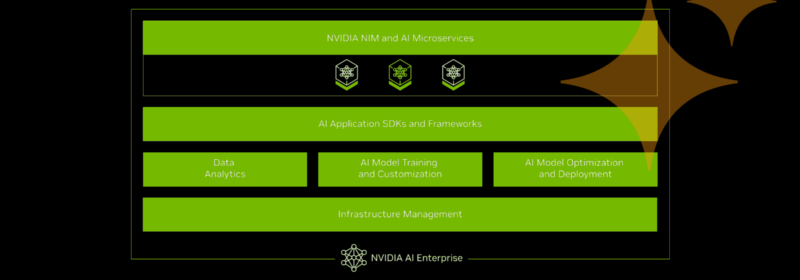

Couchbase y NVIDIA se alían para acelerar el desarrollo de aplicaciones robóticas

Couchbase y NVIDIA se alían para facilitar y agilizar la creación, alimentación y ejecución de aplicaciones agénticas.

Los modelos DeepSeek ya están disponibles en Capella AI Services

DeepSeek-R1 ya está disponible en Capella AI Services. Desbloquea el razonamiento avanzado para la IA empresarial con un menor TCO. 🚀 ¡Regístrese para obtener acceso anticipado!

Una herramienta para facilitar la transición de Oracle PL/SQL a Couchbase JavaScript UDF

Convierte PL/SQL a JavaScript UDFs sin problemas con una herramienta impulsada por IA. Automatice la migración de Oracle PL/SQL a Couchbase con gran precisión mediante ANTLR y LLM.

Integración de la inferencia LLM rápida de Groq con la búsqueda vectorial de Couchbase

Integra la rápida inferencia LLM de Groq con Couchbase Vector Search para aplicaciones RAG eficientes. Compara su velocidad con OpenAI, Gemini y Ollama.

Servicio Modelo Capella: Seguro, escalable y compatible con OpenAI

Capella Model Service le permite desplegar modelos de IA seguros y escalables compatibles con OpenAI. ¡Ahora en Private Preview!

Top Posts

- ¿Qué son los modelos de incrustación? Una visión general

- Explicación del modelado de datos: Conceptual, físico y lógico

- Métodos de análisis de datos: Técnicas cualitativas frente a cuantitativas

- Enterprise Analytics ya está disponible en Microsoft Azure

- ¿Qué es el análisis de datos? Tipos, métodos y herramientas para la investigación

- Ciclo de vida del desarrollo de aplicaciones (fases y modelos de gestión)

- Couchbase Mobile ofrece grandes avances para la creación de...

- ¿Qué son las incrustaciones vectoriales?

- N1QL Y BÚSQUEDA: Aproveche el índice de búsqueda de texto completo (FTS) en N1QL